多元线性回归

本文解释了统计学中的多元线性回归。此外,您还将学习如何创建多元线性回归模型以及如何解释它。

什么是多元线性回归?

多元线性回归是包含两个或多个自变量的回归模型。换句话说,多元线性回归是一种统计模型,允许多个解释变量与响应变量线性相关。

因此,多元线性回归模型用于查找将两个或多个自变量与因变量相关的方程。因此,通过替换每个自变量的值,可以获得因变量的值的近似值。

例如,方程 y=3+6x 1 -4x 2 +7x 3是一个多元线性回归模型,因为它在数学上将三个自变量 (x 1 , x 2 , x 3 ) 与一个因变量 (y) 线性值路径相关联。

多元线性回归公式

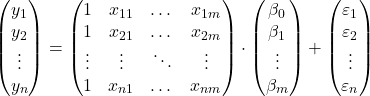

多元线性回归模型的方程为 y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε。

![]()

金子:

-

是因变量。

-

是自变量 i。

-

是多元线性回归方程的常数。

-

是与变量相关的回归系数

。

-

这是误差或残差,即观测值与模型估计值之间的差异。

-

是模型中变量的总数。

所以如果我们有一个样本总共

![]()

观察,我们可以提出矩阵形式的多元线性回归模型:

上面的数组表达式可以通过为每个数组分配一个字母来重写:

![]()

因此,通过应用最小二乘准则,可以得出估计多元线性回归模型系数的公式:

![]()

然而,该公式的应用非常费力且耗时,因此在实践中建议使用可以更快地运行回归模型倍数的计算机软件(例如Minitab或Excel)。

多元线性回归假设

在多元线性回归模型中,必须满足以下条件才能使模型有效:

- 独立性:残基必须彼此独立。确保模型独立性的常见方法是在采样过程中添加随机性。

- 同方差性:残差的方差必须具有同质性,即残差的变异性必须恒定。

- 非多重共线性:模型中包含的解释变量不能相互关联,或者至少它们的关系必须非常弱。

- 正态性:残差必须服从正态分布,换句话说,它们必须服从均值为 0 的正态分布。

- 线性:假设响应变量和解释变量之间的关系是线性的。

解释多元线性回归模型

要解释多元线性回归模型,我们必须查看决定系数(R 平方),它表示回归模型解释的百分比。因此,决定系数越高,模型就越适合研究的数据样本。

然而,统计模型的拟合优度可能会产生误导,特别是在多元线性回归模型中。因为当向模型中添加变量时,即使该变量并不显着,决定系数也会增加。然而,有必要通过尽量减少变量数量来最大化决定系数,因为模型不太复杂并且更容易解释。

为了解决这个问题,有必要计算调整决定系数(调整R平方),它是一个统计系数,衡量回归模型的拟合质量,与未调整系数不同,它对添加到模型中的每个变量进行惩罚的决心。这没有考虑模型中变量的数量。

因此,调整后的决定系数使我们能够比较具有不同变量数量的两个模型的拟合优度。原则上,应该选择调整决定系数较高的模型,但如果两个模型的值非常相似,最好选择变量较少的模型,因为它更容易解释。

相反,回归系数表明解释变量和响应变量之间的关系。如果回归系数为正,则响应变量将随着解释变量的增加而增加。而如果回归系数为负,则当解释变量增加时,响应变量将减少。

从逻辑上讲,为了满足前面的条件,其他变量必须保持不变。这就是为什么模型的不同解释变量之间不存在多重共线性很重要。您可以通过在我们的网站上搜索相应的文章来了解如何研究模型的多重共线性。

多元和简单线性回归

最后,我们将了解简单线性回归模型和多元线性回归模型之间的区别,因为它们是统计学中广泛使用的两种回归模型。

简单线性回归是用于关联自变量的回归模型。所以简单线性回归模型的方程如下:

![]()

因此,多元线性回归和简单线性回归的区别在于解释变量的数量。多元线性回归模型有两个或多个解释变量,而简单线性回归模型只有一个解释变量。

![]()

总之,多元线性回归是简单线性回归的扩展,因为简单地添加了更多解释变量及其各自的回归系数。但是,回归系数的计算方式有所不同,要了解如何完成此操作,请单击此处: