线性回归

本文解释了什么是线性回归以及它在统计学中的用途。此外,您将能够看到如何计算两种类型的线性回归:简单线性回归和多元线性回归。

什么是线性回归?

线性回归是一种将一个或多个自变量与因变量相关联的统计模型。简而言之,线性回归是一种用于查找近似一个或多个解释变量与响应变量之间关系的方程的技术。

例如,方程 y=2+5x 1 -3x 2 +8x 3是一个线性回归模型,因为它在数学上将三个自变量 (x 1 、 x 2 、 x 3 ) 与因变量 (y) 相关联,而且,变量之间的关系是线性的。

线性回归的类型

有两种类型的线性回归:

- 简单线性回归:单个自变量与因变量相关。因此,此类线性回归模型的方程的形式为 y=β 0 +β 1 x 1 。

- 多元线性回归:回归模型有几个解释变量和一个响应变量。因此,此类线性回归模型的方程的形式为 y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m 。

简单线性回归

简单线性回归用于将一个自变量与两个变量相关联。

简单线性回归模型的方程是一条直线,因此它由两个系数组成:方程常数(β 0 )和两个变量之间的相关系数(β 1 )。因此,简单线性回归模型的方程为 y=β 0 +β 1 x。

![]()

简单线性回归系数的计算公式如下:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

金子:

-

是回归线的常数。

-

是回归线的斜率。

-

是数据 i 的自变量 X 的值。

-

是数据 i 的因变量 Y 的值。

-

是自变量值的平均值

-

是因变量 Y 值的平均值。

多元线性回归

在多元线性回归模型中,至少包含两个自变量。换句话说,多元线性回归允许多个解释变量与响应变量线性相关。

多元线性回归模型的方程为 y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε。

![]()

金子:

-

是因变量。

-

是自变量 i。

-

是多元线性回归方程的常数。

-

是与变量相关的回归系数

。

-

是误差或残差,即观测值与模型估计值之间的差异。

-

是模型中变量的总数。

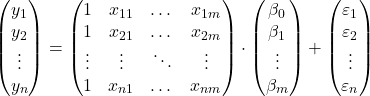

所以如果我们有一个样本总共

![]()

观察,我们可以以矩阵形式提出多元线性回归模型:

上面的矩阵表达式可以通过为每个矩阵分配一个字母来重写:

![]()

因此,通过应用最小二乘准则,我们可以得出估计多元线性回归模型系数的公式:

![]()

然而,该公式的应用非常费力且耗时,这就是为什么在实践中建议使用计算机软件(例如Minitab或Excel),它可以更快地创建多元回归模型。

线性回归假设

在线性回归模型中,必须满足以下条件才能使模型有效:

- 独立性:残基必须彼此独立。确保模型独立性的常见方法是在采样过程中添加随机性。

- 同方差性:残差的方差必须具有同质性,即残差的变异性必须恒定。

- 非多重共线性:模型中包含的解释变量不能相互关联,或者至少它们的关系必须非常弱。

- 正态性:残差必须服从正态分布,换句话说,它们必须服从均值为 0 的正态分布。

- 线性:假设响应变量和解释变量之间的关系是线性的。

线性回归有什么用?

线性回归基本上有两个用途:线性回归用于解释解释变量和响应变量之间的关系,类似地,线性回归用于预测新观察的因变量的值。

通过得到线性回归模型的方程,我们可以知道模型中的变量之间存在什么类型的关系。如果自变量的回归系数为正,则因变量随其增大而增大。如果自变量的回归系数为负,则因变量增大则减小。

另一方面,线性回归计算的方程也允许进行值预测。这样,通过将解释变量的值引入到模型方程中,我们就可以计算出一条新数据的因变量值。