回归系数

本文解释了统计学中的回归系数。因此,您将了解如何计算回归系数以及如何解释其值。

回归系数是多少?

回归系数是与回归模型中每个解释变量相关的值。也就是说,回归系数是回归方程中的解释变量相乘的值,使得每个解释变量对应一个回归系数。

例如,如果回归模型的结果方程为 y=3+2x 1 -7x 2 ,则模型的回归系数为 3、2 和 -7。请注意,方程 (3) 中的常数也被视为回归系数,即使它不乘以任何变量。

![]()

因此,在回归模型中,有多少个解释变量(或自变量)就有多少个回归系数加一,对应于模型方程中的常数。

此外,回归系数表示自变量和因变量之间的关系。例如,如果回归系数为正,则意味着随着自变量的增加,因变量也会增加。然而,两个变量之间的关系并不总是那么直接。下面我们将看到如何解释回归系数。

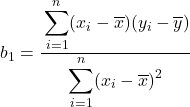

回归系数公式

对于简单线性回归,其方程为:

![]()

模型两个回归系数的计算公式如下:

![]()

您可以在以下链接中看到已解决的计算回归系数的问题:

如果要计算多元线性回归模型的回归系数,最好使用计算机软件,因为公式要复杂得多。

回归系数的解释

现在我们知道了统计学中的回归系数是什么以及它是如何计算的,让我们看看如何解释回归系数。

变量回归系数的解释很简单:如果其余解释变量保持不变,则解释变量的增加将导致因变量的增加或减少,具体取决于其系数的符号是正还是负。积极的。分别为负。 。

因此,如果解释变量的回归系数为正,则意味着该变量与因变量具有正相关性。另一方面,如果系数为负,则意味着自变量和因变量具有负相关性。

然而,如果解释变量之间不存在相互作用,也就是说,当一个解释变量发生变化时,其他变量保持不变,则所有这些都是正确的。否则,需要更详细地分析解释变量和响应变量之间的关系。

要了解更多信息,您可以查阅我们的以下文章:

此外,在分析回归系数时,考虑相应变量是线性还是非线性也很重要。因为如果变量是非线性的,则变量值的变化将对响应变量产生不同的影响。例如,二次变量将负值转换为正值,因此二次变量越负,响应变量越大。

回归系数和决定系数

最后,我们看看回归系数和决定系数有什么区别,因为它们是回归模型中非常重要的两个系数,其含义必须明确。

决定系数 (R 2 )是衡量回归模型拟合优度的统计量。简而言之,决定系数显示了回归模型对数据集的拟合程度。

因此,回归系数与决定系数的区别在于,回归系数表示自变量与因变量之间的关系,而决定系数表示回归模型的拟合优度。 。