如何在 r 中计算 cohen 的 kappa

在统计学中,科恩的 Kappa用于衡量将每个项目划分为互斥类别的两个评分者或法官之间的一致程度。

Cohen 的 kappa 公式计算如下:

k = (p o – p e ) / (1 – p e )

金子:

- p o :评估者之间观察到的相对一致性

- p e :机会一致的假设概率

Cohen 的 Kappa 不是简单地计算评分者同意的项目的百分比,而是尝试解释评分者可能纯属偶然就某些项目达成一致的事实。

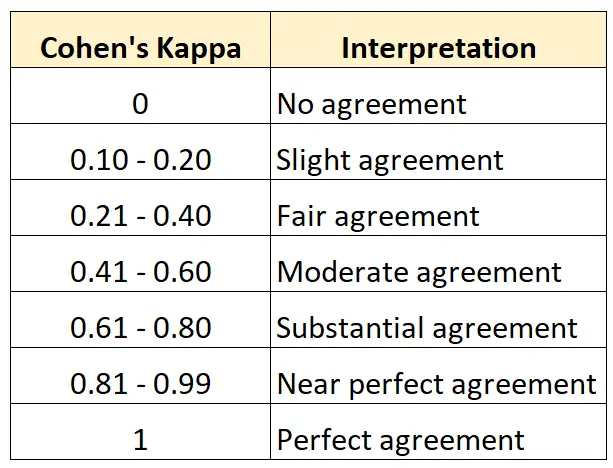

Cohen 的 Kappa 值始终介于 0 和 1 之间,其中:

- 0表示两个评审者之间没有达成一致

- 1表示两个评估者完全一致

下表总结了如何解释 Cohen 的 Kappa 的不同值:

在 R 中计算 Cohen Kappa 的最简单方法是使用psych包中的cohen.kappa()函数。

下面的例子展示了如何在实际中使用这个功能。

示例:计算 R 中的 Cohen Kappa

假设一家艺术博物馆的两名策展人被要求评估 15 幅画作,看看它们是否足以在新展览中展出。

以下代码展示了如何使用psych包的cohen.kappa()函数来计算两个评估者的 Cohen Kappa:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

估计列显示 Cohen’s Kappa 值。

从结果中我们可以看到 Cohen 的 Kappa 为0.34 。

根据上表,我们可以说两位评估者只有“相当”程度的一致。

如果您希望计算三个或更多评估者之间的一致性程度,建议使用 Fleiss’ Kappa。

其他资源

以下教程提供了有关 Cohen 的 Kappa 的其他资源:

科恩的河童简介

在线科恩 Kappa 计算器

如何在 Excel 中计算 Cohen Kappa

如何用 Python 计算 Cohen 的 Kappa