相关性

本文解释了两个变量之间相关性的含义、如何计算相关系数以及存在的不同类型的相关性。此外,还展示了如何解释两个变量之间的相关性值。

什么是相关性?

相关性是一种统计指标,表明两个变量之间的相关程度。更具体地,线性相关用于确定两个不同变量之间的线性相关程度。

当改变一个变量的值也会改变另一个变量的值时,两个变量是链接的。例如,如果增加变量 A 也会增加变量 B,则变量 A 和 B 之间存在相关性。

相关性的类型

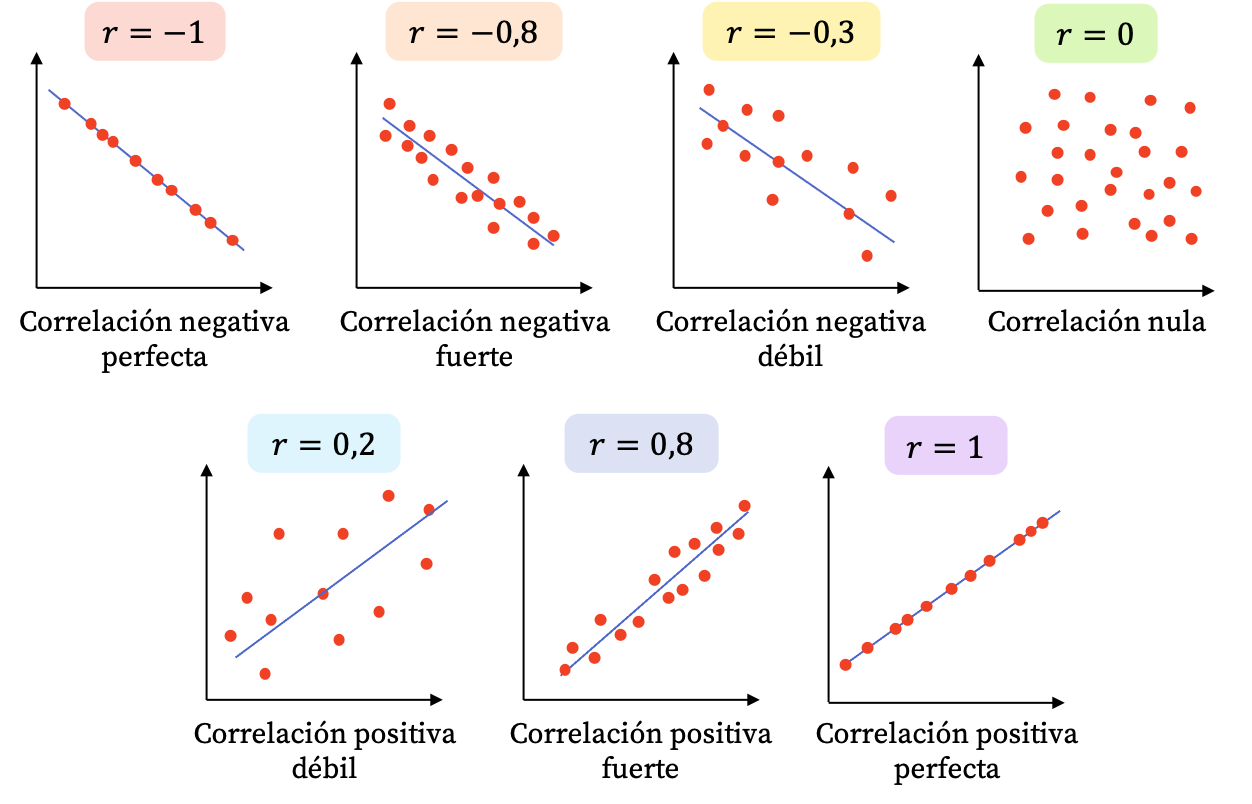

根据两个随机变量之间的关系,可区分以下类型的线性相关:

- 直接相关(或正相关) :一个变量随着另一个变量的增加而增加。

- 逆相关(或负相关) :当一个变量增加时,另一个变量减少,反之亦然,如果一个变量减少,另一个变量增加。

- 零相关(无相关) :两个变量之间没有关系。

请记住,这些是存在的不同类型的线性相关性,但也可能两个变量之间的数学关系不能用直线表示,而是需要使用更复杂的函数,例如寓言。或对数。在这种情况下,这将是非线性相关。

相关系数

考虑到相关性的定义以及存在的不同类型的相关性,让我们看看这个统计值是如何计算的。

相关系数,也称为线性相关系数或皮尔逊相关系数,是两个变量之间的相关值。

两个统计变量的相关系数等于变量的协方差与每个变量的方差乘积的平方根之间的商。因此,相关系数的计算公式如下:

![]()

计算总体的相关系数时,相关符号是希腊字母 ρ。但当相对于样本计算系数时,通常使用字母r作为符号。

相关指数的值可以在-1和+1之间(包括-1和+1)。我们将在下面看到如何解释相关系数的值。

您可以在以下链接中查看如何计算相关系数的具体示例:

请记住,还有其他类型的相关系数,例如 Spearman 或 Kendall 相关系数。但最常见的无疑是皮尔逊相关系数。

解释相关性

相关系数的值可以在-1到+1之间(包括-1和+1)。因此,根据相关系数的值,这意味着两个变量之间的关系是朝一个方向或朝另一个方向。以下是如何解释相关值:

- r=-1 :两个变量具有完美的负相关性,因此我们可以画一条负斜率的线,将所有点连接起来。

- -1<r<0 :两个变量之间的相关性为负,因此当一个变量增加时另一个变量减少。该值越接近-1,变量负相关程度越高。

- r=0 :两个变量之间的相关性很弱,实际上它们之间的线性关系为零。这并不意味着变量是独立的,因为它们可能具有非线性关系。

- 0<r<1 :两个变量之间的相关性为正,值越接近+1,变量之间的相关性越强。在这种情况下,当另一个变量也增加时,一个变量的值往往会增加。

- r=1 :两个变量具有完美的正相关性,即呈正线性关系。

正如您在上面的散点图中看到的,两个变量之间的相关性越强,图表上的点越接近。另一方面,如果点相距很远,则意味着相关性很弱。

请记住,即使两个变量之间存在相关性,也不意味着它们之间存在因果关系,即两个变量之间的相关性并不意味着一个变量的变化是另一个变量变化的原因。多变的。

例如,如果我们发现身体产生两种不同激素之间存在正相关关系,这并不一定意味着一种激素的增加会导致另一种激素的增加。身体可能会产生这两种激素,因为它需要这两种激素来对抗疾病,因此同时增加了这两种激素的水平,在这种情况下,原因就是疾病。为了确定这两种激素之间是否存在因果关系,应该进行更详细的研究。

相关和回归

相关性和回归是两个通常相关的概念,因为两者都用于分析两个变量之间的关系。

相关性是一种量化两个变量之间关系的统计度量,但是回归涉及创建一个允许两个变量相关的方程(如果它是线性回归,它将是一条直线)。

因此,相关性只是为变量之间的关系提供一个数值,而回归可用于尝试预测一个变量相对于另一个变量的值。

一般我们首先通过计算相关系数来分析变量是否相关。如果相关性显着,那么我们对数据集进行回归。

人们经常将相关系数与线性回归中获得的直线斜率值混淆,但它们并不等同。

相关矩阵

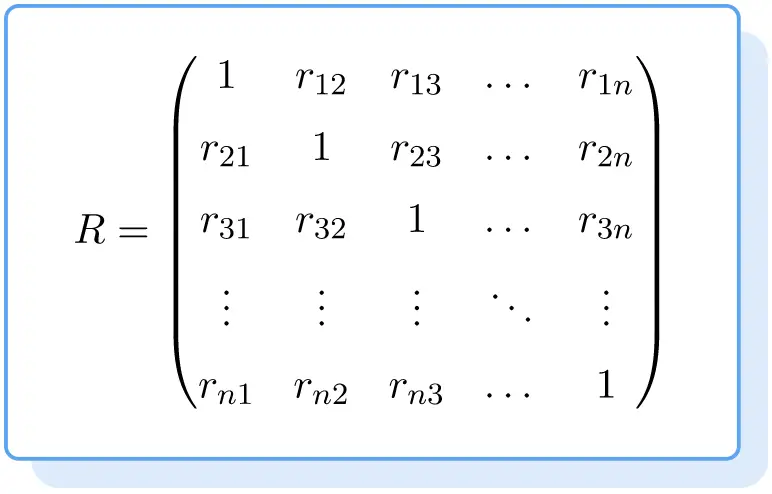

相关矩阵是在位置i,j中包含变量i和j之间的相关系数的矩阵。

因此,相关矩阵是一个主对角线上填满 1 的方阵,第i行j列的元素由变量i和变量j之间的相关系数值组成。

因此,相关矩阵的公式如下:

金子

![]()

是变量之间的相关系数

![]()

和

![]()

相关矩阵对于汇总结果并同时比较多个变量之间的相关性非常有用,因为您可以快速看出哪些关系较强。