Regressionskoeffizienten

In diesem Artikel wird erklärt, was Regressionskoeffizienten in der Statistik sind. Sie erfahren daher, wie Sie einen Regressionskoeffizienten berechnen und seinen Wert interpretieren.

Was ist der Regressionskoeffizient?

Der Regressionskoeffizient ist der Wert, der jeder erklärenden Variablen in einem Regressionsmodell zugeordnet ist. Das heißt, Regressionskoeffizienten sind die Werte, die die erklärenden Variablen in einer Regressionsgleichung multiplizieren, sodass jede erklärende Variable einem Regressionskoeffizienten entspricht.

Wenn die resultierende Gleichung aus einem Regressionsmodell beispielsweise y=3+2x 1 -7x 2 lautet, sind die Regressionskoeffizienten des Modells 3, 2 und -7. Beachten Sie, dass die Konstante in Gleichung (3) auch als Regressionskoeffizient betrachtet wird, auch wenn sie keine Variablen multipliziert.

![]()

Somit gibt es in einem Regressionsmodell so viele Regressionskoeffizienten wie erklärende Variablen (oder unabhängige Variablen) plus eins, was der Konstante in der Modellgleichung entspricht.

Darüber hinaus gibt der Regressionskoeffizient die Beziehung zwischen der unabhängigen Variablen und der abhängigen Variablen an. Wenn beispielsweise ein Regressionskoeffizient positiv ist, bedeutet dies, dass mit zunehmender unabhängiger Variable auch die abhängige Variable zunimmt. Allerdings ist der Zusammenhang zwischen zwei Variablen nicht immer so direkt. Im Folgenden erfahren Sie, wie ein Regressionskoeffizient zu interpretieren ist.

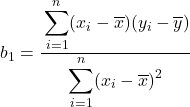

Formel für den Regressionskoeffizienten

Für eine einfache lineare Regression lautet die Gleichung:

![]()

Die Formeln zur Berechnung der beiden Regressionskoeffizienten des Modells lauten wie folgt:

![]()

Ein gelöstes Problem, bei dem Regressionskoeffizienten berechnet werden, können Sie im folgenden Link sehen:

Wenn Sie die Regressionskoeffizienten eines multiplen linearen Regressionsmodells berechnen möchten, verwenden Sie am besten eine Computersoftware, da die Formeln viel komplizierter sind.

Interpretation des Regressionskoeffizienten

Nachdem wir nun wissen, was ein Regressionskoeffizient in der Statistik ist und wie er berechnet wird, wollen wir uns ansehen, wie ein Regressionskoeffizient interpretiert wird.

Die Interpretation eines Regressionskoeffizienten einer Variablen ist einfach: Wenn die übrigen erklärenden Variablen konstant bleiben, führt eine Erhöhung der erklärenden Variablen zu einer Erhöhung oder Verringerung der abhängigen Variablen, je nachdem, ob das Vorzeichen ihres Koeffizienten positiv ist oder positiv. negativ bzw. .

Wenn also ein Regressionskoeffizient einer erklärenden Variablen positiv ist, bedeutet dies, dass diese Variable und die abhängige Variable eine positive Korrelation aufweisen. Ist der Koeffizient hingegen negativ, bedeutet dies, dass die unabhängige Variable und die abhängige Variable eine negative Korrelation aufweisen.

Dies alles trifft jedoch zu, wenn es keine Wechselwirkung zwischen den erklärenden Variablen gibt, das heißt, wenn bei der Variation einer erklärenden Variablen die anderen Variablen konstant bleiben. Andernfalls muss der Zusammenhang zwischen einer erklärenden Variablen und der Antwortvariablen genauer analysiert werden.

Um mehr zu erfahren, können Sie unseren folgenden Artikel lesen:

Darüber hinaus ist es bei der Analyse eines Regressionskoeffizienten wichtig zu berücksichtigen, ob die entsprechende Variable linear oder nichtlinear ist. Denn wenn die Variable nichtlinear ist, wirkt sich eine Änderung des Werts der Variablen unterschiedlich auf die Antwortvariable aus. Beispielsweise wandeln quadratische Variablen negative Werte in positive Werte um. Je negativer eine quadratische Variable ist, desto größer ist die Antwortvariable.

Regressionskoeffizient und Bestimmungskoeffizient

Abschließend werden wir sehen, was der Unterschied zwischen dem Regressionskoeffizienten und dem Bestimmungskoeffizienten ist, da es sich um zwei sehr wichtige Koeffizienten in Regressionsmodellen handelt und ihre Bedeutung klar sein muss.

Das Bestimmtheitsmaß (R 2 ) ist eine Statistik, die die Anpassungsgüte eines Regressionsmodells misst. Vereinfacht ausgedrückt zeigt das Bestimmtheitsmaß, wie gut ein Regressionsmodell zu einem Datensatz passt.

Daher besteht der Unterschied zwischen dem Regressionskoeffizienten und dem Bestimmtheitsmaß darin, dass der Regressionskoeffizient die Beziehung zwischen einer unabhängigen Variablen und der abhängigen Variablen angibt, während das Bestimmtheitsmaß die Anpassungsgüte des Regressionsmodells angibt. .