So berechnen sie cohens kappa in r

In der Statistik wird Cohens Kappa verwendet, um den Grad der Übereinstimmung zwischen zwei Bewertern oder Richtern zu messen, die jedes Element in sich gegenseitig ausschließende Kategorien einteilen.

Die Kappa-Formel von Cohen wird wie folgt berechnet:

k = (p o – p e ) / (1 – p e )

Gold:

- p o : Relative Übereinstimmung zwischen den Bewertern beobachtet

- p e : Hypothetische Wahrscheinlichkeit einer zufälligen Übereinstimmung

Anstatt einfach den Prozentsatz der Punkte zu berechnen, bei denen sich die Bewerter einig sind, versucht Cohens Kappa die Tatsache zu berücksichtigen, dass sich die Bewerter bei einigen Punkten zufällig einig sein können.

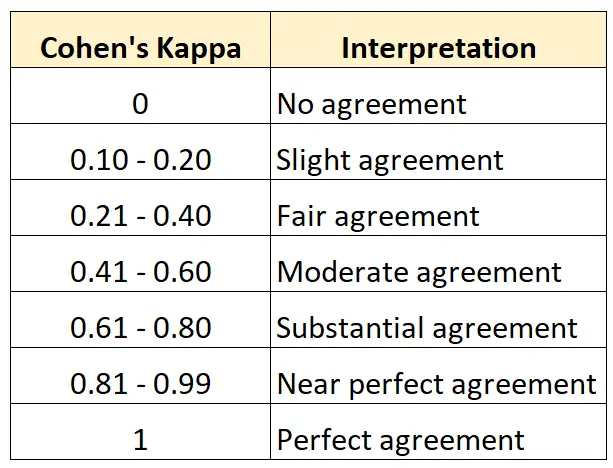

Der Wert von Cohens Kappa liegt immer zwischen 0 und 1, wobei:

- 0 bedeutet, dass zwischen den beiden Gutachtern keine Übereinstimmung besteht

- 1 zeigt eine perfekte Übereinstimmung zwischen den beiden Bewertern an

Die folgende Tabelle fasst zusammen, wie die verschiedenen Werte von Cohens Kappa zu interpretieren sind:

Der einfachste Weg, Cohens Kappa in R zu berechnen, ist die Verwendung der Funktion cohen.kappa() aus dem psych- Paket.

Das folgende Beispiel zeigt, wie Sie diese Funktion in der Praxis nutzen können.

Beispiel: Berechnen Sie Cohens Kappa in R

Angenommen, zwei Kuratoren eines Kunstmuseums werden gebeten, 15 Gemälde zu bewerten, um festzustellen, ob sie gut genug sind, um in einer neuen Ausstellung gezeigt zu werden.

Der folgende Code zeigt, wie die Funktion cohen.kappa() des Pakets psych verwendet wird, um Cohens Kappa für die beiden Bewerter zu berechnen:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

In der Schätzungsspalte wird der Cohen-Kappa-Wert angezeigt.

Aus dem Ergebnis können wir ersehen, dass Cohens Kappa 0,34 beträgt.

Basierend auf der vorherigen Tabelle würden wir sagen, dass die beiden Bewerter nur eine „ziemlich“ große Übereinstimmung hatten.

Wenn Sie den Grad der Übereinstimmung zwischen drei oder mehr Bewertern berechnen möchten, wird empfohlen, stattdessen Fleiss‘ Kappa zu verwenden.

Zusätzliche Ressourcen

Die folgenden Tutorials bieten zusätzliche Ressourcen zu Cohens Kappa:

Einführung in Cohens Kappa

Online-Kappa-Rechner von Cohen

So berechnen Sie Cohens Kappa in Excel

So berechnen Sie Cohens Kappa in Python