Was ist ein „gut“? genauigkeit für maschinelle lernmodelle?

Bei der Verwendung von Klassifizierungsmodellen beim maschinellen Lernen verwenden wir häufig die Metrik Genauigkeit , um die Qualität eines Modells zu bewerten.

Präzision ist einfach der Prozentsatz aller vom Modell korrekt klassifizierten Beobachtungen.

Es wird wie folgt berechnet:

Genauigkeit = (# echte positive Ergebnisse + # echte negative Ergebnisse) / (Gesamtstichprobengröße)

Eine häufig von Studenten gestellte Frage zur Genauigkeit lautet:

Was gilt als „guter“ Wert für die Genauigkeit eines Machine-Learning-Modells?

Obwohl die Genauigkeit eines Modells zwischen 0 % und 100 % variieren kann, gibt es keinen universellen Schwellenwert, anhand dessen wir bestimmen, ob ein Modell eine „gute“ Genauigkeit aufweist oder nicht.

Stattdessen vergleichen wir normalerweise die Genauigkeit unseres Modells mit der eines Referenzmodells.

Ein Basismodell sagt einfach voraus, dass jede Beobachtung in einem Datensatz zur häufigsten Klasse gehört.

In der Praxis kann jedes Klassifizierungsmodell mit höherer Genauigkeit als ein Referenzmodell als „nützlich“ angesehen werden. Je größer jedoch der Genauigkeitsunterschied zwischen unserem Modell und einem Referenzmodell ist, desto besser.

Das folgende Beispiel zeigt, wie man grob bestimmen kann, ob ein Klassifizierungsmodell eine „gute“ Genauigkeit aufweist oder nicht.

Beispiel: Bestimmen, ob ein Modell eine „gute“ Genauigkeit aufweist

Angenommen, wir verwenden ein logistisches Regressionsmodell , um vorherzusagen, ob 400 verschiedene College-Basketballspieler in die NBA eingezogen werden oder nicht.

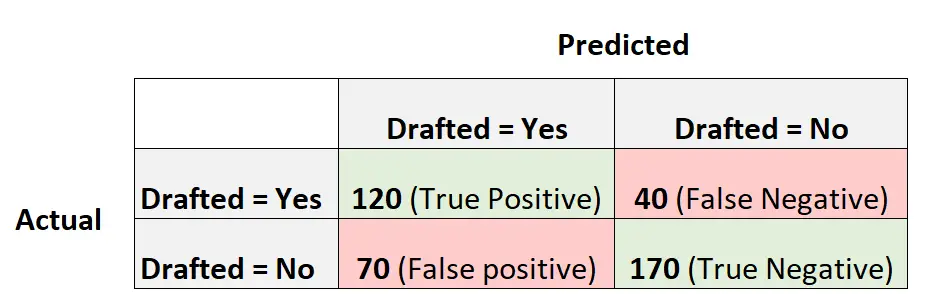

Die folgende Verwirrungsmatrix fasst die vom Modell getroffenen Vorhersagen zusammen:

So berechnen Sie die Genauigkeit dieses Modells:

- Genauigkeit = (# echte positive Ergebnisse + # echte negative Ergebnisse) / (Gesamtstichprobengröße)

- Genauigkeit = (120 + 170) / (400)

- Genauigkeit = 0,725

Das Modell hat das Ergebnis für 72,5 % der Spieler korrekt vorhergesagt.

Um eine Vorstellung davon zu bekommen, ob die Genauigkeit „gut“ ist oder nicht, können wir die Genauigkeit eines Basismodells berechnen.

In diesem Beispiel war das häufigste Ergebnis für Spieler, dass sie nicht gedraftet wurden. Konkret wurden 240 von 400 Spielern nicht gedraftet.

Ein Grundmodell wäre eines, das einfach vorhersagt, dass jeder Spieler nicht gedraftet wird.

Die Genauigkeit dieses Modells würde wie folgt berechnet:

- Genauigkeit = (# echte positive Ergebnisse + # echte negative Ergebnisse) / (Gesamtstichprobengröße)

- Genauigkeit = (0 + 240) / (400)

- Genauigkeit = 0,6

Dieses Grundmodell würde das Ergebnis für 60 % der Spieler korrekt vorhersagen.

In diesem Szenario bietet unser logistisches Regressionsmodell eine deutliche Verbesserung der Genauigkeit gegenüber einem Basismodell, sodass wir unser Modell als zumindest „nützlich“ betrachten.

In der Praxis würden wir wahrscheinlich mehrere verschiedene Klassifizierungsmodelle anpassen und das endgültige Modell als dasjenige auswählen, das im Vergleich zu einem Basismodell den größten Genauigkeitsgewinn bietet.

Vorsichtsmaßnahmen für die Verwendung von Genauigkeit zur Bewertung der Modellleistung

Präzision ist eine häufig verwendete Metrik, da sie leicht zu interpretieren ist.

Wenn wir beispielsweise sagen, dass ein Modell zu 90 % genau ist, wissen wir, dass es 90 % der Beobachtungen korrekt klassifiziert hat.

Die Genauigkeit berücksichtigt jedoch nicht die Verteilung der Daten.

Nehmen wir zum Beispiel an, dass 90 % aller Spieler nicht in die NBA eingezogen werden. Wenn wir ein Modell hätten, das einfach vorhersagt, dass jeder Spieler nicht gedraftet wird, würde das Modell das Ergebnis für 90 % der Spieler korrekt vorhersagen.

Dieser Wert erscheint hoch, aber das Modell ist tatsächlich nicht in der Lage, korrekt vorherzusagen, welche Spieler gedraftet werden.

Eine häufig verwendete alternative Metrik heißt F1-Score und berücksichtigt die Verteilung der Daten.

Wenn die Daten beispielsweise stark unausgeglichen sind (z. B. 90 % aller Spieler sind ungedraftet und 10 % sind es), dann liefert der F1-Score eine bessere Beurteilung der Leistung des Modells.

Erfahren Sie hier mehr über die Unterschiede zwischen Genauigkeit und F1-Ergebnis.

Zusätzliche Ressourcen

Die folgenden Tutorials bieten zusätzliche Informationen zu Metriken, die in Klassifizierungsmodellen für maschinelles Lernen verwendet werden:

Was ist ausgewogene Genauigkeit?

Was gilt als „gutes“ F1-Ergebnis?