Heteroskedastizität

In diesem Artikel wird erklärt, was Heteroskedastizität in der Statistik ist. Darüber hinaus erfahren Sie, was Heteroskedastizität verursacht, welche Folgen sie hat und wie man sie beheben kann.

Was ist Heteroskedastizität?

In der Statistik ist Heteroskedastizität ein Merkmal, das ein Regressionsmuster darstellt, das impliziert, dass die Fehlervarianz nicht konstant ist. Mit anderen Worten bedeutet ein heteroskedastisches Modell, dass seine Fehler eine unregelmäßige Varianz aufweisen. Dann wird das Modell als heteroskedastisch bezeichnet.

Denken Sie daran, dass der Fehler (oder das Residuum) als die Differenz zwischen dem tatsächlichen Wert und dem vom Regressionsmodell geschätzten Wert definiert ist.

![]()

Beim Erstellen eines Regressionsmodells wird der Fehler jeder Beobachtung mithilfe des vorherigen Ausdrucks berechnet. Ein statistisches Modell ist also heteroskedastisch, wenn die Varianz der berechneten Fehler über die Beobachtungen hinweg nicht konstant ist, sondern vielmehr variiert.

Obwohl es sehr einfach erscheinen mag, ist es wichtig, dass ein Regressionsmodell keine Heteroskedastizität aufweist, da die Berechnung des Modells auf der Tatsache basiert, dass die Varianz der Residuen konstant ist, tatsächlich ist es diejenige der vorherigen Annahmen von die Regressionsmodelle.

Es gibt bestimmte statistische Tests, mit denen Heteroskedastizität festgestellt werden kann, beispielsweise der White-Test oder der Goldfeld-Quandt-Test. Normalerweise kann jedoch durch die grafische Darstellung der Residuen ihre Heteroskedastizität identifiziert werden.

Ursachen der Heteroskedastizität

Die häufigsten Ursachen für Heteroskedastizität in einem Modell sind:

- Wenn der Datenbereich im Vergleich zum Durchschnitt sehr groß ist. Wenn in derselben statistischen Stichprobe sehr große und sehr kleine Werte vorhanden sind, ist das erhaltene Regressionsmodell wahrscheinlich heteroskedastisch.

- Auch das Weglassen von Variablen im Regressionsmodell führt zu Heteroskedastizität. Wenn eine relevante Variable nicht im Modell enthalten ist, wird logischerweise ihre Variation in die Residuen einbezogen und dies wird nicht unbedingt behoben.

- Ebenso kann eine Änderung der Struktur zu einer schlechten Anpassung des Modells an den Datensatz führen und daher ist die Varianz der Residuen möglicherweise nicht konstant.

- Wenn einige Variablen viel größere Werte als die anderen erklärenden Variablen haben, weist das Modell möglicherweise Heteroskedastizität auf. In diesem Fall können die Variablen relativiert werden, um das Problem zu lösen.

In einigen Fällen ist jedoch von Natur aus wahrscheinlich, dass sie Heteroskedastizität aufweisen. Wenn wir beispielsweise das Einkommen einer Person anhand ihrer Lebensmittelausgaben modellieren, weisen wohlhabendere Menschen eine viel größere Variabilität ihrer Lebensmittelausgaben auf als ärmere Menschen. Denn ein reicher Mensch isst manchmal in teuren Restaurants und ein anderes Mal in billigen Restaurants, im Gegensatz zu einem armen Menschen, der immer in billigen Restaurants isst. Daher ist es für das Regressionsmodell leicht, Heteroskedastizität zu besitzen.

Folgen der Heteroskedastizität

Die Konsequenzen der Heteroskedastizität in einem Regressionsmodell sind im Wesentlichen folgende:

- Die Effizienz geht beim Kleinste-Quadrate-Schätzer verloren, der als Mittelwert der Fehlerquadrate definiert ist.

- Bei der Berechnung der Kovarianzmatrix der Kleinste-Quadrate-Schätzer treten Fehler auf.

Korrekte Heteroskedastizität

Wenn das resultierende Regressionsmodell heteroskedastisch ist, können wir die folgenden Korrekturen versuchen, um Heteroskedastizität zu erhalten:

- Berechnen Sie den natürlichen Logarithmus der unabhängigen Variablen. Dies ist im Allgemeinen nützlich, wenn die Varianz der Residuen im Diagramm zunimmt.

- Abhängig vom Residuendiagramm kann eine andere Art der Transformation der unabhängigen Variablen praktischer sein. Wenn der Graph beispielsweise die Form einer Parabel hat, können wir das Quadrat der unabhängigen Variablen berechnen und diese Variable zum Modell hinzufügen.

- Für das Modell können auch andere Variablen verwendet werden; Durch Entfernen oder Hinzufügen einer Variablen kann die Varianz der Residuen geändert werden.

- Anstelle des Kriteriums der kleinsten Quadrate kann auch das gewichtete Kriterium der kleinsten Quadrate verwendet werden.

Heteroskedastizität und Homoskedastizität

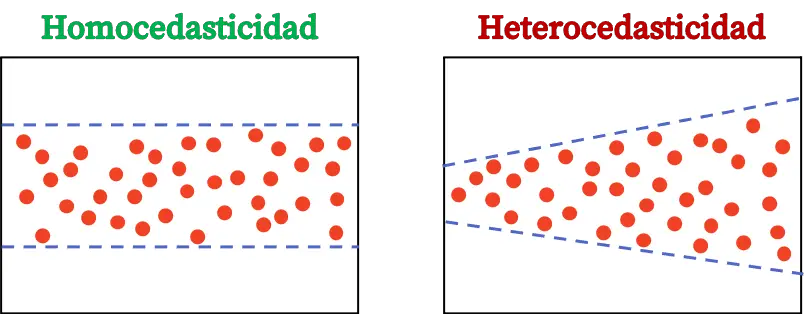

Abschließend werden wir sehen, was die Unterschiede zwischen Heteroskedastizität und Homoskedastizität in der Statistik sind, da es sich hierbei um zwei Konzepte von Regressionsmodellen handelt, über die wir uns im Klaren sein müssen.

Die Homoskedastizität eines Regressionsmodells ist ein statistisches Merkmal, das angibt, dass die Fehlervarianz konstant ist. Ein homoskedastisches Modell bedeutet also, dass die Varianz seiner Fehler konstant ist.

Der Unterschied zwischen Heteroskedastizität und Homoskedastizität liegt in der Konstanz der Varianz der Residuen. Wenn die Varianz der Residuen eines Modells nicht konstant ist, bedeutet dies, dass das Modell heteroskedastisch ist. Wenn andererseits die Varianz der Residuen konstant ist, bedeutet dies, dass sie homoskedastisch ist.

Daher müssen wir sicherstellen, dass das von uns erstellte Regressionsmodell homoskedastisch ist. Auf diese Weise wird die Annahme erfüllt, dass die Varianz der Residuen konstant ist.