Eine einführung in klassifizierungs- und regressionsbäume

Wenn die Beziehung zwischen einem Satz von Prädiktorvariablen und einer Antwortvariablen linear ist, können Methoden wie die multiple lineare Regression genaue Vorhersagemodelle erstellen.

Wenn jedoch die Beziehung zwischen einer Reihe von Prädiktoren und einer Antwort stark nichtlinear und komplex ist, können nichtlineare Methoden möglicherweise eine bessere Leistung erbringen.

Ein Beispiel für eine nichtlineare Methode sind Klassifizierungs- und Regressionsbäume , oft mit CART abgekürzt.

Wie der Name schon sagt, verwenden CART-Modelle eine Reihe von Prädiktorvariablen, um Entscheidungsbäume zu erstellen, die den Wert einer Antwortvariablen vorhersagen.

Angenommen, wir haben einen Datensatz, der die Prädiktorvariablen „ Gespielte Jahre“ und „Durchschnittliche Home Runs“ sowie die Antwortvariable „Jahresgehalt“ für Hunderte von professionellen Baseballspielern enthält.

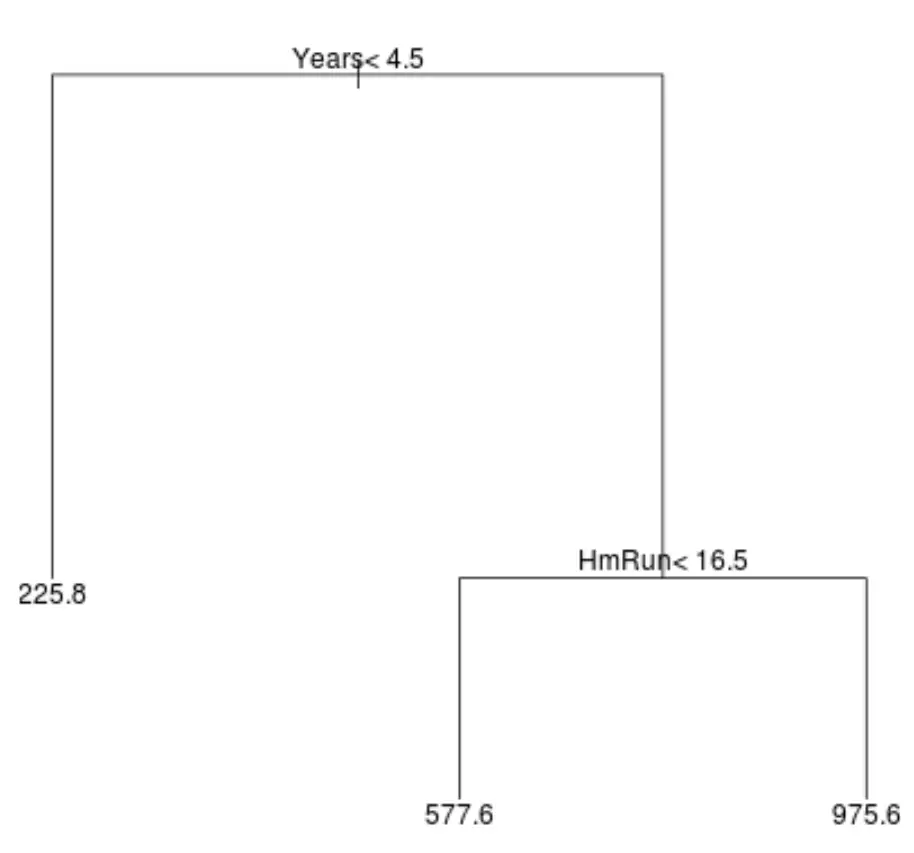

So könnte ein Regressionsbaum für diesen Datensatz aussehen:

Der Baum lässt sich wie folgt interpretieren:

- Spieler, die weniger als 4,5 Jahre gespielt haben, haben ein voraussichtliches Gehalt von 225,8.000 US-Dollar.

- Spieler, die mehr als 4,5 Jahre oder länger gespielt haben und im Durchschnitt weniger als 16,5 Homeruns absolviert haben, haben ein voraussichtliches Gehalt von 577,6.000 US-Dollar.

- Spieler mit 4,5 Jahren oder mehr Spielerfahrung und durchschnittlich 16,5 Homeruns oder mehr haben ein erwartetes Gehalt von 975,6.000 $.

Die Ergebnisse dieses Modells sollten intuitiv Sinn machen: Spieler mit mehr Jahren Erfahrung und durchschnittlicheren Homeruns verdienen tendenziell höhere Gehälter.

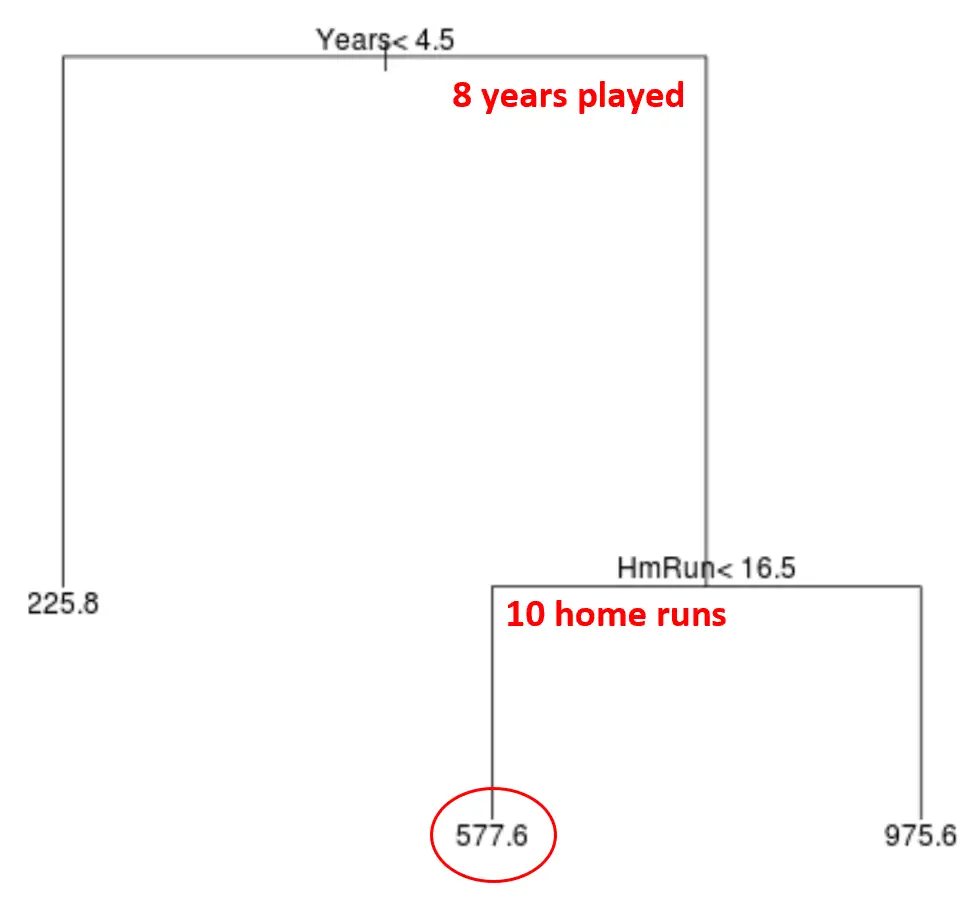

Mithilfe dieses Modells können wir dann das Gehalt eines neuen Spielers vorhersagen.

Nehmen wir zum Beispiel an, dass ein bestimmter Spieler 8 Jahre lang gespielt hat und durchschnittlich 10 Homeruns pro Jahr erzielt. Nach unserem Modell würden wir vorhersagen, dass dieser Spieler ein Jahresgehalt von 577,6.000 $ hat.

Einige Bemerkungen zum Baum:

- Die erste Vorhersagevariable an der Spitze des Baums ist die wichtigste, d. h. diejenige, die den größten Einfluss auf die Vorhersage des Wertes der Antwortvariablen hat. In diesem Fall sagen die gespielten Jahre das Gehalt besser voraus als der Durchschnitt der Kreise .

- Die Bereiche am unteren Rand des Baums werden Blattknoten genannt. Dieser spezielle Baum hat drei Endknoten.

Schritte zum Erstellen von CART-Modellen

Mit den folgenden Schritten können wir ein CART-Modell für einen bestimmten Datensatz erstellen:

Schritt 1: Verwenden Sie die rekursive binäre Aufteilung, um einen großen Baum auf den Trainingsdaten zu erstellen.

Zuerst verwenden wir einen gierigen Algorithmus namens rekursive binäre Aufteilung, um einen Regressionsbaum mit der folgenden Methode zu erstellen:

- Betrachten Sie alle Prädiktorvariablen (X 1 , X 2 , … , Reststandardfehler) als die niedrigsten. .

- Für Klassifizierungsbäume wählen wir den Prädiktor und den Schnittpunkt so aus, dass der resultierende Baum die niedrigste Klassifizierungsfehlerrate aufweist.

- Wiederholen Sie diesen Vorgang und stoppen Sie ihn erst, wenn jeder Endknoten weniger als eine bestimmte Mindestanzahl an Beobachtungen hat.

Dieser Algorithmus ist gierig , weil er bei jedem Schritt des Baumbildungsprozesses die beste Aufteilung nur auf der Grundlage dieses Schritts bestimmt, anstatt in die Zukunft zu blicken und eine Aufteilung zu wählen, die in einer zukünftigen Phase zu einem besseren globalen Baum führen wird.

Schritt 2: Wenden Sie die Kostenkomplexitätsbeschneidung auf den großen Baum an, um eine Sequenz der besten Bäume basierend auf α zu erhalten.

Sobald wir den großen Baum gewachsen haben, müssen wir ihn mit einer Methode beschneiden , die als komplexes Beschneiden bekannt ist und wie folgt funktioniert:

- Finden Sie für jeden möglichen Baum mit T-Endknoten den Baum, der RSS + α|T| minimiert.

- Beachten Sie, dass Bäume mit mehr Endknoten bestraft werden, wenn wir den Wert von α erhöhen. Dadurch wird sichergestellt, dass der Baum nicht zu komplex wird.

Dieser Prozess führt zu einer Folge der besten Bäume für jeden Wert von α.

Schritt 3: Verwenden Sie eine k-fache Kreuzvalidierung, um α auszuwählen .

Sobald wir den besten Baum für jeden Wert von α gefunden haben, können wir eine k-fache Kreuzvalidierung anwenden, um den Wert von α auszuwählen, der den Testfehler minimiert.

Schritt 4: Wählen Sie die endgültige Vorlage.

Schließlich wählen wir das endgültige Modell aus, das dem gewählten Wert von α entspricht.

Vor- und Nachteile von CART-Modellen

CART-Modelle bieten folgende Vorteile :

- Sie sind leicht zu interpretieren.

- Sie sind leicht zu erklären.

- Sie sind leicht zu visualisieren.

- Sie können sowohl auf Regressions- als auch auf Klassifikationsprobleme angewendet werden.

CART-Modelle haben jedoch folgende Nachteile:

- Ihre Vorhersagegenauigkeit ist tendenziell nicht so hoch wie bei anderen nichtlinearen Algorithmen für maschinelles Lernen. Durch die Clusterung vieler Entscheidungsbäume mit Methoden wie Bagging, Boosting und Random Forests kann jedoch ihre Vorhersagegenauigkeit verbessert werden.

Verwandte Themen: So passen Sie Klassifizierungs- und Regressionsbäume in R an