Lineare regression

In diesem Artikel wird erklärt, was lineare Regression ist und wofür sie in der Statistik verwendet wird. Darüber hinaus können Sie sehen, wie die beiden Arten der linearen Regression berechnet werden: einfache lineare Regression und multiple lineare Regression.

Was ist lineare Regression?

Die lineare Regression ist ein statistisches Modell, das eine oder mehrere unabhängige Variablen mit einer abhängigen Variablen in Beziehung setzt. Einfach ausgedrückt ist die lineare Regression eine Technik, mit der eine Gleichung gefunden wird, die die Beziehung zwischen einer oder mehreren erklärenden Variablen und einer Antwortvariablen annähert.

Beispielsweise ist die Gleichung y=2+5x 1 -3x 2 +8x 3 ein lineares Regressionsmodell, da sie drei unabhängige Variablen (x 1 , x 2 , x 3 ) mathematisch mit einer abhängigen Variablen (y) in Beziehung setzt und darüber hinaus die Beziehung zwischen den Variablen ist linear.

Arten der linearen Regression

Es gibt zwei Arten der linearen Regression :

- Einfache lineare Regression : Eine einzelne unabhängige Variable wird mit einer abhängigen Variablen verknüpft. Die Gleichung für diese Art von linearem Regressionsmodell hat daher die Form y=β 0 +β 1 x 1 .

- Multiple lineare Regression : Das Regressionsmodell verfügt über mehrere erklärende Variablen und eine Antwortvariable. Daher hat die Gleichung für diese Art von linearem Regressionsmodell die Form y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m .

einfache lineare Regression

Eine einfache lineare Regression wird verwendet, um eine unabhängige Variable mit beiden Variablen in Beziehung zu setzen.

Die Gleichung eines einfachen linearen Regressionsmodells ist eine Gerade und besteht daher aus zwei Koeffizienten: der Konstante der Gleichung (β 0 ) und dem Korrelationskoeffizienten zwischen den beiden Variablen (β 1 ). Daher lautet die Gleichung für ein einfaches lineares Regressionsmodell y=β 0 +β 1 x.

![]()

Die Formeln zur Berechnung einfacher linearer Regressionskoeffizienten lauten wie folgt:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

Gold:

-

ist die Konstante der Regressionsgeraden.

-

ist die Steigung der Regressionsgeraden.

-

ist der Wert der unabhängigen Variablen X der Daten i.

-

ist der Wert der abhängigen Variablen Y der Daten i.

-

ist der Durchschnitt der Werte der unabhängigen Variablen

-

ist der Durchschnitt der Werte der abhängigen Variablen Y.

Multiple lineare Regression

In einem multiplen linearen Regressionsmodell sind mindestens zwei unabhängige Variablen enthalten. Mit anderen Worten ermöglicht die multiple lineare Regression die lineare Verknüpfung mehrerer erklärender Variablen mit einer Antwortvariablen.

Die Gleichung für ein multiples lineares Regressionsmodell lautet y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Gold:

-

ist die abhängige Variable.

-

ist die unabhängige Variable i.

-

ist die Konstante der multiplen linearen Regressionsgleichung.

-

ist der mit der Variablen verbundene Regressionskoeffizient

.

-

ist der Fehler oder das Residuum, also die Differenz zwischen dem beobachteten Wert und dem vom Modell geschätzten Wert.

-

ist die Gesamtzahl der Variablen im Modell.

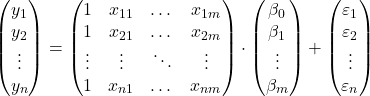

Wenn wir also eine Stichprobe mit insgesamt haben

![]()

Beobachtungen können wir das multiple lineare Regressionsmodell in Matrixform darstellen:

Der obige Matrixausdruck kann umgeschrieben werden, indem jeder Matrix ein Buchstabe zugewiesen wird:

![]()

Durch Anwendung des Kriteriums der kleinsten Quadrate können wir also zu der Formel zur Schätzung der Koeffizienten eines multiplen linearen Regressionsmodells gelangen:

![]()

Allerdings ist die Anwendung dieser Formel sehr mühsam und zeitaufwändig, weshalb in der Praxis die Verwendung von Computersoftware (wie Minitab oder Excel) empfohlen wird, mit der sich ein multiples Regressionsmodell wesentlich schneller erstellen lässt.

Annahmen zur linearen Regression

In einem linearen Regressionsmodell müssen die folgenden Bedingungen erfüllt sein, damit das Modell gültig ist:

- Unabhängigkeit : Die Residuen müssen unabhängig voneinander sein. Eine gängige Methode zur Sicherstellung der Modellunabhängigkeit besteht darin, dem Stichprobenverfahren Zufälligkeit hinzuzufügen.

- Homoskedastizität : Die Varianzen der Residuen müssen homogen sein, d. h. die Variabilität der Residuen muss konstant sein.

- Nicht-Multikollinearität : Die im Modell enthaltenen erklärenden Variablen können nicht miteinander verknüpft werden oder ihre Beziehung muss zumindest sehr schwach sein.

- Normalität : Die Residuen müssen normalverteilt sein, d. h. sie müssen einer Normalverteilung mit einem Mittelwert von 0 folgen.

- Linearität : Es wird angenommen, dass die Beziehung zwischen der Antwortvariablen und den erklärenden Variablen linear ist.

Wozu dient die lineare Regression?

Die lineare Regression hat grundsätzlich zwei Verwendungszwecke: Die lineare Regression wird verwendet, um die Beziehung zwischen den erklärenden Variablen und der Antwortvariablen zu erklären, und in ähnlicher Weise wird die lineare Regression verwendet, um den Wert der abhängigen Variablen für eine neue Beobachtung vorherzusagen.

Indem wir die Gleichung des linearen Regressionsmodells erhalten, können wir wissen, welche Art von Beziehung zwischen den Variablen im Modell besteht. Wenn der Regressionskoeffizient einer unabhängigen Variablen positiv ist, nimmt die abhängige Variable zu, wenn sie zunimmt. Wenn hingegen der Regressionskoeffizient einer unabhängigen Variablen negativ ist, nimmt die abhängige Variable ab, wenn sie zunimmt.

Andererseits erlaubt die in der linearen Regression berechnete Gleichung auch Wertvorhersagen. Indem wir also die Werte der erklärenden Variablen in die Modellgleichung einführen, können wir den Wert der abhängigen Variablen für ein neues Datenelement berechnen.