Multiple lineare regression

In diesem Artikel wird erklärt, was multiple lineare Regression in der Statistik ist. Darüber hinaus erfahren Sie, wie Sie ein multiples lineares Regressionsmodell erstellen und wie es interpretiert wird.

Was ist multiple lineare Regression?

Bei der multiplen linearen Regression handelt es sich um ein Regressionsmodell, das zwei oder mehr unabhängige Variablen umfasst. Mit anderen Worten handelt es sich bei der multiplen linearen Regression um ein statistisches Modell, das die lineare Verknüpfung mehrerer erklärender Variablen mit einer Antwortvariablen ermöglicht.

Daher wird ein multiples lineares Regressionsmodell verwendet, um eine Gleichung zu finden, die zwei oder mehr unabhängige Variablen mit einer abhängigen Variablen in Beziehung setzt. Durch Ersetzen des Werts jeder unabhängigen Variablen wird somit eine Näherung des Werts der abhängigen Variablen erhalten.

Beispielsweise ist die Gleichung y=3+6x 1 -4x 2 +7x 3 ein multiples lineares Regressionsmodell, da sie drei unabhängige Variablen (x 1 , x 2 , x 3 ) mathematisch mit einem linearen Wertepfad einer abhängigen Variablen (y) in Beziehung setzt .

Formel für die multiple lineare Regression

Die Gleichung für ein multiples lineares Regressionsmodell lautet y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Gold:

-

ist die abhängige Variable.

-

ist die unabhängige Variable i.

-

ist die Konstante der multiplen linearen Regressionsgleichung.

-

ist der mit der Variablen verbundene Regressionskoeffizient

.

-

Dabei handelt es sich um den Fehler bzw. Residuum, also um die Differenz zwischen dem beobachteten Wert und dem vom Modell geschätzten Wert.

-

ist die Gesamtzahl der Variablen im Modell.

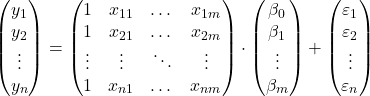

Wenn wir also eine Stichprobe mit insgesamt haben

![]()

Beobachtungen können wir das multiple lineare Regressionsmodell in Matrixform vorschlagen:

Der obige Array-Ausdruck kann umgeschrieben werden, indem jedem Array ein Buchstabe zugewiesen wird:

![]()

Somit ist es durch Anwendung des Kriteriums der kleinsten Quadrate möglich, zur Formel zur Schätzung der Koeffizienten eines multiplen linearen Regressionsmodells zu gelangen:

![]()

Die Anwendung dieser Formel ist jedoch sehr mühsam und zeitaufwändig, daher empfiehlt es sich in der Praxis, Computersoftware (wie Minitab oder Excel) zu verwenden, mit der ein Regressionsmodell viel schneller ausgeführt werden kann.

Annahmen mehrerer linearer Regressionen

In einem multiplen linearen Regressionsmodell müssen die folgenden Bedingungen erfüllt sein, damit das Modell gültig ist:

- Unabhängigkeit : Die Residuen müssen unabhängig voneinander sein. Eine gängige Methode zur Sicherstellung der Modellunabhängigkeit besteht darin, dem Stichprobenverfahren Zufälligkeit hinzuzufügen.

- Homoskedastizität : Die Varianzen der Residuen müssen homogen sein, d. h. die Variabilität der Residuen muss konstant sein.

- Nicht-Multikollinearität : Die im Modell enthaltenen erklärenden Variablen können nicht miteinander verknüpft werden oder ihre Beziehung muss zumindest sehr schwach sein.

- Normalität : Die Residuen müssen normalverteilt sein, d. h. sie müssen einer Normalverteilung mit einem Mittelwert von 0 folgen.

- Linearität : Es wird angenommen, dass die Beziehung zwischen der Antwortvariablen und den erklärenden Variablen linear ist.

Interpretation eines multiplen linearen Regressionsmodells

Um ein multiples lineares Regressionsmodell zu interpretieren, müssen wir uns das Bestimmtheitsmaß (R-Quadrat) ansehen, das den durch das Regressionsmodell erklärten Prozentsatz ausdrückt. Je höher also das Bestimmtheitsmaß, desto stärker wird das Modell an die untersuchte Datenstichprobe angepasst.

Allerdings kann die Anpassungsgüte eines statistischen Modells irreführend sein, insbesondere bei mehreren linearen Regressionsmodellen. Denn wenn man dem Modell eine Variable hinzufügt, erhöht sich das Bestimmtheitsmaß, auch wenn die Variable nicht signifikant ist. Es ist jedoch notwendig, den Bestimmtheitskoeffizienten zu maximieren, indem versucht wird, die Anzahl der Variablen zu minimieren, da das Modell weniger kompliziert und einfacher zu interpretieren ist.

Um dieses Problem zu lösen, muss der angepasste Bestimmtheitskoeffizient (angepasstes R-Quadrat) berechnet werden. Hierbei handelt es sich um einen statistischen Koeffizienten, der die Qualität der Anpassung eines Regressionsmodells misst und im Gegensatz zum nicht angepassten Koeffizienten jede zum Modell hinzugefügte Variable bestraft der Entschlossenheit. Dabei wird die Anzahl der Variablen im Modell nicht berücksichtigt.

Das angepasste Bestimmtheitsmaß ermöglicht es uns also, die Anpassungsgüte zweier Modelle mit einer unterschiedlichen Anzahl von Variablen zu vergleichen. Prinzipiell sollte man das Modell wählen, das ein höheres angepasstes Bestimmtheitsmaß hat, aber wenn die beiden Modelle sehr ähnliche Werte haben, ist es besser, das Modell mit weniger Variablen zu wählen, weil es einfacher zu interpretieren ist.

Im Gegensatz dazu geben Regressionskoeffizienten die Beziehung zwischen der erklärenden Variablen und der Antwortvariablen an. Wenn der Regressionskoeffizient positiv ist, nimmt die Antwortvariable zu, wenn die erklärende Variable zunimmt. Wenn der Regressionskoeffizient hingegen negativ ist, nimmt die Antwortvariable ab, wenn die erklärende Variable zunimmt.

Damit die vorherige Bedingung erfüllt ist, müssen logischerweise die anderen Variablen konstant bleiben. Deshalb ist es wichtig, dass es keine Multikollinearität zwischen den verschiedenen erklärenden Variablen des Modells gibt. Sie können sehen, wie die Multikollinearität eines Modells untersucht wird, indem Sie auf unserer Website nach dem entsprechenden Artikel suchen.

Multiple und einfache lineare Regression

Abschließend werden wir sehen, was die Unterschiede zwischen einem einfachen linearen Regressionsmodell und einem multiplen linearen Regressionsmodell sind, da es sich um zwei in der Statistik weit verbreitete Regressionsmodelle handelt.

Die einfache lineare Regression ist ein Regressionsmodell, mit dem eine unabhängige Variable in Beziehung gesetzt wird. Die Gleichung eines einfachen linearen Regressionsmodells lautet also wie folgt:

![]()

Daher liegt der Unterschied zwischen multipler linearer Regression und einfacher linearer Regression in der Anzahl erklärender Variablen. Ein multiples lineares Regressionsmodell hat zwei oder mehr erklärende Variablen, während ein einfaches lineares Regressionsmodell nur eine erklärende Variable hat.

![]()

Zusammenfassend lässt sich sagen, dass die multiple lineare Regression eine Erweiterung der einfachen linearen Regression ist, da einfach mehr erklärende Variablen und ihre jeweiligen Regressionskoeffizienten hinzugefügt werden. Allerdings werden die Regressionskoeffizienten unterschiedlich berechnet. Um zu sehen, wie das geht, klicken Sie hier: