So zeichnen sie einen entscheidungsbaum in r (mit beispiel)

Beim maschinellen Lernen ist ein Entscheidungsbaum eine Art Modell, das eine Reihe von Prädiktorvariablen verwendet, um einen Entscheidungsbaum zu erstellen, der den Wert einer Antwortvariablen vorhersagt.

Der einfachste Weg, einen Entscheidungsbaum in R zu zeichnen, ist die Verwendung der Funktion prp() aus dem Paket rpart.plot .

Das folgende Beispiel zeigt, wie Sie diese Funktion in der Praxis nutzen können.

Beispiel: Zeichnen eines Entscheidungsbaums in R

Für dieses Beispiel verwenden wir den Hitters- Datensatz aus dem ISLR- Paket, der verschiedene Informationen zu 263 professionellen Baseballspielern enthält.

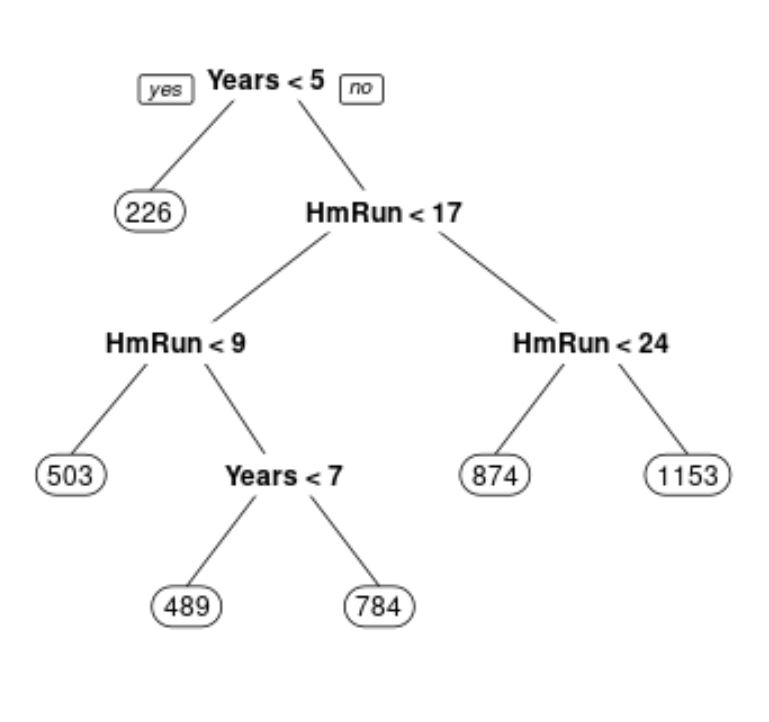

Wir werden diesen Datensatz verwenden, um einen Regressionsbaum zu erstellen, der Homeruns und gespielte Jahre verwendet, um das Gehalt eines bestimmten Spielers vorherzusagen.

Der folgende Code zeigt, wie dieser Regressionsbaum angepasst wird und wie die Funktion prp() zum Zeichnen des Baums verwendet wird:

library (ISLR) library (rpart) library (rpart.plot) #build the initial decision tree tree <- rpart(Salary ~ Years + HmRun, data=Hitters, control=rpart. control (cp= .0001 )) #identify best cp value to use best <- tree$cptable[which. min (tree$cptable[," xerror "])," CP "] #produce a pruned tree based on the best cp value pruned_tree <- prune (tree, cp=best) #plot the pruned tree prp(pruned_tree)

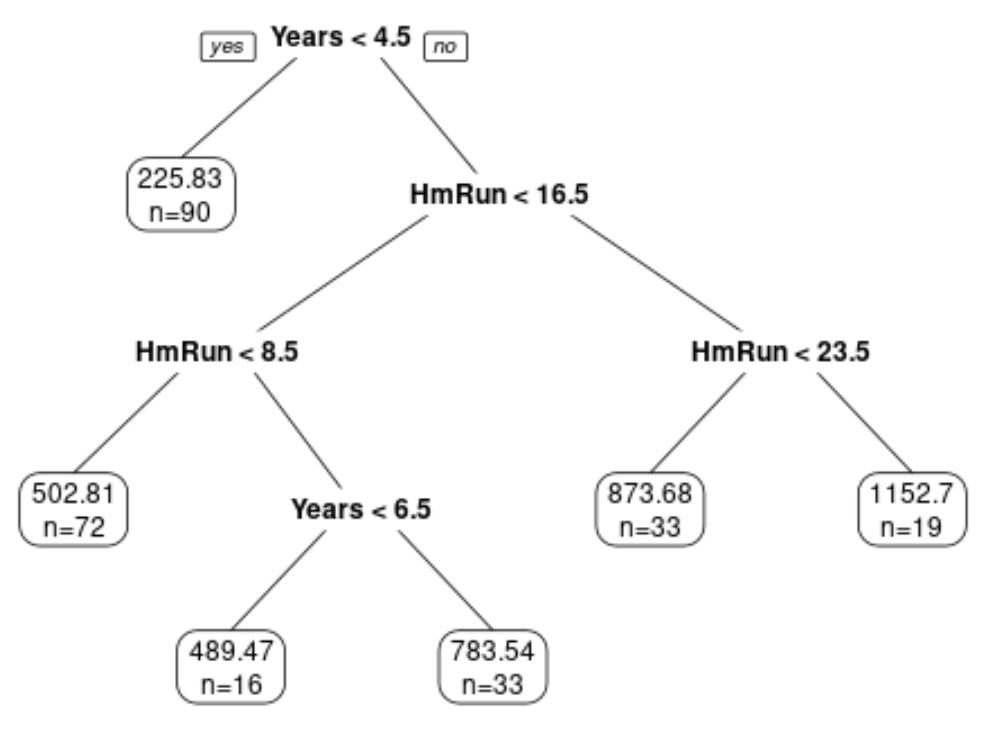

Beachten Sie, dass wir das Erscheinungsbild des Entscheidungsbaums auch mithilfe der Argumente faclen , extra , roundint und digits in der Funktion prp () anpassen können:

#plot decision tree using custom arguments

prp(pruned_tree,

faclen= 0 , #use full names for factor labels

extra= 1 , #display number of observations for each terminal node

roundint= F , #don't round to integers in output

digits= 5 ) #display 5 decimal places in output

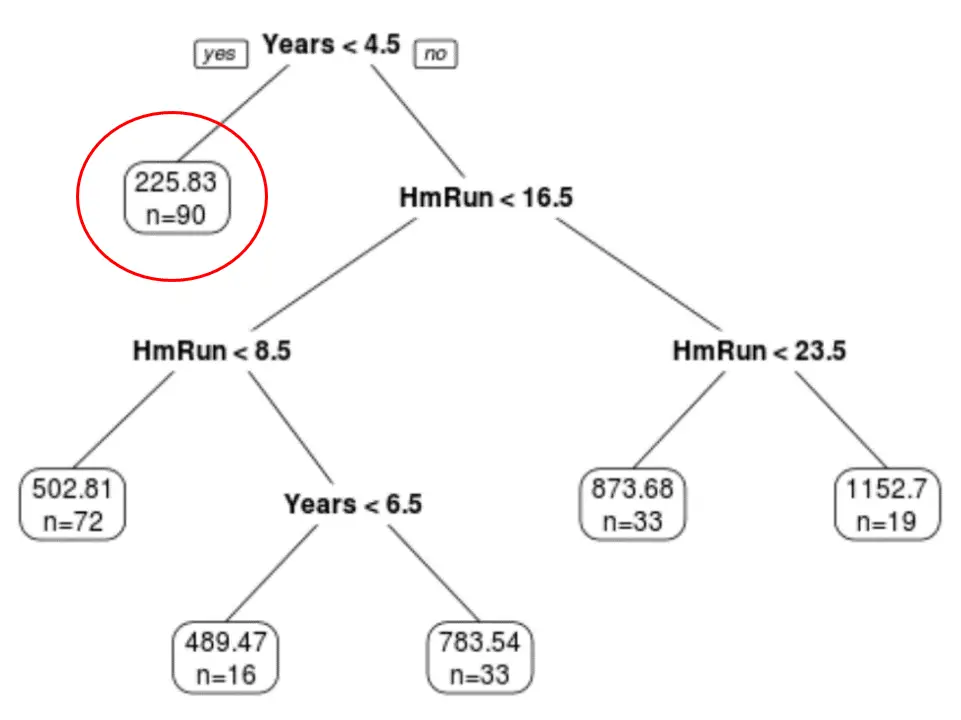

Wir können sehen, dass der Baum sechs Endknoten hat.

Jeder Endknoten zeigt das vorhergesagte Gehalt der Spieler in diesem Knoten sowie die Anzahl der Beobachtungen aus dem Originaldatensatz an, die zu dieser Bewertung gehören.

Wir können beispielsweise sehen, dass es im ursprünglichen Datensatz 90 Spieler mit weniger als 4,5 Jahren Erfahrung gab und ihr Durchschnittsgehalt 225,83.000 $ betrug.

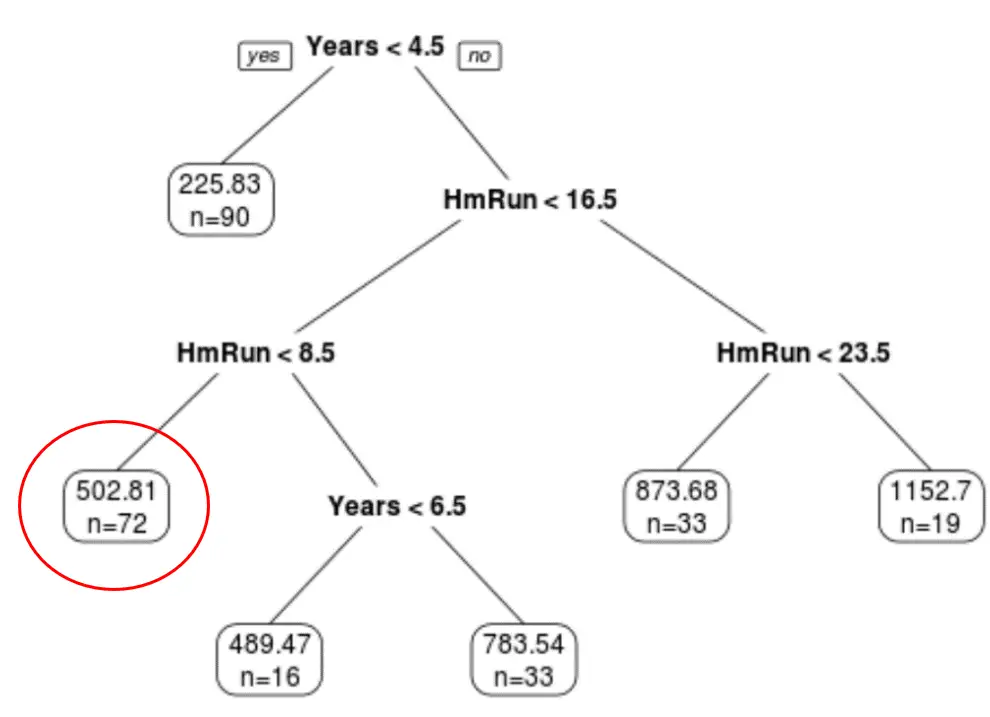

Wir können den Baum auch verwenden, um das Gehalt eines bestimmten Spielers basierend auf seiner jahrelangen Erfahrung und seinen durchschnittlichen Homeruns vorherzusagen.

Beispielsweise hat ein Spieler, der über 7 Jahre Erfahrung und durchschnittlich 4 Homeruns verfügt, ein erwartetes Gehalt von 502,81.000 $ .

Dies ist einer der Vorteile der Verwendung eines Entscheidungsbaums: Wir können die Ergebnisse einfach visualisieren und interpretieren.

Zusätzliche Ressourcen

Die folgenden Tutorials bieten zusätzliche Informationen zu Entscheidungsbäumen:

Eine Einführung in Klassifizierungs- und Regressionsbäume

Entscheidungsbaum vs. Zufallswälder: Was ist der Unterschied?

So passen Sie Klassifizierungs- und Regressionsbäume in R an