Was ist interrater-reliabilität? (definition & #038; beispiel)

In der Statistik ist die Inter-Bewerter-Reliabilität eine Möglichkeit, den Grad der Übereinstimmung zwischen mehreren Bewertern oder Richtern zu messen.

Es wird verwendet, um die Zuverlässigkeit der Antworten verschiedener Items in einem Test zu bewerten. Wenn ein Test eine geringere Interbeurteiler-Reliabilität aufweist, kann dies ein Hinweis darauf sein, dass die Testelemente verwirrend, unklar oder sogar nicht hilfreich sind.

Es gibt zwei gängige Methoden zur Messung der Zuverlässigkeit zwischen Bewertern:

1. Prozentsatz der Zustimmung

Die einfache Möglichkeit, die Zuverlässigkeit zwischen Bewertern zu messen, besteht darin, den Prozentsatz der Punkte zu berechnen, bei denen sich die Richter einig sind.

Dies wird als prozentuale Übereinstimmung bezeichnet, die immer zwischen 0 und 1 liegt, wobei 0 keine Übereinstimmung zwischen den Bewertern und 1 eine vollständige Übereinstimmung zwischen den Bewertern bedeutet.

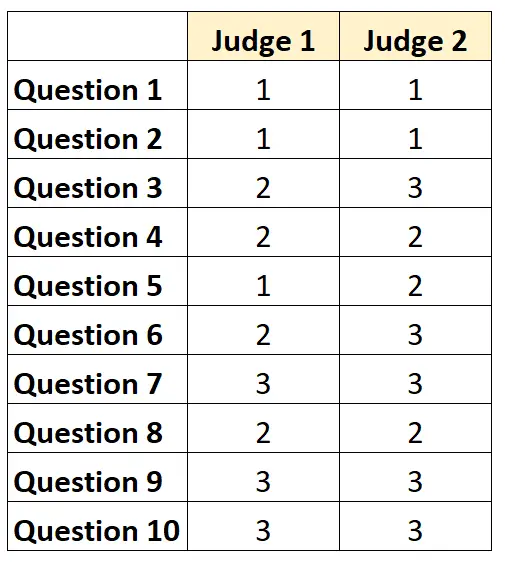

Angenommen, zwei Richter werden gebeten, die Schwierigkeit von 10 Punkten in einem Test auf einer Skala von 1 bis 3 zu bewerten. Die Ergebnisse werden unten angezeigt:

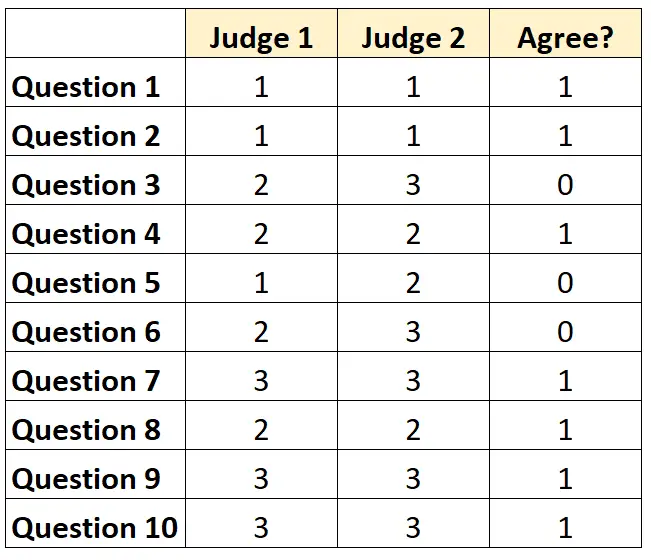

Für jede Frage können wir „1“ schreiben, wenn beide Richter zustimmen, und „0“, wenn sie nicht zustimmen.

Der Prozentsatz der Fragen, bei denen sich die Richter einig waren, betrug 7/10 = 70 % .

2. Cohens Kappa

Die schwierigste (und strengste) Methode zur Messung der Zuverlässigkeit zwischen Bewertern ist die Verwendung von Cohens Kappa , das den Prozentsatz der Punkte berechnet, über die sich die Bewerter einig sind, wobei berücksichtigt wird, dass sich die Bewerter möglicherweise nur auf bestimmte Elemente einigen. Glücklicherweise.

Die Kappa-Formel von Cohen wird wie folgt berechnet:

k = (p o – p e ) / (1 – p e )

Gold:

- p o : Relative Übereinstimmung zwischen den Bewertern beobachtet

- p e : Hypothetische Wahrscheinlichkeit einer zufälligen Übereinstimmung

Cohens Kappa liegt immer zwischen 0 und 1, wobei 0 keine Übereinstimmung zwischen den Bewertern und 1 eine vollständige Übereinstimmung zwischen den Bewertern bedeutet.

Ein Schritt-für-Schritt-Beispiel zur Berechnung von Cohens Kappa finden Sie in diesem Tutorial .

Wie interpretiert man die Interrater-Reliabilität?

Je höher die Zuverlässigkeit zwischen den Bewertern, desto konsistenter bewerten mehrere Prüfer Elemente oder Fragen in einem Test mit ähnlichen Ergebnissen.

Im Allgemeinen ist in den meisten Bereichen eine Übereinstimmung zwischen den Bewertern von mindestens 75 % erforderlich, damit ein Test als zuverlässig gilt. In bestimmten Bereichen können jedoch höhere Interrater-Zuverlässigkeiten erforderlich sein.

Beispielsweise kann eine Inter-Rater-Reliabilität von 75 % für einen Test zur Feststellung, wie gut ein Fernsehprogramm empfangen wird, akzeptabel sein.

Andererseits kann in medizinischen Situationen, in denen mehrere Ärzte beurteilen, ob eine bestimmte Behandlung bei einem bestimmten Patienten angewendet werden sollte, eine Interbeurteiler-Zuverlässigkeit von 95 % erforderlich sein.

Beachten Sie, dass in den meisten akademischen Umgebungen und anspruchsvollen Forschungsbereichen Cohens Kappa zur Berechnung der Interbeurteiler-Zuverlässigkeit verwendet wird.

Zusätzliche Ressourcen

Eine kurze Einführung in die Zuverlässigkeitsanalyse

Was ist zweigeteilte Zuverlässigkeit?

Was ist Test-Retest-Reliabilität?

Was ist die Zuverlässigkeit paralleler Formen?

Was ist ein Standardmessfehler?

Cohens Kappa-Rechner