Come calcolare la kappa di cohen in r

Nelle statistiche, il Kappa di Cohen viene utilizzato per misurare il livello di accordo tra due valutatori o giudici che classificano ciascun elemento in categorie mutuamente esclusive.

La formula kappa di Cohen si calcola come segue:

k = (p o – p e ) / (1 – p e )

Oro:

- p o : Accordo relativo osservato tra i valutatori

- p e : Probabilità ipotetica di accordo casuale

Invece di calcolare semplicemente la percentuale di elementi su cui i valutatori sono d’accordo, il Kappa di Cohen tenta di tenere conto del fatto che i valutatori possono essere d’accordo su alcuni elementi per mero caso.

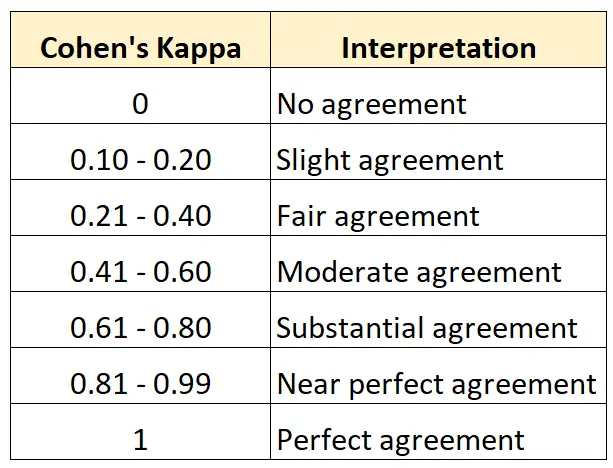

Il valore della Kappa di Cohen è sempre compreso tra 0 e 1 dove:

- 0 indica nessun accordo tra i due revisori

- 1 indica perfetto accordo tra i due valutatori

La tabella seguente riassume come interpretare i diversi valori della Kappa di Cohen:

Il modo più semplice per calcolare la Kappa di Cohen in R è utilizzare la funzione cohen.kappa() dal pacchetto psych .

L’esempio seguente mostra come utilizzare questa funzione nella pratica.

Esempio: calcolare la Kappa di Cohen in R

Supponiamo che a due curatori di un museo d’arte venga chiesto di valutare 15 dipinti per vedere se sono abbastanza buoni per essere esposti in una nuova mostra.

Il codice seguente mostra come utilizzare la funzione cohen.kappa() del pacchetto psych per calcolare la Kappa di Cohen per i due valutatori:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

La colonna stima mostra il valore Kappa di Cohen.

Dal risultato, possiamo vedere che il Kappa di Cohen risulta essere 0,34 .

Sulla base della tabella precedente, diremmo che i due valutatori avevano solo un livello di accordo “abbastanza”.

Se si desidera calcolare il livello di accordo tra tre o più valutatori, si consiglia invece di utilizzare il Kappa di Fleiss.

Risorse addizionali

I seguenti tutorial forniscono risorse aggiuntive su Cohen’s Kappa:

Introduzione al Kappa di Cohen

Calcolatore Kappa di Cohen online

Come calcolare la Kappa di Cohen in Excel

Come calcolare la Kappa di Cohen in Python