Regressione lineare

Questo articolo spiega cos’è la regressione lineare e a cosa serve nelle statistiche. Inoltre, sarai in grado di vedere come vengono calcolati i due tipi di regressione lineare: regressione lineare semplice e regressione lineare multipla.

Cos’è la regressione lineare?

La regressione lineare è un modello statistico che mette in relazione una o più variabili indipendenti con una variabile dipendente. In poche parole, la regressione lineare è una tecnica utilizzata per trovare un’equazione che approssima la relazione tra una o più variabili esplicative e una variabile di risposta.

Ad esempio, l’equazione y=2+5x 1 -3x 2 +8x 3 è un modello di regressione lineare perché mette in relazione matematicamente tre variabili indipendenti (x 1 , x 2 , x 3 ) con una variabile dipendente (y) e, inoltre, la relazione tra le variabili è lineare.

Tipi di regressione lineare

Esistono due tipi di regressione lineare :

- Regressione lineare semplice : una singola variabile indipendente è collegata a una variabile dipendente. L’equazione per questo tipo di modello di regressione lineare è quindi della forma y=β 0 +β 1 x 1 .

- Regressione lineare multipla : il modello di regressione ha diverse variabili esplicative e una variabile di risposta. Pertanto, l’equazione per questo tipo di modello di regressione lineare è della forma y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m .

regressione lineare semplice

La regressione lineare semplice viene utilizzata per mettere in relazione una variabile indipendente con entrambe le variabili.

L’equazione di un modello di regressione lineare semplice è una retta, è quindi composta da due coefficienti: la costante dell’equazione (β 0 ) e il coefficiente di correlazione tra le due variabili (β 1 ). Pertanto, l’equazione per un modello di regressione lineare semplice è y=β 0 +β 1 x.

![]()

Le formule per il calcolo dei coefficienti di regressione lineare semplice sono le seguenti:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

Oro:

-

è la costante della retta di regressione.

-

è la pendenza della retta di regressione.

-

è il valore della variabile indipendente X dei dati i.

-

è il valore della variabile dipendente Y dei dati i.

-

è la media dei valori della variabile indipendente

-

è la media dei valori della variabile dipendente Y.

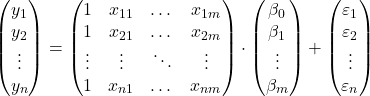

Regressione lineare multipla

In un modello di regressione lineare multipla sono incluse almeno due variabili indipendenti. In altre parole, la regressione lineare multipla consente di collegare linearmente diverse variabili esplicative a una variabile di risposta.

L’equazione per un modello di regressione lineare multipla è y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Oro:

-

è la variabile dipendente.

-

è la variabile indipendente i.

-

è la costante dell’equazione di regressione lineare multipla.

-

è il coefficiente di regressione associato alla variabile

.

-

è l’errore o residuo, cioè la differenza tra il valore osservato e il valore stimato dal modello.

-

è il numero totale di variabili nel modello.

Quindi, se abbiamo un campione con un totale di

![]()

osservazioni, possiamo porre il modello di regressione lineare multipla in forma matriciale:

L’espressione della matrice sopra può essere riscritta assegnando una lettera a ciascuna matrice:

![]()

Pertanto, applicando il criterio dei minimi quadrati, possiamo arrivare alla formula per stimare i coefficienti di un modello di regressione lineare multipla :

![]()

Tuttavia, l’applicazione di questa formula è molto laboriosa e richiede molto tempo, motivo per cui in pratica è consigliabile utilizzare un software per computer (come Minitab o Excel) che consente di creare un modello di regressione multipla molto più rapidamente.

Ipotesi di regressione lineare

In un modello di regressione lineare, affinché il modello sia valido, devono essere soddisfatte le seguenti condizioni:

- Indipendenza : i residui devono essere indipendenti l’uno dall’altro. Un modo comune per garantire l’indipendenza del modello è aggiungere casualità al processo di campionamento.

- Omoschedasticità : deve esserci omogeneità nelle varianze dei residui, cioè la variabilità dei residui deve essere costante.

- Non multicollinearità : le variabili esplicative incluse nel modello non possono essere collegate tra loro o, almeno, la loro relazione deve essere molto debole.

- Normalità : i residui devono essere distribuiti normalmente, o in altre parole devono seguire una distribuzione normale con media 0.

- Linearità : si presuppone che la relazione tra la variabile di risposta e le variabili esplicative sia lineare.

A cosa serve la regressione lineare?

La regressione lineare ha fondamentalmente due usi: la regressione lineare viene utilizzata per spiegare la relazione tra le variabili esplicative e la variabile di risposta e, analogamente, la regressione lineare viene utilizzata per prevedere il valore della variabile dipendente per una nuova osservazione.

Ottenendo l’equazione del modello di regressione lineare, possiamo sapere che tipo di relazione esiste tra le variabili nel modello. Se il coefficiente di regressione di una variabile indipendente è positivo, la variabile dipendente aumenterà quando aumenta. mentre se il coefficiente di regressione di una variabile indipendente è negativo, la variabile dipendente diminuirà quando aumenta.

D’altro canto, l’equazione calcolata nella regressione lineare consente anche di effettuare previsioni di valore. Pertanto, introducendo i valori delle variabili esplicative nell’equazione del modello, possiamo calcolare il valore della variabile dipendente per un nuovo dato.