Regressione lineare multipla

Questo articolo spiega cos’è la regressione lineare multipla nelle statistiche. Inoltre, imparerai come creare un modello di regressione lineare multipla e come viene interpretato.

Cos’è la regressione lineare multipla?

La regressione lineare multipla è un modello di regressione in cui sono incluse due o più variabili indipendenti. In altre parole, la regressione lineare multipla è un modello statistico che consente di collegare linearmente diverse variabili esplicative a una variabile di risposta.

Pertanto, viene utilizzato un modello di regressione lineare multipla per trovare un’equazione che mette in relazione due o più variabili indipendenti con una variabile dipendente. Pertanto, sostituendo il valore di ciascuna variabile indipendente, si ottiene un’approssimazione del valore della variabile dipendente.

Ad esempio, l’equazione y=3+6x 1 -4x 2 +7x 3 è un modello di regressione lineare multipla perché mette in relazione matematicamente tre variabili indipendenti (x 1 , x 2 , x 3 ) con un percorso del valore lineare della variabile dipendente (y) .

Formula di regressione lineare multipla

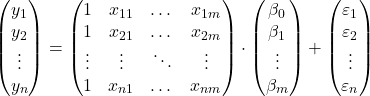

L’equazione per un modello di regressione lineare multipla è y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Oro:

-

è la variabile dipendente.

-

è la variabile indipendente i.

-

è la costante dell’equazione di regressione lineare multipla.

-

è il coefficiente di regressione associato alla variabile

.

-

Questo è l’errore o residuo, cioè la differenza tra il valore osservato e il valore stimato dal modello.

-

è il numero totale di variabili nel modello.

Quindi, se abbiamo un campione con un totale di

![]()

osservazioni, possiamo proporre il modello di regressione lineare multipla in forma matriciale:

L’espressione dell’array sopra può essere riscritta assegnando una lettera a ciascun array:

![]()

Pertanto, applicando il criterio dei minimi quadrati, è possibile arrivare alla formula per la stima dei coefficienti di un modello di regressione lineare multipla :

![]()

Tuttavia, l’applicazione di questa formula è molto laboriosa e richiede molto tempo, quindi in pratica è consigliabile utilizzare un software per computer (come Minitab o Excel) che consente di eseguire un modello di regressione multipla molto più rapidamente.

Ipotesi di regressione lineare multipla

In un modello di regressione lineare multipla, affinché il modello sia valido devono essere soddisfatte le seguenti condizioni:

- Indipendenza : i residui devono essere indipendenti l’uno dall’altro. Un modo comune per garantire l’indipendenza del modello è aggiungere casualità al processo di campionamento.

- Omoschedasticità : deve esserci omogeneità nelle varianze dei residui, cioè la variabilità dei residui deve essere costante.

- Non multicollinearità : le variabili esplicative incluse nel modello non possono essere collegate tra loro o, almeno, la loro relazione deve essere molto debole.

- Normalità : i residui devono essere distribuiti normalmente, o in altre parole devono seguire una distribuzione normale con media 0.

- Linearità : si presuppone che la relazione tra la variabile di risposta e le variabili esplicative sia lineare.

Interpretazione di un modello di regressione lineare multipla

Per interpretare un modello di regressione lineare multipla, dobbiamo guardare il coefficiente di determinazione (R quadrato), che esprime la percentuale spiegata dal modello di regressione. Pertanto, quanto più alto è il coefficiente di determinazione, tanto più il modello sarà adattato al campione di dati studiato.

Tuttavia, la bontà di adattamento di un modello statistico può essere fuorviante, in particolare nei modelli di regressione lineare multipla. Perché quando si aggiunge una variabile al modello, il coefficiente di determinazione aumenta, anche se la variabile non è significativa. È necessario però massimizzare il coefficiente di determinazione cercando di minimizzare il numero di variabili, poiché il modello risulta meno complicato e più semplice da interpretare.

Per risolvere questo problema è necessario calcolare il coefficiente di determinazione aggiustato (R quadrato aggiustato), che è un coefficiente statistico che misura la qualità di adattamento di un modello di regressione, penalizzando per ogni variabile aggiunta al modello, a differenza del coefficiente non aggiustato di determinazione. questo non tiene conto del numero di variabili nel modello.

Pertanto, il coefficiente di determinazione corretto ci consente di confrontare la bontà di adattamento di due modelli con un diverso numero di variabili. In linea di principio si dovrebbe scegliere il modello che ha un coefficiente di determinazione aggiustato più alto, ma se i due modelli hanno valori molto simili è meglio selezionare il modello con meno variabili perché più semplice da interpretare.

Al contrario, i coefficienti di regressione indicano la relazione tra la variabile esplicativa e la variabile di risposta. Se il coefficiente di regressione è positivo, la variabile di risposta aumenterà all’aumentare della variabile esplicativa. mentre se il coefficiente di regressione è negativo, la variabile di risposta diminuirà all’aumentare della variabile esplicativa.

Logicamente, affinché la condizione precedente sia soddisfatta, le altre variabili devono rimanere costanti. Per questo motivo è importante che non vi sia multicollinearità tra le diverse variabili esplicative del modello. Puoi vedere come viene studiata la multicollinearità di un modello cercando l’articolo corrispondente sul nostro sito.

Regressione lineare multipla e semplice

Infine, vedremo quali sono le differenze tra un modello di regressione lineare semplice e un modello di regressione lineare multipla, poiché sono due modelli di regressione ampiamente utilizzati in statistica.

La regressione lineare semplice è un modello di regressione utilizzato per mettere in relazione una variabile indipendente. Quindi l’equazione di un modello di regressione lineare semplice è la seguente:

![]()

Pertanto, la differenza tra regressione lineare multipla e regressione lineare semplice risiede nel numero di variabili esplicative. Un modello di regressione lineare multipla ha due o più variabili esplicative, mentre un modello di regressione lineare semplice ha solo una variabile esplicativa.

![]()

In conclusione, la regressione lineare multipla è un’estensione della regressione lineare semplice, poiché vengono semplicemente aggiunte più variabili esplicative e i rispettivi coefficienti di regressione. Tuttavia, i coefficienti di regressione vengono calcolati in modo diverso, per vedere come avviene clicca qui: