回帰分析

この記事では、回帰分析とは何なのか、統計で何に使用されるのかについて説明します。さらに、さまざまな種類の回帰分析が何であるかを確認できます。

回帰分析とは何ですか?

統計学における回帰分析は、2 つ以上の変数間の関係を研究するプロセスです。より具体的には、回帰分析には、研究内の変数を数学的に関連付ける方程式の計算が含まれます。

回帰分析で構築されたモデルは回帰モデルと呼ばれ、調査対象の変数を関連付ける方程式は回帰方程式と呼ばれます。

たとえば、国のインフレと GDP の関係を調査したい場合は、回帰分析を実行して 2 つの変数間の関係を分析できます。この場合、回帰分析から得られる方程式は回帰直線になります。

したがって、回帰分析はデータのサンプルを収集することから構成され、収集されたデータから、調査対象の変数を数学的に関連付ける方程式が計算されます。

回帰分析では、回帰モデルに含めることができる次の 2 種類の変数を区別することが重要です。

- 従属変数 (または応答変数) : これは分析したい要素であるため、この変数の値が他の変数の値に応じてどのように変化するかを確認するために回帰モデルが構築されます。

- 独立変数 (または説明変数) : 分析したい変数に影響を与える可能性が高いと考えられる要因です。つまり、独立変数の値は従属変数の値に影響を与えます。

回帰分析の種類

基本的に、回帰分析には 3 つのタイプがあります。

- 単純線形回帰分析: 回帰モデルには独立変数と従属変数があり、それらは線形に関連しています。

- 重回帰分析: 2 つ以上の独立変数が従属変数と線形に関係します。

- 非線形回帰分析: 独立変数と従属変数の間の関係は、非線形関数を使用してモデル化されます。

単純な線形回帰分析

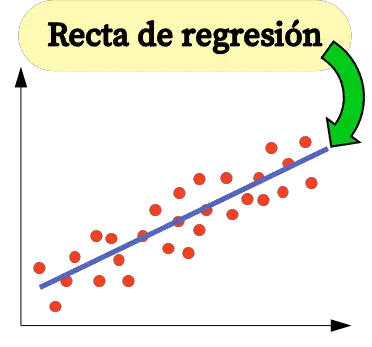

単純な線形回帰は、線形方程式を使用して独立変数を両方の変数に関連付けるために使用されます。

単純な線形回帰モデルの方程式は直線であるため、方程式の定数 (β 0 ) と 2 つの変数間の相関係数 (β 1 ) の 2 つの係数で構成されます。したがって、単純な線形回帰モデルの方程式は y=β 0 +β 1 x となります。

![]()

単回帰の係数を計算する式は次のとおりです。

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

金:

-

回帰直線の定数です。

-

は回帰直線の傾きです。

-

データ i の独立変数 X の値です。

-

データ i の従属変数 Y の値です。

-

独立変数の値の平均です

-

従属変数 Y の値の平均です。

重回帰分析

重線形回帰モデルには、少なくとも 2 つの独立変数が含まれます。言い換えれば、重線形回帰では、いくつかの説明変数を応答変数に線形にリンクさせることができます。したがって、重線形回帰モデルの方程式は次のようになります。

![]()

金:

-

は従属変数です。

-

は独立変数 i です。

-

重回帰式の定数です。

-

変数に関連付けられた回帰係数です

。

-

誤差または残差、つまり観測値とモデルによって推定された値の差です。

-

はモデル内の変数の総数です。

したがって、合計が含まれるサンプルがある場合、

![]()

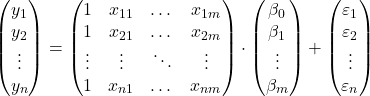

観察結果を基に、行列形式で重線形回帰モデルを立てることができます。

上記の行列式は、各行列に文字を割り当てることで書き換えることができます。

![]()

したがって、最小二乗基準を適用すると、重線形回帰モデルの係数を推定するための式に到達できます。

![]()

ただし、この公式の適用は非常に手間と時間がかかるため、実際には、重回帰モデルをより迅速に作成できるコンピューター ソフトウェア (Minitab や Excel など) を使用することをお勧めします。

非線形回帰分析

統計学における非線形回帰は、回帰式のモデルとして非線形関数が使用される回帰の一種です。したがって、非線形回帰モデルの方程式は非線形関数になります。

論理的には、非線形回帰は、2 つの変数間の関係が線形ではない場合に、独立変数を従属変数に関連付けるために使用されます。したがって、サンプルデータをグラフ化するときに、それらが線形関係を持たないことが観察された場合、つまり、それらがほぼ直線を形成していない場合は、「非線形回帰モデルを使用する」方が適切です。

たとえば、方程式 y=3-5x-8x 2 +x 3は、3 次関数を介して独立変数 X を従属変数 Y に数学的に関係付けるため、非線形回帰モデルです。

非線形回帰には主に 3 つのタイプがあります。

- 多項式回帰– 方程式が多項式の形式である非線形回帰。

- 対数回帰– 独立変数が対数化される非線形回帰。

- 指数回帰– 独立変数が方程式の指数に存在する非線形回帰。

![]()

![]()

![]()

回帰分析は何に使用されますか?

回帰分析には基本的に 2 つの用途があります。回帰分析は説明変数と応答変数の関係を説明するために使用され、同様に回帰分析は新しい観測値の従属変数の値を予測するために使用されます。

回帰モデルの方程式を求めることで、モデル内の変数間にどのような関係が存在するかを知ることができます。独立変数の回帰係数が正の場合、従属変数が増加すると従属変数も増加します。一方、独立変数の回帰係数が負の場合、従属変数は増加すると減少します。

一方、回帰分析から得られた数式を使用して値を予測することもできます。したがって、説明変数の値を回帰モデルの方程式に導入することで、新しいデータの従属変数の値を計算できます。