R でコーエンのカッパを計算する方法

統計では、 コーエンのカッパは、各項目を相互に排他的なカテゴリに分類する 2 人の評価者または審査員の間の一致レベルを測定するために使用されます。

コーエンのカッパ式は次のように計算されます。

k = (p o – p e ) / (1 – p e )

金:

- p o :評価者間で観察された相対的な一致

- p e :偶然の一致の仮説確率

コーエンのカッパは、評価者が同意する項目の割合を単純に計算するのではなく、評価者が一部の項目について単なる偶然に同意する可能性があるという事実を説明しようとします。

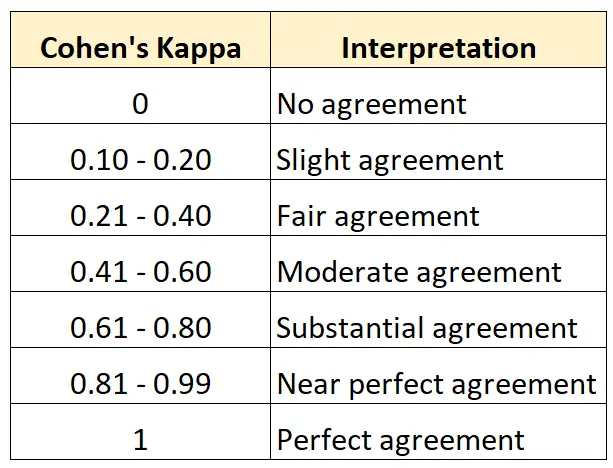

コーエンのカッパの値は常に 0 から 1 の間になります。ここで、

- 0 は2 人のレビュー担当者の間で合意がないことを示します

- 1 は2 人の評価者が完全に一致していることを示します

次の表は、コーエンのカッパのさまざまな値を解釈する方法をまとめたものです。

R でコーエンのカッパを計算する最も簡単な方法は、 psychパッケージのcohen.kappa()関数を使用することです。

次の例は、この関数を実際に使用する方法を示しています。

例: R でコーエンのカッパを計算する

美術館の 2 人の学芸員が 15 点の絵画を評価して、新しい展覧会に展示するのに十分かどうかを確認するように依頼されたとします。

次のコードは、 psychパッケージのcohen.kappa()関数を使用して 2 人の評価者のコーエンのカッパを計算する方法を示しています。

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

推定列にはコーエンのカッパ値が表示されます。

結果から、コーエンのカッパは0.34であることがわかります。

前の表に基づくと、2 人の評価者は「かなり」レベルで一致しただけであると言えます。

3 人以上の評価者間の一致レベルを計算したい場合は、代わりに Fleiss’ Kappa を使用することをお勧めします。

追加リソース

次のチュートリアルでは、Cohen’s Kappa に関する追加リソースを提供します。

コーエンのカッパの紹介

オンラインコーエンのカッパ計算機

Excel でコーエンのカッパを計算する方法

Python でコーエンのカッパを計算する方法