多重線形回帰

この記事では、統計における重回帰とは何かについて説明します。さらに、重線形回帰モデルの作成方法とその解釈方法を学びます。

多重線形回帰とは何ですか?

重回帰は、 2 つ以上の独立変数が含まれる回帰モデルです。言い換えれば、重線形回帰は、複数の説明変数を応答変数に線形にリンクできる統計モデルです。

したがって、重線形回帰モデルを使用して、2 つ以上の独立変数を従属変数に関連付ける方程式を見つけます。したがって、各独立変数の値を代入することにより、従属変数の値の近似値が得られます。

たとえば、方程式 y=3+6x 1 -4x 2 +7x 3 は、3 つの独立変数 (x 1 、 x 2 、 x 3 ) を 1 つの従属変数 (y) の線形値パスと数学的に関連付けているため、重線形回帰モデルです。 。

重回帰式

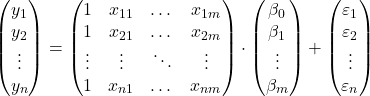

重線形回帰モデルの方程式は、y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +εです。

![]()

金:

-

は従属変数です。

-

は独立変数 i です。

-

重回帰式の定数です。

-

変数に関連付けられた回帰係数です

。

-

これは誤差または残差、つまり観測値とモデルによって推定された値の差です。

-

はモデル内の変数の総数です。

したがって、合計が含まれるサンプルがある場合、

![]()

観察結果を基に、行列形式の重線形回帰モデルを提案できます。

上記の配列式は、各配列に文字を割り当てることで書き換えることができます。

![]()

したがって、最小二乗基準を適用すると、重線形回帰モデルの係数を推定するための公式に到達することができます。

![]()

ただし、この式の適用は非常に手間と時間がかかるため、実際には、複数の回帰モデルをより迅速に実行できるコンピューター ソフトウェア (Minitab や Excel など) を使用することをお勧めします。

重線形回帰の仮定

重線形回帰モデルでは、モデルが有効であるためには次の条件を満たす必要があります。

- 独立性: 残基は互いに独立していなければなりません。モデルの独立性を確保する一般的な方法は、サンプリング プロセスにランダム性を追加することです。

- 等分散性: 残差の分散には均一性がなければなりません。つまり、残差の変動性は一定でなければなりません。

- 非多重共線性: モデルに含まれる説明変数は相互にリンクできないか、少なくともそれらの関係は非常に弱い必要があります。

- 正規性: 残差は正規分布する必要があります。つまり、残差は平均 0 の正規分布に従う必要があります。

- 線形性: 応答変数と説明変数の間の関係は線形であると仮定されます。

重線形回帰モデルの解釈

重線形回帰モデルを解釈するには、回帰モデルによって説明されるパーセンテージを表す決定係数 (R 二乗) を確認する必要があります。したがって、決定係数が高くなるほど、モデルは調査対象のデータ サンプルに合わせて調整されます。

ただし、統計モデルの適合度は、特に多重線形回帰モデルでは誤解を招く可能性があります。変数をモデルに追加すると、その変数が有意でなくても、決定係数が増加するためです。ただし、モデルの複雑さが軽減され解釈が容易になるため、変数の数を最小限に抑えて決定係数を最大化する必要があります。

この問題を解決するには、調整された決定係数 (調整された R 二乗) を計算する必要があります。これは、回帰モデルの適合の質を測定する統計係数であり、未調整の係数とは異なり、モデルに追加された各変数にペナルティを与えます。決意の。これには、モデル内の変数の数は考慮されません。

したがって、調整された決定係数を使用すると、変数の数が異なる 2 つのモデルの適合度を比較できます。原則として、調整された決定係数がより高いモデルを選択する必要がありますが、2 つのモデルの値が非常に似ている場合は、変数が少ないモデルを選択する方が解釈が容易です。

対照的に、回帰係数は説明変数と応答変数の間の関係を示します。回帰係数が正の場合、説明変数が増加するにつれて応答変数も増加します。一方、回帰係数が負の場合、説明変数が増加すると応答変数は減少します。

論理的には、前の条件が満たされるためには、他の変数が一定のままでなければなりません。このため、モデルの異なる説明変数間に多重共線性がないことが重要です。当社の Web サイトで該当する記事を検索すると、モデルの多重共線性がどのように研究されるかを確認できます。

多重単純線形回帰

最後に、単純線形回帰モデルと重線形回帰モデルの違いについて説明します。これらは統計で広く使用されている 2 つの回帰モデルです。

単純線形回帰は、独立変数を関連付けるために使用される回帰モデルです。したがって、単純な線形回帰モデルの方程式は次のようになります。

![]()

したがって、重回帰と単回帰の違いは説明変数の数にあります。重線形回帰モデルには 2 つ以上の説明変数がありますが、単純線形回帰モデルには 1 つの説明変数しかありません。

![]()

結論として、多重線形回帰は、より多くの説明変数とそれぞれの回帰係数が単純に追加されるため、単純な線形回帰の拡張です。ただし、回帰係数の計算方法は異なります。これがどのように行われるかを確認するには、ここをクリックしてください。