분류 및 회귀 트리 소개

일련의 예측 변수와 반응 변수 간의 관계가 선형인 경우 다중 선형 회귀 와 같은 방법을 사용하면 정확한 예측 모델을 생성할 수 있습니다.

그러나 일련의 예측 변수와 반응 간의 관계가 매우 비선형적이고 복잡한 경우에는 비선형 방법이 더 잘 수행될 수 있습니다.

비선형 방법의 예로는 CART 로 축약되는 분류 및 회귀 트리가 있습니다.

이름에서 알 수 있듯이 CART 모델은 일련의 예측 변수를 사용하여 반응 변수의 값을 예측하는 의사결정 트리를 만듭니다.

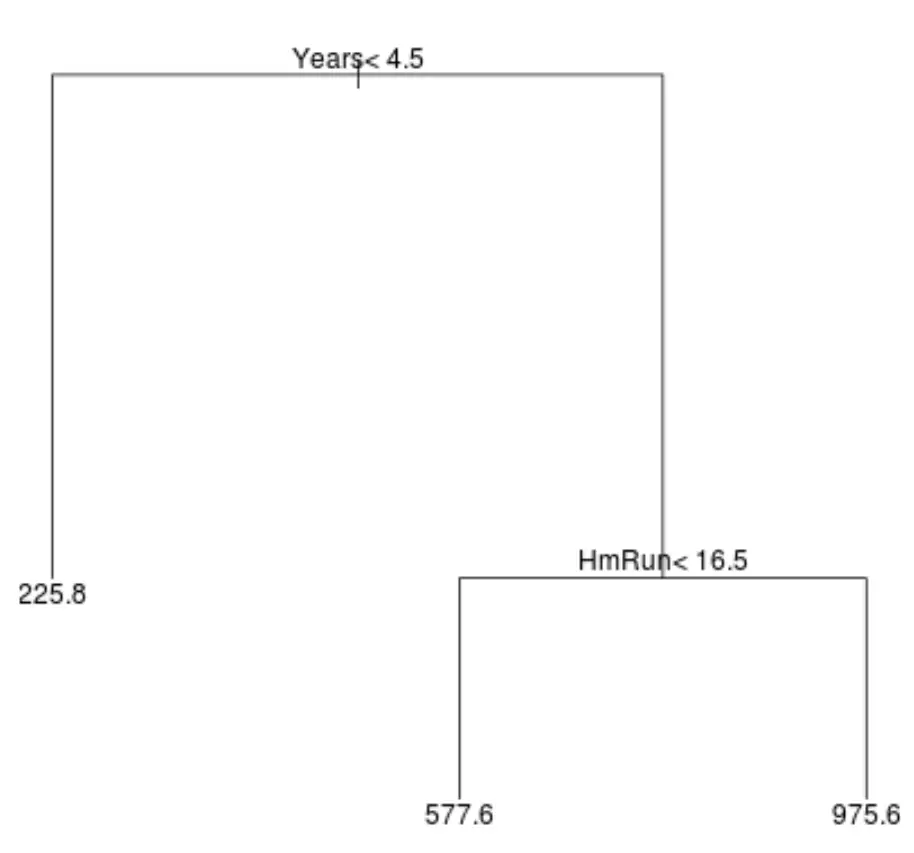

예를 들어, 예측 변수인 플레이 연수 와 평균 홈런 , 그리고 수백 명의 프로 야구 선수에 대한 응답 변수 연봉이 포함된 데이터 세트가 있다고 가정합니다.

이 데이터 세트에 대한 회귀 트리는 다음과 같습니다.

트리를 해석하는 방법은 다음과 같습니다.

- 4.5년 미만 선수들의 예상 연봉은 225,800달러입니다.

- 4.5년 이상, 평균 홈런 16.5개 미만을 뛴 선수들의 예상 연봉은 57만7600달러다.

- 4.5년 이상의 플레이 경험과 평균 16.5홈런 이상의 선수의 예상 연봉은 $975.6K입니다.

이 모델의 결과는 직관적으로 이해가 됩니다. 더 많은 경험과 더 많은 평균 홈런을 가진 선수가 더 높은 급여를 받는 경향이 있습니다.

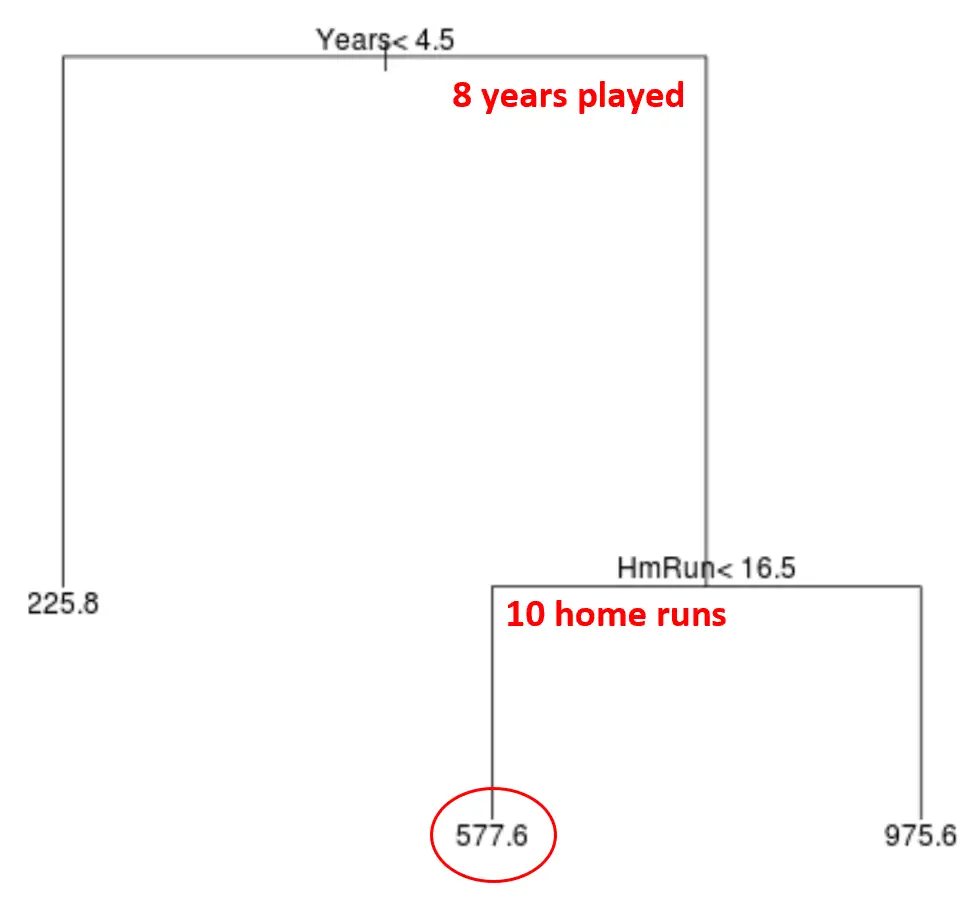

그런 다음 이 모델을 사용하여 새로운 선수의 연봉을 예측할 수 있습니다.

예를 들어, 특정 선수가 8년 동안 뛰었고 연간 평균 10홈런을 쳤다고 가정해 보겠습니다. 우리 모델에 따르면 이 선수의 연봉은 $577.6k라고 예측합니다.

나무에 대한 몇 가지 설명:

- 트리 상단에 위치한 첫 번째 예측 변수는 가장 중요합니다. 즉, 반응 변수 값 예측에 가장 큰 영향을 미치는 변수입니다. 이 경우, 플레이한 연수는 서킷의 평균 보다 급여를 더 잘 예측합니다.

- 트리 하단의 영역을 리프 노드 라고 합니다. 이 특정 트리에는 세 개의 터미널 노드가 있습니다.

CART 모델을 생성하는 단계

다음 단계를 사용하여 특정 데이터세트에 대한 CART 모델을 만들 수 있습니다.

1단계: 재귀 이진 분할을 사용하여 훈련 데이터에서 큰 트리를 성장시킵니다.

먼저, 다음 방법을 사용하여 회귀 트리를 성장시키기 위해 재귀 이진 분할이라는 그리디 알고리즘을 사용합니다.

- 모든 예측 변수 X 1 , X 2 , … , 잔차 표준 오차)를 가장 낮게 고려하십시오. .

- 분류 트리의 경우 결과 트리의 분류 오류율이 가장 낮도록 예측변수와 컷포인트를 선택합니다.

- 이 프로세스를 반복하여 각 터미널 노드의 관측치가 특정 최소 수보다 적은 경우에만 중지합니다.

이 알고리즘은 트리 구축 프로세스의 각 단계에서 미래를 내다보고 미래 단계에서 더 나은 트리 글로벌로 이어질 분할을 선택하는 대신 해당 단계만을 기반으로 최상의 분할을 결정하기 때문에 탐욕적 입니다.

2단계: α를 기반으로 최상의 트리 시퀀스를 얻기 위해 큰 트리에 비용 복잡성 가지치기를 적용합니다.

큰 나무를 키운 후에는 다음과 같이 작동하는 복합 가지치기(complex pruning)라는 방법을 사용하여 나무를 가지치기 해야 합니다.

- T 터미널 노드가 있는 가능한 각 트리에 대해 RSS + α|T|를 최소화하는 트리를 찾습니다.

- α 값을 늘리면 더 많은 터미널 노드가 있는 트리에 불이익이 발생합니다. 이렇게 하면 트리가 너무 복잡해지지 않습니다.

이 프로세스를 통해 각 α 값에 대한 최상의 트리 시퀀스가 생성됩니다.

3단계: k-겹 교차 검증을 사용하여 α를 선택합니다 .

각 α 값에 가장 적합한 트리를 찾으면 k-겹 교차 검증을 적용하여 테스트 오류를 최소화하는 α 값을 선택할 수 있습니다.

4단계: 최종 템플릿을 선택합니다.

마지막으로 선택한 α 값에 해당하는 최종 모델을 선택합니다.

CART 모델의 장점과 단점

CART 모델은 다음과 같은 장점을 제공합니다.

- 해석하기 쉽습니다.

- 설명하기 쉽습니다.

- 시각화하기 쉽습니다.

- 회귀 문제와 분류 문제 모두에 적용할 수 있습니다.

그러나 CART 모델에는 다음과 같은 단점이 있습니다.

- 다른 비선형 기계 학습 알고리즘만큼 예측 정확도가 높지 않은 경향이 있습니다. 그러나 배깅, 부스팅, 랜덤 포레스트 등의 방법으로 많은 의사결정 트리를 클러스터링하면 예측 정확도를 높일 수 있습니다.

관련 항목: R에 분류 및 회귀 트리를 맞추는 방법