클래스 내 상관 계수: 정의 + 예

클래스 내 상관 계수 (ICC)는 두 명 이상의 평가자가 있는 연구에서 점수의 신뢰성 을 측정하는 데 사용됩니다.

ICC 값의 범위는 0에서 1까지이며, 0은 평가자 간의 신뢰도가 없음을 나타내고 1은 평가자 간의 완벽한 신뢰도를 나타냅니다.

간단히 말해서, ICC는 항목(또는 주제)이 다양한 평가자에 의해 안정적으로 평가될 수 있는지 여부를 결정하는 데 사용됩니다.

다음 세 가지 요소에 따라 계산할 수 있는 ICC의 여러 가지 버전이 있습니다.

- 모델: 단방향 무작위 효과, 양방향 무작위 효과 또는 양방향 혼합 효과

- 관계 유형: 일관성 또는 절대적인 동의

- 단위: 단일 평가자 또는 평가자의 평균

다음은 세 가지 모델 에 대한 간략한 설명입니다.

1. 일원 무작위 효과 모델: 이 모델은 각 피험자가 무작위로 선택된 평가자의 다른 그룹에 의해 평가된다고 가정합니다. 이 모델을 사용하면 평가자가 무작위 효과의 소스로 간주됩니다. 일반적으로 동일한 평가자 그룹이 각 주제를 평가하는 데 사용되기 때문에 이 모델은 실제로 거의 사용되지 않습니다.

2. 양방향 무작위 효과 모델: 이 모델은 k 개의 평가자 그룹이 모집단에서 무작위로 선택된 다음 피험자를 평가하는 데 사용된다고 가정합니다. 이 모델을 사용하면 평가자와 피험자가 무작위 효과의 원인으로 간주됩니다. 이 모델은 연구에 사용된 것과 유사한 평가자에게 결과를 일반화하려고 할 때 자주 사용됩니다.

3. 양방향 혼합 효과 모델: 이 모델은 또한 평가자 그룹 k 가 모집단에서 무작위로 선택된 다음 피험자를 평가하는 데 사용된다고 가정합니다. 그러나 이 모델은 우리가 선택한 평가자 그룹이 관심 있는 유일한 평가자라고 가정합니다. 즉, 연구에 사용된 평가자와 유사한 특성을 공유할 수 있는 다른 평가자에게 결과를 일반화하고 싶지 않다는 의미입니다.

다음은 측정할 수 있는 두 가지 유형의 관계 에 대한 간략한 설명입니다.

1. 일관성: 우리는 심사위원 평점 간의 체계적인 차이에 관심이 있습니다(예: 심사위원이 유사한 주제를 낮음과 높음으로 평가했습니까?)

2. 절대적 동의: 심사위원 점수의 절대적인 차이에 관심이 있습니다(예: 심사위원 A와 심사위원 B의 점수 간의 절대적인 차이는 무엇입니까?)

다음은 우리가 관심을 가질 수 있는 두 가지 다른 단위 에 대한 간략한 설명입니다.

1. 단일 리뷰어: 단일 리뷰어의 평점만 측정 기준으로 사용하려고 합니다.

2. 평가자 평균: 모든 심사위원의 점수 평균을 측정 기준으로 사용하려고 합니다.

참고: 이분법적 결과 에 대한 각 항목을 놓친 두 평가자 간의 합의 수준을 측정하려면 대신 Cohen’s Kappa를 사용해야 합니다.

클래스 내 상관 계수를 해석하는 방법

Koo & Li 에 따르면 클래스 내 상관 계수 값을 해석하는 방법은 다음과 같습니다.

- 0.50 미만: 신뢰성이 낮음

- 0.5~0.75: 중간 정도의 신뢰도

- 0.75~0.9 사이: 우수한 신뢰도

- 0.9 이상 : 신뢰성이 우수함

다음 예에서는 실제로 클래스 내 상관계수를 계산하는 방법을 보여줍니다.

예: 클래스 내 상관 계수 계산

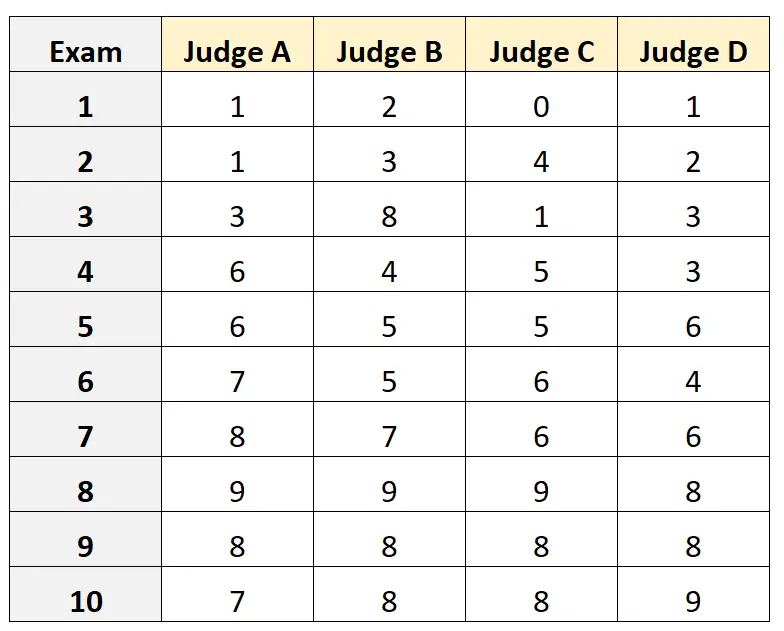

4명의 심사위원에게 10가지 대학 입시 시험의 질을 평가하도록 요청했다고 가정해 보겠습니다. 결과는 아래와 같습니다:

4명의 심사위원이 입학시험 자격을 갖춘 심사위원 집단 중에서 무작위로 선택되었고 심사위원 간의 절대적인 동의 여부를 측정하고 단 한 명의 평가자의 관점에서 얻은 점수를 측정의 기초로 사용하기를 원한다고 가정합니다.

R에서 다음 코드를 사용하여 양방향 무작위 효과 모델을 맞출 수 있습니다. 절대 합의를 평가자 간의 관계로 사용하고 단일 단위를 관심 단위로 사용합니다.

#load the interrater reliability package library (irr) #define data data <- data. frame (A=c(1, 1, 3, 6, 6, 7, 8, 9, 8, 7), B=c(2, 3, 8, 4, 5, 5, 7, 9, 8, 8), C=c(0, 4, 1, 5, 5, 6, 6, 9, 8, 8), D=c(1, 2, 3, 3, 6, 4, 6, 8, 8, 9)) #calculate ICC icc(data, model = " twoway ", type = " agreement ", unit = " single ") Model: twoway Type: agreement Subjects = 10 Failures = 4 ICC(A,1) = 0.782 F-Test, H0: r0 = 0; H1: r0 > 0 F(9.30) = 15.3, p = 5.93e-09 95%-Confidence Interval for ICC Population Values: 0.554 < ICC < 0.931

클래스 내 상관계수(ICC)는 0.782 로 나타났습니다.

ICC 해석에 대한 경험 법칙에 기초하여, ICC 0.782 는 다양한 평가자에 의해 시험이 “좋은” 신뢰성으로 채점될 수 있음을 의미한다는 결론을 내릴 수 있습니다.

추가 리소스

다음 튜토리얼에서는 다양한 통계 소프트웨어에서 ICC를 계산하는 방법에 대한 자세한 설명을 제공합니다.

Excel에서 클래스 내 상관 계수를 계산하는 방법

R에서 클래스 내 상관 계수를 계산하는 방법

Python에서 클래스 내 상관 계수를 계산하는 방법