R에서 cohen의 카파를 계산하는 방법

통계에서 Cohen의 Kappa는 각 항목을 상호 배타적인 범주로 분류하는 두 평가자 또는 심사위원 간의 일치 수준을 측정하는 데 사용됩니다.

Cohen의 카파 공식은 다음과 같이 계산됩니다.

k = ( po – p e ) / (1 – p e )

금:

- p o : 평가자 간 상대적인 동의가 관찰됨

- p e : 우연 일치의 가상 확률

Cohen의 Kappa는 평가자가 동의하는 항목의 비율을 단순히 계산하는 대신 평가자가 일부 항목에 우연히 동의할 수 있다는 사실을 설명하려고 시도합니다.

Cohen의 카파 값은 항상 0과 1 사이입니다. 여기서:

- 0은 두 리뷰어 사이에 합의가 없음을 나타냅니다.

- 1은 두 평가자 간의 완벽한 일치를 나타냅니다.

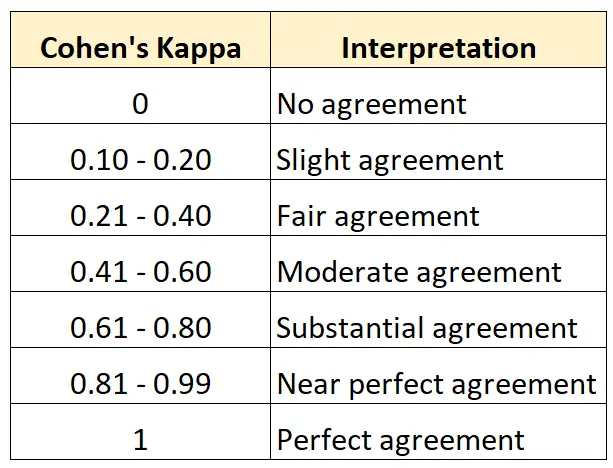

다음 표에는 Cohen의 카파의 다양한 값을 해석하는 방법이 요약되어 있습니다.

R에서 Cohen의 Kappa를 계산하는 가장 쉬운 방법은 psych 패키지의 cohen.kappa() 함수를 사용하는 것입니다.

다음 예에서는 이 기능을 실제로 사용하는 방법을 보여줍니다.

예: R에서 Cohen의 카파 계산

한 미술관의 큐레이터 두 명이 새 전시회에 전시할 만큼 좋은지 알아보기 위해 15점의 그림을 평가하도록 요청받았다고 가정해 보겠습니다.

다음 코드는 psych 패키지의 cohen.kappa() 함수를 사용하여 두 평가자에 대한 Cohen의 Kappa를 계산하는 방법을 보여줍니다.

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

추정 열에는 Cohen의 카파 값이 표시됩니다.

결과로부터 Cohen’s Kappa는 0.34 로 나타나는 것을 알 수 있다.

이전 표에 따르면 두 평가자는 “상당히” 수준의 합의만 했다고 말할 수 있습니다.

3명 이상의 평가자 간의 합의 수준을 계산하려면 대신 Fleiss’ Kappa를 사용하는 것이 좋습니다.

추가 리소스

다음 자습서에서는 Cohen의 Kappa에 대한 추가 리소스를 제공합니다.

코헨의 카파 소개

온라인 Cohen의 카파 계산기

Excel에서 Cohen의 카파를 계산하는 방법

Python에서 Cohen의 카파를 계산하는 방법