Cohen의 kappa 통계: 정의 및 예

Cohen의 Kappa 통계는 항목을 상호 배타적인 범주로 분류하는 두 평가자 또는 심사위원 간의 합의 수준을 측정하는 데 사용됩니다.

Cohen의 카파 공식은 다음과 같이 계산됩니다.

k = ( po – p e ) / (1 – p e )

금:

- p o : 평가자 간 상대적인 동의가 관찰됨

- p e : 우연 일치의 가상 확률

Cohen의 Kappa는 평가자가 동의하는 항목의 비율을 단순히 계산하는 대신 평가자가 일부 항목에 우연히 동의할 수 있다는 사실을 설명하려고 시도합니다.

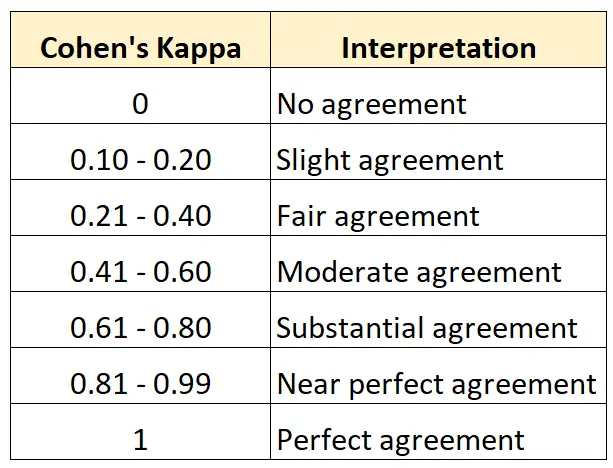

Cohen의 Kappa를 해석하는 방법

Cohen의 Kappa는 항상 0과 1 사이이며, 0은 두 평가자 간에 일치가 없음을 나타내고 1은 두 평가자 간의 완벽한 일치를 나타냅니다.

다음 표에는 Cohen의 카파의 다양한 값을 해석하는 방법이 요약되어 있습니다.

다음 단계별 예에서는 Cohen의 카파를 수동으로 계산하는 방법을 보여줍니다.

Cohen의 카파 계산: 단계별 예

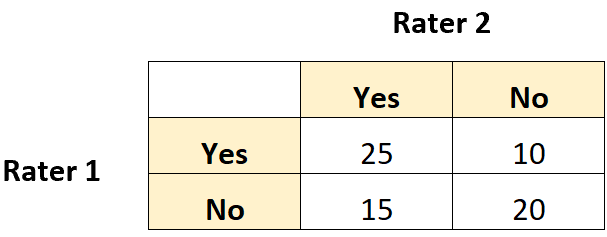

두 명의 박물관 큐레이터가 70점의 그림을 평가하여 새 전시회에 전시하기에 충분한지 확인하도록 요청받았다고 가정해 보겠습니다.

다음 2×2 표는 평가 결과를 보여줍니다.

1단계: 평가자 간의 상대적 합의( po )를 계산합니다.

먼저, 평가자 간의 상대적인 합의 정도를 계산하겠습니다. 이는 두 평가자가 모두 “예” 또는 “아니요”라고 대답한 총 점수의 비율입니다.

이를 다음과 같이 계산할 수 있습니다.

- p o = (둘 다 그렇다고 답함 + 둘 다 아니오라고 답함) / (총점)

- p o = (25 + 20) / (70) = 0.6429

2단계: 평가자 간의 우연 일치 확률(p e )을 계산합니다.

다음으로, 평가자가 순전히 우연에 따라 동의할 수 있는 확률을 계산해 보겠습니다.

이는 검토자 1이 “예”라고 답한 총 횟수를 총 응답 수로 나누고, 검토자 2가 “예”라고 답한 총 횟수를 곱한 후 총 응답 수로 나누어 총합에 더해 계산됩니다. 평가자 1이 “아니요”라고 말한 횟수에 평가자 2가 “아니요”라고 말한 총 횟수를 곱합니다.

이 예에서는 다음과 같이 계산됩니다.

- P(“예”) = ((25+10)/70) * ((25+15)/70) = 0.285714

- P(“아니오”) = ((15+20)/70) * ((10+20)/70) = 0.214285

- 피 = 0.285714 + 0.214285 = 0.5

3단계: Cohen의 카파 계산

마지막으로 p o 및 p e를 사용하여 Cohen의 카파를 계산합니다.

- k = ( po – p e ) / (1 – p e )

- k = (0.6429 – 0.5) / (1 – 0.5)

- k = 0.2857

Cohen의 Kappa는 0.2857 로 나타났습니다. 이전 표에 따르면 두 평가자는 “상당히” 수준의 합의만 했다고 말할 수 있습니다.

추가 리소스

이 Cohen의 카파 계산기를 사용하면 두 명의 평가자에 대한 Cohen의 카파를 자동으로 계산할 수 있습니다.