머신러닝의 편향-분산 트레이드오프는 무엇인가요?

데이터 세트에 대한 모델의 성능을 평가하려면 모델의 예측이 관찰된 데이터와 얼마나 잘 일치하는지 측정해야 합니다.

회귀 모델 의 경우 가장 일반적으로 사용되는 측정항목은 평균 제곱 오차(MSE)이며 다음과 같이 계산됩니다.

MSE = (1/n)*Σ(y i – f( xi )) 2

금:

- n: 총 관측치 수

- y i : i번째 관측값의 응답 값

- f(x i ): i 번째 관측치의 예측 반응 값

모델 예측이 관측값에 가까울수록 MSE는 낮아집니다.

그러나 우리는 MSE 테스트 , 즉 모델이 보이지 않는 데이터에 적용될 때의 MSE에만 관심이 있습니다. 이는 기존 데이터가 아닌 알려지지 않은 데이터에서 모델이 어떻게 작동하는지에만 관심이 있기 때문입니다.

예를 들어, 주가를 예측하는 모델이 과거 데이터에 대한 MSE가 낮다면 괜찮지 만 우리는 이 모델을 사용하여 미래 데이터를 정확하게 예측할 수 있기를 원합니다.

MSE 테스트는 여전히 두 부분으로 나눌 수 있는 것으로 나타났습니다.

(1) 분산: 다른 훈련 세트를 사용하여 추정한 경우 함수 f가 변경될 양을 나타냅니다.

(2) 편향: 매우 복잡할 수 있는 실제 문제를 훨씬 간단한 모델로 접근함으로써 발생하는 오류를 말합니다.

수학 용어로 작성:

MSE 검정 = Var( f̂( x 0 )) + [바이어스( f̂( x 0 ))] 2 + Var(ε)

MSE 테스트 = 분산 + 편향 2 + 비가역 오류

세 번째 항인 환원 불가능한 오류는 설명 변수 집합과 응답 변수 간의 관계에 항상 잡음이 있기 때문에 어떤 모델로도 줄일 수 없는 오류입니다.

편향이 높은 모델은 분산이 낮은 경향이 있습니다. 예를 들어, 선형 회귀 모델은 높은 편향(설명 변수와 응답 변수 사이의 단순한 선형 관계를 가정)과 낮은 분산(모델 추정치가 표본마다 크게 변하지 않음)을 갖는 경향이 있습니다. 다른).

그러나 편향이 낮은 모델은 분산 이 높은 경향이 있습니다. 예를 들어, 복잡한 비선형 모델은 편향이 낮고(설명 변수와 응답 변수 간의 특정 관계를 가정하지 않음) 분산이 높은 경향이 있습니다(모델 추정치는 학습 샘플에서 다른 학습 샘플로 크게 변경될 수 있음).

편향-분산 트레이드오프

편향-분산 트레이드오프(bias-variance trade-off) 는 편향을 감소시켜 일반적으로 분산을 증가시키거나 분산을 감소시켜 일반적으로 편향을 증가시키도록 선택할 때 발생하는 트레이드오프를 의미합니다.

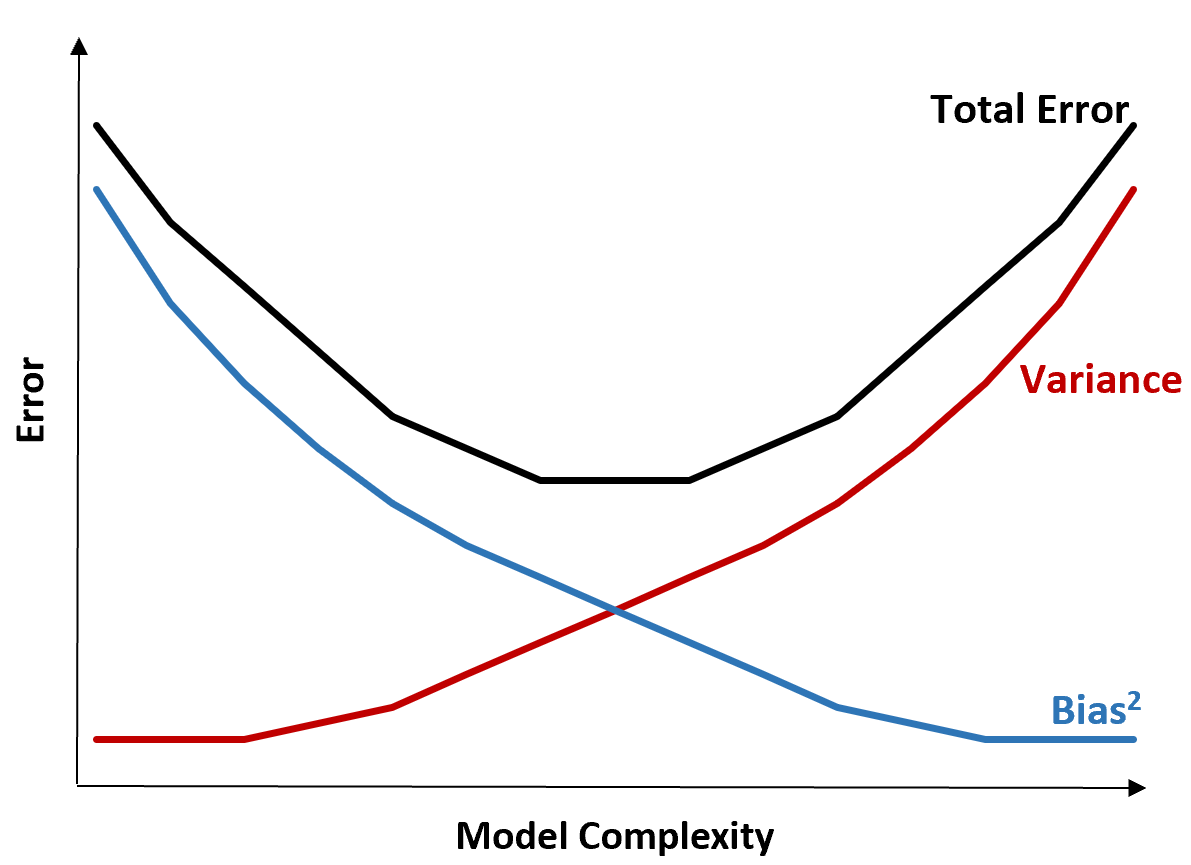

다음 그래프는 이러한 균형을 시각화하는 방법을 제공합니다.

전체 오류는 모델의 복잡성이 증가함에 따라 감소하지만 특정 지점까지만 가능합니다. 특정 지점을 넘어서면 분산이 증가하기 시작하고 전체 오류도 증가하기 시작합니다.

실제로 우리는 모델의 전체 오류를 최소화하는 데에만 관심이 있으며 분산이나 편향을 반드시 최소화하는 것은 아닙니다. 총 오류를 최소화하는 방법은 분산과 편향 사이의 올바른 균형을 찾는 것임이 밝혀졌습니다.

즉, 우리는 설명 변수와 응답 변수 사이의 실제 관계를 포착할 수 있을 만큼 충분히 복잡하지만 실제로 존재하지 않는 패턴을 감지할 만큼 너무 복잡하지는 않은 모델을 원합니다.

모델이 너무 복잡하면 데이터 에 과적합됩니다 . 이는 훈련 데이터에서 단순히 우연히 발생한 패턴을 찾는 것이 너무 어렵기 때문에 발생합니다. 이러한 유형의 모델은 보이지 않는 데이터에서는 성능이 저하될 가능성이 높습니다.

그러나 모델이 너무 단순하면 데이터를 과소평가하게 됩니다 . 이는 설명 변수와 반응 변수 간의 실제 관계가 실제보다 더 단순하다고 가정하기 때문에 발생합니다.

머신러닝에서 최적의 모델을 선택하는 방법은 편향과 분산 사이의 균형을 찾아 미래에 보이지 않는 데이터에 대해 모델을 테스트할 때 발생하는 오류를 최소화하는 것입니다.

실제로 테스트의 MSE를 최소화하는 가장 일반적인 방법은 교차 검증을 사용하는 것입니다.