평가자간 신뢰도란 무엇인가? (정의 & #038; 예)

통계에서 평가자 간 신뢰도는 여러 평가자 또는 심사위원 간의 동의 수준을 측정하는 방법입니다.

이는 테스트의 다양한 항목에 의해 생성된 응답의 신뢰성을 평가하는 데 사용됩니다. 테스트의 평가자 간 신뢰도가 낮은 경우 테스트 항목이 혼란스럽거나 불분명하거나 심지어 도움이 되지 않음을 나타낼 수 있습니다.

평가자 간 신뢰도를 측정하는 두 가지 일반적인 방법이 있습니다.

1. 동의율

평가자 간 신뢰도를 측정하는 간단한 방법은 심사위원이 동의하는 항목의 비율을 계산하는 것입니다.

이를 일치율(%) 이라고 하며 항상 0과 1 사이에 속합니다. 0은 평가자 간의 일치가 없음을 나타내고 1은 평가자 간의 완벽한 일치를 나타냅니다.

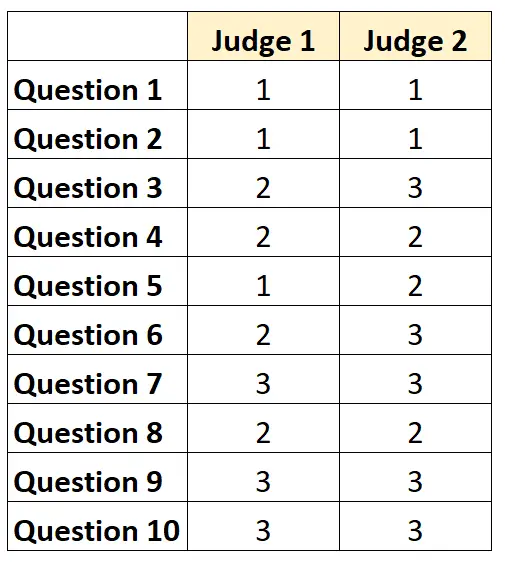

예를 들어, 두 명의 심사위원이 시험에서 10개 항목의 난이도를 1부터 3까지 평가하도록 요청받았다고 가정합니다. 결과는 다음과 같습니다.

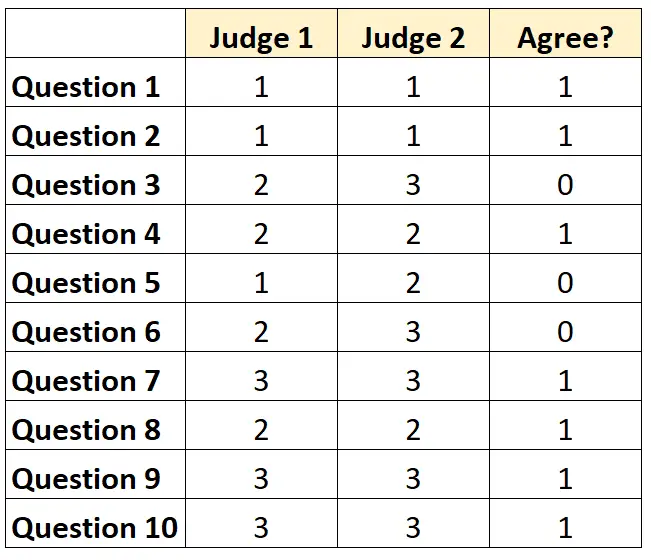

각 질문에 대해 두 심사위원이 모두 동의하면 ‘1’, 동의하지 않으면 ‘0’을 쓸 수 있습니다.

심사위원들이 동의한 질문의 비율은 7/10 = 70% 였습니다.

2. 코헨의 카파

평가자 간 신뢰도를 측정하는 가장 어렵고 가장 엄격한 방법은 평가자가 특정 요소에만 동의할 수 있다는 점을 고려하면서 평가자가 동의하는 항목의 비율을 계산하는 Cohen’s Kappa를 사용하는 것입니다. 다행스럽게도.

Cohen의 카파 공식은 다음과 같이 계산됩니다.

k = ( po – p e ) / (1 – p e )

금:

- p o : 평가자 간 상대적인 동의가 관찰됨

- p e : 우연 일치의 가상 확률

Cohen’s Kappa의 범위는 항상 0과 1 사이이며, 0은 평가자 간의 일치가 없음을 나타내고 1은 평가자 간의 완벽한 일치를 나타냅니다.

Cohen의 카파를 계산하는 방법에 대한 단계별 예를 보려면 이 튜토리얼을 참조하세요.

평가자 간 신뢰도를 해석하는 방법

평가자 간 신뢰도가 높을수록 다수의 심사위원이 비슷한 점수로 시험 항목이나 질문을 더 일관되게 평가합니다.

일반적으로 테스트가 신뢰할 수 있는 것으로 간주되려면 대부분의 영역에서 최소 75%의 평가자 간 합의가 필요합니다. 그러나 특정 영역에서는 더 높은 평가자 간 신뢰도가 필요할 수 있습니다.

예를 들어, 75%의 평가자 간 신뢰도는 텔레비전 프로그램이 얼마나 잘 수신되는지를 결정하는 테스트에 허용될 수 있습니다.

반면, 여러 의사가 특정 환자에게 특정 치료법을 사용해야 하는지 여부를 판단하는 의료 환경에서는 95%의 평가자 간 신뢰도가 필요할 수 있습니다.

대부분의 학문적 환경과 엄격한 연구 분야에서는 Cohen의 Kappa가 평가자 간 신뢰도를 계산하는 데 사용됩니다.

추가 리소스

신뢰성 분석에 대한 빠른 소개

신뢰성을 둘로 나눈다는 것은 무엇입니까?

테스트-재테스트 신뢰도란 무엇입니까?

병렬 형태 신뢰성이란 무엇입니까?

측정의 표준오차란 무엇입니까?

코헨의 카파 계산기