Cohen ၏ kappa ကို r ဖြင့် တွက်နည်း

စာရင်းဇယားများတွင်၊ Cohen’s Kappa သည် အကြောင်းအရာတစ်ခုစီကို သီးသန့်အမျိုးအစားများအဖြစ် ခွဲခြားပေးသည့် အဆင့်သတ်မှတ်သူ သို့မဟုတ် တရားသူကြီးနှစ်ဦးကြား သဘောတူညီချက်အဆင့်ကို တိုင်းတာရန် အသုံးပြုသည်။

Cohen ၏ kappa ဖော်မြူလာကို အောက်ပါအတိုင်း တွက်ချက်ပါသည်။

k = (p o – p e ) / (1 – p e )

ရွှေ-

- p o : အကဲဖြတ်သူများကြားတွင် ဆက်စပ်သဘောတူချက်

- p e : အခွင့်အလမ်းသဘောတူညီချက်၏ ယောင်ယောင်ဖြစ်နိုင်ခြေ

အဆင့်သတ်မှတ်သူများ သဘောတူသည့်အရာများ၏ ရာခိုင်နှုန်းကို ရိုးရိုးရှင်းရှင်း တွက်ချက်ခြင်းထက် Cohen ၏ Kappa သည် အချို့သောအရာများကို အခွင့်အခါသင့်ရုံဖြင့် သဘောတူနိုင်သည်ဟူသောအချက်ကို ထည့်သွင်းတွက်ချက်ရန် ကြိုးစားသည်။

Cohen’s Kappa ၏တန်ဖိုးသည် 0 နှင့် 1 အကြား အမြဲရှိသည်။

- ဝေဖန်သုံးသပ်သူနှစ်ဦးကြား သဘောတူညီချက်မရှိဟု ၀ န ်ခံဖော်ပြသည်။

- 1 သည် အကဲဖြတ်သူနှစ်ဦးကြား ပြီးပြည့်စုံသောသဘောတူညီချက်ကို ညွှန်ပြသည်။

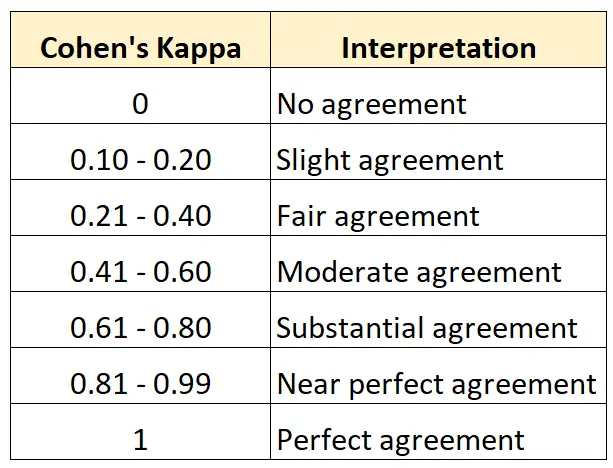

အောက်ပါဇယားသည် Cohen’s Kappa ၏ မတူညီသောတန်ဖိုးများကို မည်သို့အဓိပ္ပာယ်ဖွင့်ဆိုရမည်ကို အကျဉ်းချုပ်ဖော်ပြထားသည်-

R တွင် Cohen ၏ Kappa ကိုတွက်ချက်ရန် အလွယ်ကူဆုံးနည်းလမ်းမှာ psych package မှ cohen.kappa() လုပ်ဆောင်ချက်ကို အသုံးပြုခြင်းဖြစ်သည်။

အောက်ဖော်ပြပါ ဥပမာသည် ဤလုပ်ဆောင်ချက်ကို လက်တွေ့အသုံးချနည်းကို ပြသထားသည်။

ဥပမာ- Cohen ၏ Kappa ကို R ဖြင့် တွက်ချက်ပါ။

ပန်းချီပြတိုက်တစ်ခုရှိ ပြတိုက်မှူးနှစ်ဦးသည် ပန်းချီကား ၁၅ ချပ်ကို ပြပွဲအသစ်တွင် ပြသရန် လုံလောက်မှုရှိမရှိ စစ်ဆေးရန် တောင်းဆိုထားသည်ဆိုပါစို့။

အောက်ပါကုဒ်သည် အဆင့်သတ်မှတ်သူနှစ်ဦးအတွက် Cohen’s Kappa ကိုတွက်ချက်ရန် psych package ၏ cohen.kappa() လုပ်ဆောင်ချက်ကို မည်သို့အသုံးပြုရမည်ကို ပြသသည်-

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

ခန့်မှန်း ကော်လံသည် Cohen ၏ Kappa တန်ဖိုးကိုပြသသည်။

ရလဒ်မှ၊ Cohen ၏ Kappa သည် 0.34 ဖြစ်သွားသည်ကိုကျွန်ုပ်တို့သိနိုင်သည်။

ယခင်ဇယားကိုအခြေခံ၍ အဆင့်သတ်မှတ်သူနှစ်ဦးသည် “ မျှမျှတတ” သဘောတူညီချက်သာရှိသည်ဟု ကျွန်ုပ်တို့ပြောနိုင်သည်။

3 သို့မဟုတ် ထို့ထက်ပိုသော အဆင့်သတ်မှတ်သူများအကြား သဘောတူညီချက်အဆင့်ကို တွက်ချက်လိုပါက၊ ၎င်းအစား Fleiss’ Kappa ကို အသုံးပြုရန် အကြံပြုအပ်ပါသည်။

ထပ်လောင်းအရင်းအမြစ်များ

အောက်ဖော်ပြပါ သင်ခန်းစာများသည် Cohen’s Kappa တွင် နောက်ထပ်အရင်းအမြစ်များကို ပံ့ပိုးပေးသည်-

Cohen ၏ Kappa မိတ်ဆက်

အွန်လိုင်း Cohen ၏ Kappa ဂဏန်းတွက်စက်

Excel တွင် Cohen ၏ Kappa တွက်ချက်နည်း

Python တွင် Cohen’s Kappa တွက်နည်း