Inter-rater reliability ဆိုတာ ဘာလဲ။ (အဓိပ္ပါယ် & #038; ဥပမာ)

စာရင်းဇယားများတွင်၊ အပြန်အလှန်အကဲဖြတ်သူများ၏ ယုံကြည်စိတ်ချရမှုသည် အဆင့်သတ်မှတ် သူများ သို့မဟုတ် တရားသူကြီးအများအပြားအကြား သဘောတူညီချက်အဆင့်ကို တိုင်းတာသည့်နည်းလမ်းတစ်ခုဖြစ်သည်။

စမ်းသပ်မှုတစ်ခုတွင် မတူညီသည့်အရာများမှ ထုတ်လုပ်သော တုံ့ပြန်မှုများ၏ ယုံကြည်စိတ်ချရမှုကို အကဲဖြတ်ရန် ၎င်းကို အသုံးပြုသည်။ အကယ်၍ စမ်းသပ်မှုတစ်ခုတွင် အဆင့်သတ်မှတ်ခြင်းဆိုင်ရာ ယုံကြည်စိတ်ချရမှု နည်းပါးပါက၊ စစ်ဆေးမှုအရာများသည် ရှုပ်ထွေးခြင်း၊ မရှင်းလင်းခြင်း သို့မဟုတ် အကူအညီပင်မဖြစ်နိုင်ကြောင်း ညွှန်ပြနိုင်သည်။

Inter-rater ယုံကြည်စိတ်ချရမှုကို တိုင်းတာရန် ဘုံနည်းလမ်းနှစ်ခုရှိသည်။

သဘောတူညီချက်၏ ၁ ရာခိုင်နှုန်း

အကဲဖြတ်သူများကြား ယုံကြည်စိတ်ချရမှုကို တိုင်းတာရန် ရိုးရှင်းသောနည်းလမ်းမှာ တရားသူကြီးများ သဘောတူသည့်အရာများ၏ ရာခိုင်နှုန်းကို တွက်ချက်ခြင်းဖြစ်သည်။

၎င်းကို 0 နှင့် 1 ကြားတွင် အမြဲရှိနေသော ရာခိုင်နှုန်းသဘောတူညီချက် ဟုခေါ်သည်၊ 0 သည် အဆင့်သတ်မှတ်သူများနှင့် 1 အကြား ပြီးပြည့်စုံသောသဘောတူညီချက်ကို ညွှန်ပြသည့် 0 နှင့် အဆင့်သတ်မှတ်သူများကြား ပြီးပြည့်စုံသောသဘောတူညီချက်ကို ညွှန်ပြသည့် 0 ရာခိုင်နှုန်းသဘောတူညီချက်ဟုခေါ်သည်။

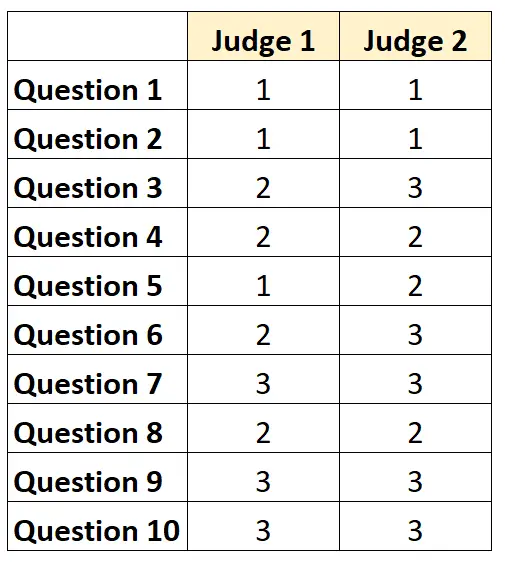

ဥပမာအားဖြင့်၊ တရားသူကြီးနှစ်ဦးအား 1 မှ 3 အတိုင်းအတာဖြင့် စမ်းသပ်မှုတစ်ခုတွင် အကြောင်းအရာ 10 ခု၏အခက်အခဲကို အဆင့်သတ်မှတ်ခိုင်းသည်ဆိုပါစို့။ ရလဒ်များကို အောက်တွင်ဖော်ပြထားသည်-

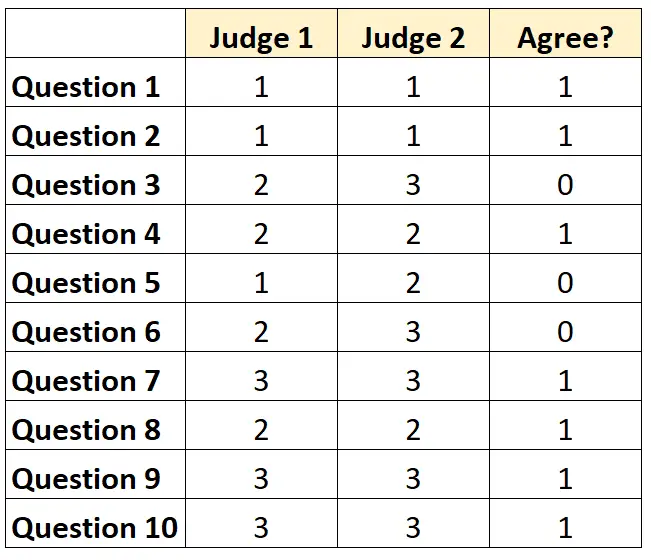

မေးခွန်းတစ်ခုစီအတွက် တရားသူကြီးနှစ်ဦးသဘောတူပါက “1” နှင့် “0” တို့ကို သဘောမတူပါက “1” ဟုရေးနိုင်ပါသည်။

တရားသူကြီးတွေ သဘောတူတဲ့ မေးခွန်းရာခိုင်နှုန်းက 7/10 = 70% ဖြစ်ပါတယ်။

2. Cohen’s Kappa

အဆင့်သတ်မှတ်သူများကြား ယုံကြည်စိတ်ချရမှုကို တိုင်းတာရန် အခက်ခဲဆုံး (နှင့် အပြင်းထန်ဆုံး) နည်းလမ်းမှာ အဆင့်သတ်မှတ်သူများ သဘောတူသည့်အရာများ၏ ရာခိုင်နှုန်းကို တွက်ချက်ပေးသည့် Cohen’s Kappa ကို အသုံးပြုကာ အဆင့်သတ်မှတ်သူများသည် အချို့သောဒြပ်စင်များပေါ်တွင်သာ သဘောတူနိုင်သည်ဟု ထည့်သွင်းစဉ်းစားကာ အသုံးပြုခြင်းဖြစ်သည်။ ကံအားလျော်စွာ။

Cohen ၏ kappa ဖော်မြူလာကို အောက်ပါအတိုင်း တွက်ချက်ပါသည်။

k = (p o – p e ) / (1 – p e )

ရွှေ-

- p o : အကဲဖြတ်သူများကြားတွင် ဆက်စပ်သဘောတူချက်

- p e : အခွင့်အလမ်းသဘောတူညီချက်၏ ယောင်ယောင်ဖြစ်နိုင်ခြေ

Cohen ၏ Kappa သည် 0 နှင့် 1 ကြားတွင် အမြဲတမ်း ကွာဟပြီး အဆင့်သတ်မှတ်သူများနှင့် 1 ကြား သဘောတူညီချက်မရှိဟု ညွှန်ပြပြီး အဆင့်သတ်မှတ်သူများကြား ပြီးပြည့်စုံသော သဘောတူညီချက်ကို ညွှန်ပြသော 0 ဖြစ်သည်။

Cohen’s Kappa တွက်နည်း အဆင့်ဆင့် ဥပမာအတွက်၊ ဤသင်ခန်းစာကို ကြည့်ပါ။

inter-rater reliability ကို ဘယ်လိုအဓိပ္ပာယ်ဖွင့်မလဲ။

အပြန်အလှန်အကဲဖြတ်သူများ၏ ယုံကြည်စိတ်ချရမှု မြင့်မားလေ၊ အလားတူရမှတ်များရှိသော စာမေးပွဲတစ်ခုတွင် တရားသူကြီးများစွာသည် အကြောင်းအရာများ သို့မဟုတ် မေးခွန်းများကို ဆက်တိုက် အမှတ်ပေးလေလေဖြစ်သည်။

ယေဘူယျအားဖြင့်၊ ယုံကြည်စိတ်ချရသော စမ်းသပ်မှုတစ်ခုအတွက် နယ်ပယ်အများစုတွင် အနည်းဆုံး 75% အချင်းချင်းကြား သဘောတူညီချက်တစ်ခု လိုအပ်ပါသည်။ သို့ရာတွင်၊ သီးခြားဒိုမိန်းများတွင် ပိုမိုမြင့်မားသော အဆင့်သတ်မှတ်မှုဆိုင်ရာ ယုံကြည်စိတ်ချရမှု လိုအပ်နိုင်ပါသည်။

ဥပမာအားဖြင့်၊ ရုပ်မြင်သံကြားအစီအစဉ်တစ်ခုအား မည်မျှလက်ခံရရှိမည်ကို ဆုံးဖြတ်ရန် စမ်းသပ်မှုတစ်ခုအတွက် 75% ၏ ယုံကြည်စိတ်ချရမှုသည် လက်ခံနိုင်ဖွယ်ရှိသည်။

အခြားတစ်ဖက်တွင်၊ ပေးထားသည့်လူနာအတွက် ကုသမှုတစ်ခုအား အသုံးပြုသင့်သည် ရှိ/မရှိကို သမားတော်အများအပြားက ဆုံးဖြတ်ပေးသော ဆေးဘက်ဆိုင်ရာဆက်တင်များတွင် အချင်းချင်းကြားယုံကြည်စိတ်ချရမှု 95% လိုအပ်ပါသည်။

ပညာရပ်ဆိုင်ရာ ဆက်တင်အများစုနှင့် ပြင်းထန်သော သုတေသနနယ်ပယ်များတွင် Cohen’s Kappa ကို အပြန်အလှန်အကဲဖြတ်သူများ၏ ယုံကြည်စိတ်ချရမှုကို တွက်ချက်ရန် အသုံးပြုကြောင်း သတိပြုပါ။

ထပ်လောင်းအရင်းအမြစ်များ

ယုံကြည်စိတ်ချရမှု ခွဲခြမ်းစိတ်ဖြာခြင်းအတွက် အမြန်နိဒါန်း

ယုံကြည်စိတ်ချရမှုဆိုတာ ဘာလဲ ?

စမ်းသပ်မှု-ပြန်လည်စမ်းသပ်မှု ယုံကြည်စိတ်ချရမှုဟူသည် အဘယ်နည်း။

Parallel Form များ၏ ယုံကြည်စိတ်ချရမှုသည် အဘယ်နည်း။

တိုင်းတာခြင်း၏ စံလွဲချော်မှုမှာ အဘယ်နည်း။

Cohen ၏ Kappa ဂဏန်းတွက်စက်