K-fold cross-validation အတွက် ရိုးရှင်းသောလမ်းညွှန်

ဒေတာအတွဲတစ်ခုပေါ်ရှိ မော်ဒယ်တစ်ခု၏စွမ်းဆောင်ရည်ကို အကဲဖြတ်ရန်၊ ကျွန်ုပ်တို့သည် မော်ဒယ်မှပြုလုပ်သော ခန့်မှန်းချက်များသည် စောင့်ကြည့်လေ့လာထားသောဒေတာနှင့် မည်မျှကိုက်ညီကြောင်း တိုင်းတာရန် လိုအပ်ပါသည်။

၎င်းကိုတိုင်းတာရန်အသုံးအများဆုံးနည်းလမ်းမှာ အောက်ပါအတိုင်းတွက်ချက်ထားသည့် mean square error (MSE) ကိုအသုံးပြုခြင်းဖြစ်သည်။

MSE = (1/n)*Σ(y i – f(x i )) ၂

ရွှေ-

- n- လေ့လာတွေ့ရှိချက်စုစုပေါင်း

- y i : IT Observation ၏ တုံ့ပြန်မှုတန်ဖိုး

- f(x i ): i th observation ၏ ခန့်မှန်းထားသော တုံ့ပြန်မှုတန်ဖိုး

မော်ဒယ်ခန့်မှန်းချက်များသည် စောင့်ကြည့်မှုများနှင့် နီးကပ်လေ၊ MSE သည် နိမ့်လေဖြစ်သည်။

လက်တွေ့တွင်၊ ကျွန်ုပ်တို့သည် သတ်မှတ်ပုံစံတစ်ခု၏ MSE ကို တွက်ချက်ရန် အောက်ပါလုပ်ငန်းစဉ်ကို အသုံးပြုသည်-

1. ဒေတာအစုံကို လေ့ကျင့်ရေးအစုံနှင့် စမ်းသပ်မှုအစုံသို့ ခွဲပါ။

2. လေ့ကျင့်မှုအစုံမှ အချက်အလက်များကိုသာ အသုံးပြု၍ မော်ဒယ်ကို ဖန်တီးပါ။

3. စမ်းသပ်မှုသတ်မှတ်မှုနှင့်ပတ်သက်ပြီး ခန့်မှန်းချက်များပြုလုပ်ရန်နှင့် စစ်ဆေးမှု၏ MSE ကိုတိုင်းတာရန် မော်ဒယ်ကိုအသုံးပြုပါ။

MSE စမ်းသပ်ခြင်းသည် မော်ဒယ်တစ်ခုသည် ယခင်ကမမြင်ဖူးသော ဒေတာများပေါ်တွင် မည်မျှ ကောင်းမွန်စွာ လုပ်ဆောင်နိုင်သည်ကို အကြံဥာဏ်ပေးသည်။ သို့သော်၊ တစ်ခုတည်းသောစမ်းသပ်မှုအစုံကိုအသုံးပြုခြင်း၏အားနည်းချက်မှာ MSE စာမေးပွဲသည်လေ့ကျင့်ရေးနှင့်စမ်းသပ်မှုအစုံတွင်အသုံးပြုသောလေ့လာတွေ့ရှိချက်များပေါ်မူတည်ပြီးသိသိသာသာကွဲပြားနိုင်သည်။

ဤပြဿနာကို ရှောင်ရှားရန် နည်းလမ်းတစ်ခုမှာ မတူညီသော လေ့ကျင့်မှုနှင့် စမ်းသပ်မှုတစ်ခုစီကို အသုံးပြု၍ မော်ဒယ်တစ်ခုအား အကြိမ်များစွာ အံဝင်ခွင်ကျဖြစ်စေရန်ဖြစ်ပြီး၊ ထို့နောက် စမ်းသပ်မှု MSE ကို စမ်းသပ်မှုအားလုံး၏ ပျမ်းမျှအဖြစ် MSE ကို တွက်ချက်ခြင်းဖြစ်သည်။

ဤယေဘူယျနည်းလမ်းကို cross-validation ဟုခေါ်ပြီး ၎င်း၏ သီးခြားပုံစံကို k-fold cross-validation ဟုခေါ်သည်။

K-Fold အပြန်အလှန်အတည်ပြုချက်

K-fold cross-validation သည် မော်ဒယ်တစ်ခုကို အကဲဖြတ်ရန် အောက်ပါချဉ်းကပ်နည်းကို အသုံးပြုသည်-

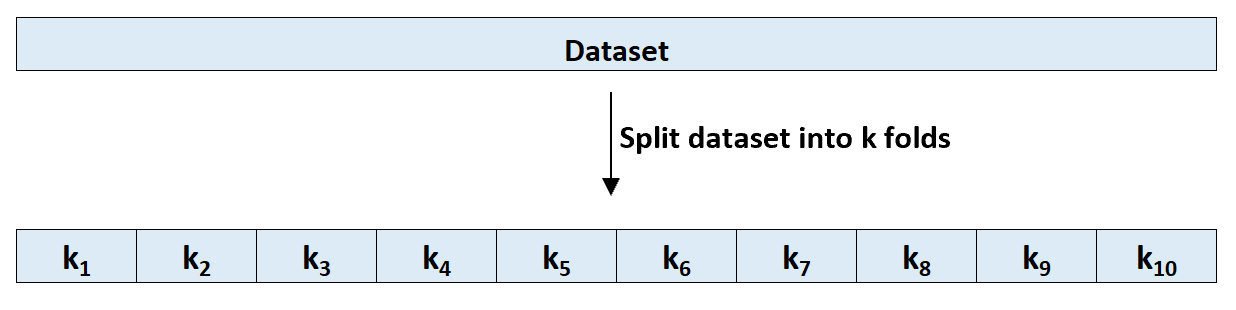

အဆင့် 1- ခန့်မှန်းခြေ တူညီသော အရွယ်အစားရှိသော k အုပ်စုများ သို့မဟုတ် “ folds” တွင် သတ်မှတ်ထားသော ဒေတာကို ကျပန်းခွဲပါ။

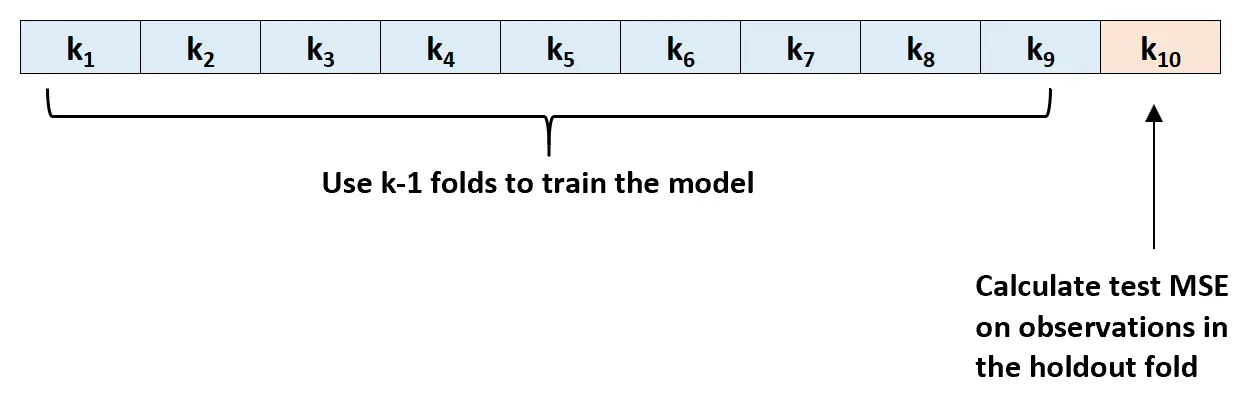

အဆင့် 2- သင်၏ကိုင်ဆောင်ထားသည့်အစုံအဖြစ် ခေါက်များထဲမှ တစ်ခုကို ရွေးပါ။ နမူနာကို ကျန် k-1 ခေါက်သို့ ချိန်ညှိပါ။ တင်းမာနေသော အထပ်တွင် လေ့လာတွေ့ရှိချက်များကို MSE စာမေးပွဲကို တွက်ချက်ပါ။

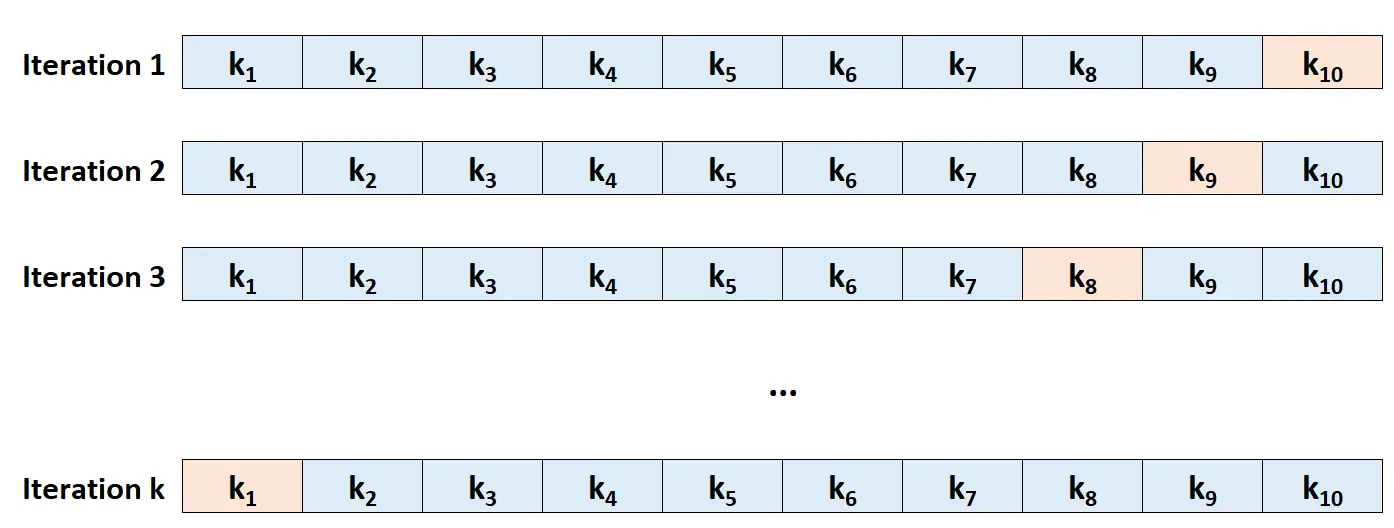

အဆင့် 3- ဤလုပ်ငန်းစဉ် k ကြိမ်ကို ဖယ်ထုတ်ခြင်းအဖြစ် မတူညီသောအစုံကို အသုံးပြုပြီးတိုင်း၊ အကြိမ်တိုင်း ပြန်လုပ်ပါ။

အဆင့် 4- စာမေးပွဲ၏ k MSE ပျမ်းမျှအဖြစ် စာမေးပွဲ၏ အလုံးစုံ MSE ကို တွက်ချက်ပါ။

စမ်းသပ်ခြင်း MSE = (1/k)*ΣMSE i

ရွှေ-

- k: ခေါက်အရေအတွက်

- MSE i : iteration တွင် MSE ကို စမ်းသပ်ပါ။

K ကိုဘယ်လိုရွေးမလဲ။

ယေဘူယျအားဖြင့်၊ k-fold cross-validation တွင်ကျွန်ုပ်တို့အသုံးပြုသော folds များလေ၊ MSE test bias နည်းပါးလေဖြစ်သော်လည်း ကွဲလွဲမှု ပိုများလေဖြစ်သည်။ အပြန်အလှန်အားဖြင့်၊ ကျွန်ုပ်တို့အသုံးပြုသော အခေါက်များနည်းလေ၊ ဘက်လိုက်မှု မြင့်မားသော်လည်း ကွဲလွဲမှု နည်းပါးလေဖြစ်သည်။ ၎င်းသည် စက်သင်ယူမှုတွင် ဘက်လိုက်မှုကွဲလွဲမှု ဖလှယ်မှု၏ ဂန္တဝင်ဥပမာတစ်ခုဖြစ်သည်။

လက်တွေ့တွင်၊ ကျွန်ုပ်တို့သည် ယေဘူယျအားဖြင့် 5 နှင့် 10 pies အကြားအသုံးပြုရန်ရွေးချယ်သည်။ ကိန်းဂဏန်းလေ့လာခြင်းဆိုင်ရာ နိဒါန်း တွင် ဖော်ပြထားသည့်အတိုင်း၊ ဤအကြိမ်အရေအတွက်သည် ဘက်လိုက်မှုနှင့် ကွဲလွဲမှုကြား အကောင်းဆုံးချိန်ခွင်လျှာကို ပေးဆောင်ရန် ပြသထားပြီး ထို့ကြောင့် စာမေးပွဲ၏ MSE ၏ ယုံကြည်စိတ်ချရသော ခန့်မှန်းချက်များကို ပေးဆောင်သည်-

အနှစ်ချုပ်ရရန်၊ k-fold အပြန်အလှန်တရားဝင်စစ်ဆေးခြင်းတွင် k ရွေးချယ်မှုနှင့် ဆက်စပ်နေသော ဘက်လိုက်မှုကွဲလွဲမှု ဖလှယ်မှုတစ်ခု ရှိပါသည်။

ပုံမှန်အားဖြင့်၊ ဤထည့်သွင်းစဉ်းစားမှုများပေးထားသော၊ တစ်ခုသည် k = 5 သို့မဟုတ် k = 10 ကိုအသုံးပြု၍ k-fold အပြန်အလှန်အတည်ပြုခြင်းကိုလုပ်ဆောင်သည်၊ အဘယ်ကြောင့်ဆိုသော် ဤတန်ဖိုးများသည် ဘက်လိုက်မှုမမြင့်မားဘဲ အလွန်မြင့်မားသောကွဲလွဲမှုမခံစားရသည့် စမ်းသပ်မှုအမှားအယွင်းနှုန်းခန့်မှန်းချက်များကို ရလဒ်အဖြစ် မျက်မြင်ကိုယ်တွေ့ပြသထားသောကြောင့်ဖြစ်သည်။

စာမျက်နှာ 184၊ ကိန်းဂဏန်းလေ့လာခြင်း နိဒါန်း

K-Fold Cross-Validation ၏အကျိုးကျေးဇူးများ

ကျွန်ုပ်တို့သည် ဒေတာအတွဲတစ်ခုကို လေ့ကျင့်ရေးအစုတစ်ခုနှင့် တစ်ခုတည်းသောစမ်းသပ်မှုတစ်ခုအဖြစ် ပိုင်းခြားသောအခါ၊ စာမေးပွဲအစုံရှိ လေ့လာတွေ့ရှိချက်များကို တွက်ချက်ထားသော MSE သည် လေ့ကျင့်သင်ကြားမှုနှင့် စာမေးပွဲများတွင် အသုံးပြုသည့် လေ့လာတွေ့ရှိချက်များပေါ်မူတည်၍ သိသိသာသာ ကွဲပြားနိုင်သည်။

k-fold cross validation ကိုအသုံးပြုခြင်းဖြင့်၊ ကျွန်ုပ်တို့သည် မတူညီသော လေ့ကျင့်မှုနှင့် စမ်းသပ်မှုအစုံများကို အသုံးပြု၍ MSE စာမေးပွဲကို တွက်ချက်နိုင်သည်။ ၎င်းသည် ကျွန်ုပ်တို့အား စာမေးပွဲ၏ MSE ၏ ဘက်မလိုက်သော ခန့်မှန်းချက်တစ်ခု ရရှိရန် အခွင့်အလမ်းများစွာကို ပေးသည်။

K-fold cross-validation သည် Leave-One-Out Cross-Validation (LOOCV) ၏ တွက်ချက်မှုဆိုင်ရာ အားသာချက်ကိုလည်း ပေးစွမ်းသောကြောင့် ၎င်းသည် n အမြှောက်အစား မော်ဒယ် k နှင့် အံဝင်ခွင်ကျဖြစ်နေသောကြောင့် ဖြစ်သည်။

ကိုက်ညီရန် အချိန်ကြာမြင့်သော မော်ဒယ်များအတွက်၊ k-fold cross-validation သည် စမ်းသပ်မှု MSE ကို LOOCV ထက် များစွာပိုမိုမြန်ဆန်စွာ တွက်ချက်နိုင်ပြီး အများအပြားတွင် ချဉ်းကပ်မှုတစ်ခုစီမှ တွက်ချက်ထားသော MSE သည် လုံလောက်သော ခေါက်အရေအတွက်ကို အသုံးပြုပါက အလွန်ဆင်တူပါသည်။

K-Fold Cross-Validation တိုးချဲ့မှုများ

k-fold cross-validation အတွက် extension များစွာ ရှိသည်၊၊

ထပ်ခါတလဲလဲ k-fold cross-validation- ဤနေရာတွင် k-fold cross-validation ကို ရိုးရိုး n အကြိမ်အဖြစ် ထပ်ခါတလဲလဲလုပ်ပါသည်။ လေ့ကျင့်ရေးနှင့် စမ်းသပ်မှုအစုံများ ရောနှောသည့်အခါတိုင်း၊ ၎င်းသည် သာမာန် k-fold အပြန်အလှန်စစ်ဆေးခြင်းထက် ပြီးမြောက်ရန် ပိုကြာသော်လည်း၊ ၎င်းသည် စစ်ဆေးမှု MSE ခန့်မှန်းချက်တွင် ဘက်လိုက်မှုကို ပိုမိုလျှော့ချပေးသည်။

Leave-One-Out Cross-Validation- ၎င်းသည် k = n ဖြစ်သည့် k-fold အပြန်အလှန်စစ်ဆေးခြင်း၏ အထူးကိစ္စရပ်ဖြစ်သည်။ ဤနည်းလမ်းကို ဤနေရာတွင် သင်ပိုမိုလေ့လာနိုင်ပါသည်။

Stratified k-fold cross-validation- ဤသည် k-fold cross-validation ဗားရှင်းတစ်ခုဖြစ်ပြီး ဒေတာအတွဲအား fold တစ်ခုစီကိုကိုယ်စားပြုသည့်ပုံစံဖြင့် ပြန်လည်စီစဉ်ထားသည့်ပုံစံဖြစ်သည်။ Kohavi မှ မှတ်ချက်ပြုထားသည့်အတိုင်း၊ ဤနည်းလမ်းသည် သာမန် k-fold cross-validation နှင့် နှိုင်းယှဉ်ပါက ဘက်လိုက်မှုနှင့် ကွဲလွဲမှုအကြား ပိုမိုကောင်းမွန်သော အပေးအယူကို ပေးစွမ်းနိုင်သည် ။

Nested Cross-Validation- ဤနေရာတွင် k-fold အပြန်အလှန် validation ကို လုပ်ဆောင်သည် မော်ဒယ်အကဲဖြတ်စဉ်အတွင်း ဟိုက်ပါပါရာမီတာ ချိန်ညှိခြင်းကို လုပ်ဆောင်ရန် ၎င်းကို မကြာခဏ အသုံးပြုသည်။