Hoe cohen's kappa in r te berekenen

In de statistieken wordt Cohen’s Kappa gebruikt om de mate van overeenstemming te meten tussen twee beoordelaars of juryleden die elk item in elkaar uitsluitende categorieën indelen.

De Cohen’s Kappa-formule wordt als volgt berekend:

k = (p o – p e ) / (1 – p e )

Goud:

- p o : Relatieve overeenstemming waargenomen tussen de beoordelaars

- p e : Hypothetische waarschijnlijkheid van toevalsovereenkomst

In plaats van eenvoudigweg het percentage items te berekenen waarover beoordelaars het eens zijn, probeert Cohen’s Kappa rekening te houden met het feit dat beoordelaars het louter bij toeval over sommige items eens kunnen zijn.

De waarde van Cohen’s Kappa ligt altijd tussen 0 en 1 waarbij:

- 0 geeft aan dat er geen overeenstemming is tussen de twee reviewers

- 1 duidt op een perfecte overeenstemming tussen de twee beoordelaars

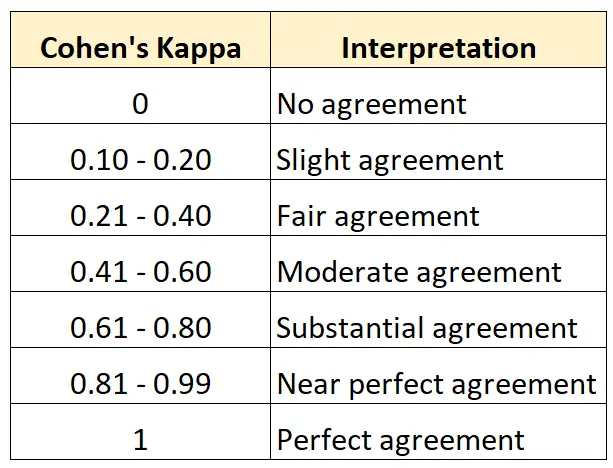

De volgende tabel vat samen hoe de verschillende waarden van Cohen’s Kappa moeten worden geïnterpreteerd:

De eenvoudigste manier om Cohen’s Kappa in R te berekenen is door de functie cohen.kappa() uit het psych- pakket te gebruiken.

Het volgende voorbeeld laat zien hoe u deze functie in de praktijk kunt gebruiken.

Voorbeeld: Bereken Cohen’s Kappa in R

Stel dat twee conservatoren van een kunstmuseum wordt gevraagd vijftien schilderijen te beoordelen om te zien of ze goed genoeg zijn om in een nieuwe tentoonstelling te worden getoond.

De volgende code laat zien hoe u de functie cohen.kappa() van het psych- pakket gebruikt om Cohen’s Kappa voor de twee beoordelaars te berekenen:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

In de schattingskolom wordt de Cohen’s Kappa-waarde weergegeven.

Uit het resultaat kunnen we zien dat Cohen’s Kappa 0,34 blijkt te zijn.

Op basis van de vorige tabel zouden we zeggen dat de twee beoordelaars slechts een “redelijk” niveau van overeenstemming hadden.

Als u de mate van overeenstemming tussen drie of meer beoordelaars wilt berekenen, kunt u het beste Fleiss‘ Kappa gebruiken.

Aanvullende bronnen

De volgende tutorials bieden aanvullende informatie over Cohen’s Kappa:

Inleiding tot Cohen’s Kappa

Online Cohen’s Kappa-calculator

Hoe Cohen’s Kappa in Excel te berekenen

Hoe Cohen’s Kappa in Python te berekenen