Cohen's kappa-statistiek: definitie en voorbeeld

Cohen’s Kappa-statistiek wordt gebruikt om de mate van overeenstemming te meten tussen twee beoordelaars of juryleden die elk items in elkaar uitsluitende categorieën classificeren.

De Cohen’s Kappa-formule wordt als volgt berekend:

k = (p o – p e ) / (1 – p e )

Goud:

- p o : Relatieve overeenstemming waargenomen tussen de beoordelaars

- p e : Hypothetische waarschijnlijkheid van toevalsovereenkomst

In plaats van eenvoudigweg het percentage items te berekenen waarover beoordelaars het eens zijn, probeert Cohen’s Kappa rekening te houden met het feit dat beoordelaars het louter bij toeval over sommige items eens kunnen zijn.

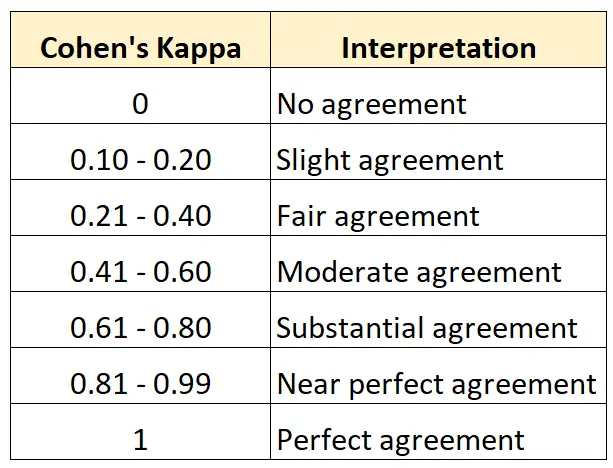

Hoe Cohen’s Kappa te interpreteren

Cohen’s Kappa ligt altijd tussen 0 en 1, waarbij 0 aangeeft dat er geen overeenstemming is tussen de twee beoordelaars en 1 een perfecte overeenstemming tussen de twee beoordelaars aangeeft.

De volgende tabel vat samen hoe de verschillende waarden van Cohen’s Kappa moeten worden geïnterpreteerd:

Het volgende stapsgewijze voorbeeld laat zien hoe u Cohen’s Kappa handmatig kunt berekenen.

Bereken Cohen’s Kappa: stap voor stap voorbeeld

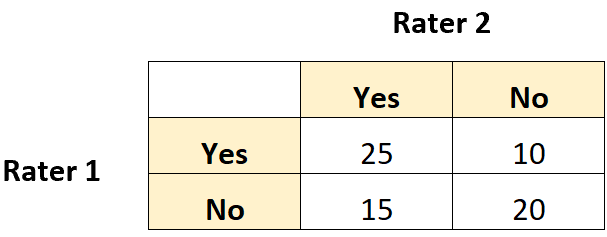

Stel dat twee museumconservatoren wordt gevraagd zeventig schilderijen te beoordelen om te zien of ze goed genoeg zijn voor een nieuwe tentoonstelling.

De volgende 2×2 tabel toont de resultaten van de evaluaties:

Stap 1: Bereken de relatieve overeenstemming (p o ) tussen beoordelaars.

Eerst berekenen we de relatieve overeenstemming tussen beoordelaars. Dit is eenvoudigweg het aandeel van de totaalscores waarop beide beoordelaars “Ja” of “Nee” hebben geantwoord.

Dit kunnen we als volgt berekenen:

- p o = (Beide zeiden ja + Beiden zeiden nee) / (Totale scores)

- p o = (25 + 20) / (70) = 0,6429

Stap 2: Bereken de hypothetische waarschijnlijkheid van toevallige overeenstemming ( pe ) tussen beoordelaars.

Vervolgens berekenen we de waarschijnlijkheid dat de beoordelaars het puur geluk eens konden worden.

Dit wordt berekend als het totale aantal keren dat beoordelaar 1 ‚Ja‘ heeft gezegd, gedeeld door het totale aantal reacties, vermenigvuldigd met het totale aantal keren dat beoordelaar 2 ‚Ja‘ heeft gezegd, gedeeld door het totale aantal reacties, opgeteld bij het totaal. aantal keren dat beoordelaar 1 „Nee“ heeft gezegd, vermenigvuldigd met het totaal aantal keren dat beoordelaar 2 „Nee“ heeft gezegd.

Voor ons voorbeeld wordt dit als volgt berekend:

- P(“Ja”) = ((25+10)/70) * ((25+15)/70) = 0,285714

- P(“Nee”) = ((15+20)/70) * ((10+20)/70) = 0,214285

- p e = 0,285714 + 0,214285 = 0,5

Stap 3: Bereken Cohen’s Kappa

Ten slotte zullen we p o en p e gebruiken om Cohen’s Kappa te berekenen:

- k = (p o – p e ) / (1 – p e )

- k = (0,6429 – 0,5) / (1 – 0,5)

- k = 0,2857

Cohen’s Kappa blijkt 0,2857 te zijn. Op basis van de vorige tabel zouden we zeggen dat de twee beoordelaars slechts een “redelijk” niveau van overeenstemming hadden.

Aanvullende bronnen

U kunt deze Cohen’s Kappa-calculator gebruiken om automatisch Cohen’s Kappa voor twee beoordelaars te berekenen.