Wat is interbeoordelaarsbetrouwbaarheid? (definitie & #038; voorbeeld)

In de statistiek is interbeoordelaarsbetrouwbaarheid een manier om de mate van overeenstemming tussen meerdere beoordelaars of rechters te meten.

Het wordt gebruikt om de betrouwbaarheid te beoordelen van de antwoorden die door verschillende items op een test worden geproduceerd. Als een test een lagere interbeoordelaarsbetrouwbaarheid heeft, kan dit erop duiden dat de testitems verwarrend, onduidelijk of zelfs nutteloos zijn.

Er zijn twee veelgebruikte manieren om de interbeoordelaarsbetrouwbaarheid te meten:

1. Percentage akkoord

De eenvoudige manier om de interbeoordelaarsbetrouwbaarheid te meten, is door het percentage items te berekenen waarover de juryleden het eens zijn.

Dit wordt procentuele overeenstemming genoemd en ligt altijd tussen 0 en 1, waarbij 0 aangeeft dat er geen overeenstemming is tussen de beoordelaars en 1 een perfecte overeenstemming tussen de beoordelaars aangeeft.

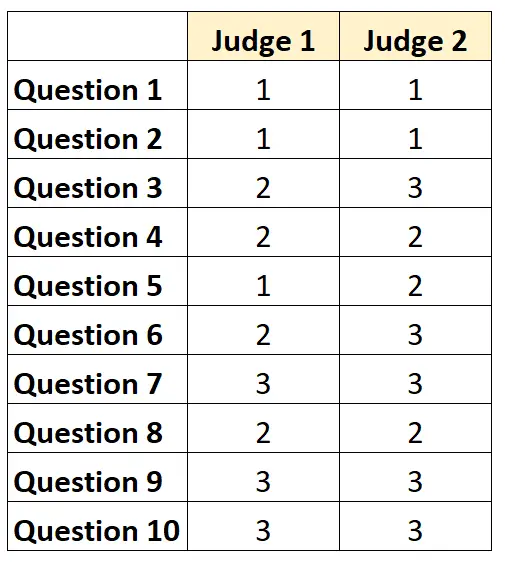

Stel bijvoorbeeld dat twee juryleden wordt gevraagd de moeilijkheidsgraad van 10 items op een test te beoordelen op een schaal van 1 tot 3. De resultaten worden hieronder weergegeven:

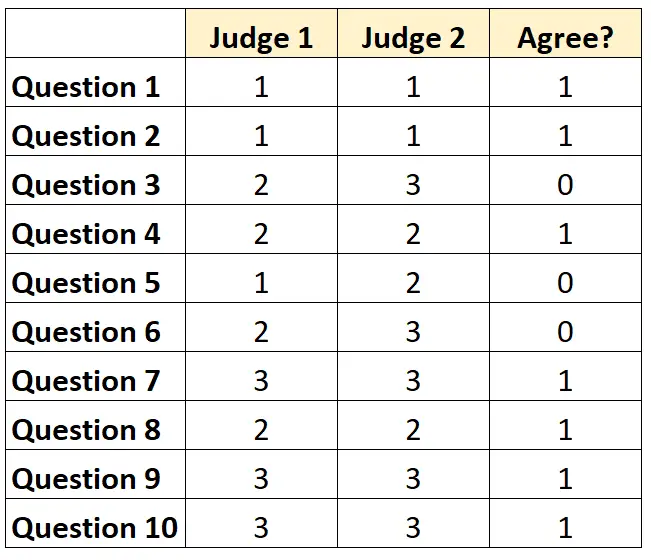

Voor elke vraag kunnen we ‘1’ schrijven als beide juryleden het er mee eens zijn, en ‘0’ als ze het er niet mee eens zijn.

Het percentage vragen waarover de juryleden het eens waren, was 7/10 = 70% .

2. Cohens Kappa

De moeilijkste (en meest rigoureuze) manier om de interbeoordelaarsbetrouwbaarheid te meten is het gebruik van Cohen’s Kappa , die het percentage items berekent waarover beoordelaars het eens zijn, waarbij er rekening mee wordt gehouden dat de beoordelaars het mogelijk alleen over bepaalde elementen eens zijn. Gelukkig.

De Cohen’s Kappa-formule wordt als volgt berekend:

k = (p o – p e ) / (1 – p e )

Goud:

- p o : Relatieve overeenstemming waargenomen tussen de beoordelaars

- p e : Hypothetische waarschijnlijkheid van toevalsovereenkomst

Cohen’s Kappa ligt altijd tussen 0 en 1, waarbij 0 aangeeft dat er geen overeenstemming is tussen de beoordelaars en 1 een perfecte overeenstemming tussen de beoordelaars aangeeft.

Zie deze tutorial voor een stapsgewijs voorbeeld van het berekenen van Cohen’s Kappa.

Hoe interbeoordelaarsbetrouwbaarheid te interpreteren

Hoe hoger de interbeoordelaarsbetrouwbaarheid, des te consistenter beoordelen meerdere juryleden items of vragen op een test met vergelijkbare scores.

Over het algemeen is op de meeste gebieden een interbeoordelaarsovereenstemming van ten minste 75% vereist om een test als betrouwbaar te beschouwen. In specifieke domeinen kan echter een hogere interbeoordelaarsbetrouwbaarheid nodig zijn.

Een interbeoordelaarsbetrouwbaarheid van 75% kan bijvoorbeeld acceptabel zijn voor een test om te bepalen hoe goed een televisieprogramma zal worden ontvangen.

Aan de andere kant kan een interbeoordelaarsbetrouwbaarheid van 95% vereist zijn in medische omgevingen waarin meerdere artsen beoordelen of een bepaalde behandeling al dan niet bij een bepaalde patiënt moet worden toegepast.

Merk op dat in de meeste academische omgevingen en rigoureuze onderzoeksgebieden Cohen’s Kappa wordt gebruikt om de interbeoordelaarsbetrouwbaarheid te berekenen.

Aanvullende bronnen

Een korte introductie tot betrouwbaarheidsanalyse

Wat is betrouwbaarheid in tweeën gedeeld?

Wat is test-hertestbetrouwbaarheid?

Wat is de betrouwbaarheid van parallelle vormen?

Wat is een standaard meetfout?

Cohen’s Kappa-calculator