Meerdere lineaire regressie

In dit artikel wordt uitgelegd wat meervoudige lineaire regressie in de statistiek is. Daarnaast leer je hoe je een meervoudig lineair regressiemodel maakt en hoe dit wordt geïnterpreteerd.

Wat is meervoudige lineaire regressie?

Meervoudige lineaire regressie is een regressiemodel waarin twee of meer onafhankelijke variabelen zijn opgenomen. Met andere woorden, meervoudige lineaire regressie is een statistisch model waarmee verschillende verklarende variabelen lineair kunnen worden gekoppeld aan een responsvariabele.

Daarom wordt een meervoudig lineair regressiemodel gebruikt om een vergelijking te vinden die twee of meer onafhankelijke variabelen relateert aan een afhankelijke variabele. Door de waarde van elke onafhankelijke variabele te vervangen, wordt dus een benadering van de waarde van de afhankelijke variabele verkregen.

De vergelijking y=3+6x 1 -4x 2 +7x 3 is bijvoorbeeld een meervoudig lineair regressiemodel omdat het wiskundig drie onafhankelijke variabelen (x 1 , x 2 , x 3 ) relateert aan één afhankelijke variabele (y) lineair waardepad .

Meerdere lineaire regressieformule

De vergelijking voor een meervoudig lineair regressiemodel is y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Goud:

-

is de afhankelijke variabele.

-

is de onafhankelijke variabele i.

-

is de constante van de meervoudige lineaire regressievergelijking.

-

is de regressiecoëfficiënt die aan de variabele is gekoppeld

.

-

Dit is de fout of het residu, dat wil zeggen het verschil tussen de waargenomen waarde en de door het model geschatte waarde.

-

is het totale aantal variabelen in het model.

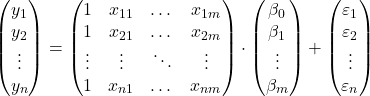

Dus als we een monster hebben met een totaal van

![]()

observaties kunnen we het meervoudige lineaire regressiemodel in matrixvorm voorstellen:

De bovenstaande array-expressie kan worden herschreven door aan elke array een letter toe te wijzen:

![]()

Door het kleinste kwadratencriterium toe te passen, is het dus mogelijk om tot de formule te komen voor het schatten van de coëfficiënten van een meervoudig lineair regressiemodel :

![]()

De toepassing van deze formule is echter zeer bewerkelijk en tijdrovend, dus in de praktijk wordt aanbevolen om computersoftware (zoals Minitab of Excel) te gebruiken waarmee u veel sneller een regressiemodel kunt uitvoeren.

Meerdere lineaire regressie-aannames

In een meervoudig lineair regressiemodel moet aan de volgende voorwaarden worden voldaan om het model geldig te laten zijn:

- Onafhankelijkheid : de residuen moeten onafhankelijk van elkaar zijn. Een gebruikelijke manier om de onafhankelijkheid van het model te garanderen, is door willekeur aan het steekproefproces toe te voegen.

- Homoscedasticiteit : Er moet homogeniteit zijn in de varianties van de residuen, dat wil zeggen dat de variabiliteit van de residuen constant moet zijn.

- Niet-multicollineariteit : de verklarende variabelen die in het model zijn opgenomen, kunnen niet aan elkaar worden gekoppeld, of hun relatie moet op zijn minst zeer zwak zijn.

- Normaliteit : De residuen moeten normaal verdeeld zijn, of met andere woorden, ze moeten een normale verdeling volgen met een gemiddelde van 0.

- Lineariteit : Er wordt aangenomen dat de relatie tussen de responsvariabele en de verklarende variabelen lineair is.

Een meervoudig lineair regressiemodel interpreteren

Om een meervoudig lineair regressiemodel te interpreteren, moeten we kijken naar de determinatiecoëfficiënt (R kwadraat), die het percentage uitdrukt dat door het regressiemodel wordt verklaard. Dus hoe hoger de determinatiecoëfficiënt, hoe meer het model zal worden aangepast aan de bestudeerde gegevenssteekproef.

De goede pasvorm van een statistisch model kan echter misleidend zijn, vooral bij meervoudige lineaire regressiemodellen. Omdat bij het toevoegen van een variabele aan het model de determinatiecoëfficiënt toeneemt, zelfs als de variabele niet significant is. Het is echter noodzakelijk om de determinatiecoëfficiënt te maximaliseren door te proberen het aantal variabelen te minimaliseren, aangezien het model minder gecompliceerd en gemakkelijker te interpreteren is.

Om dit probleem op te lossen, is het noodzakelijk om de aangepaste determinatiecoëfficiënt (aangepast R-kwadraat) te berekenen. Dit is een statistische coëfficiënt die de kwaliteit van de pasvorm van een regressiemodel meet, waarbij elke variabele die aan het model wordt toegevoegd wordt bestraft, in tegenstelling tot de niet-aangepaste coëfficiënt. van vastberadenheid. hierbij wordt geen rekening gehouden met het aantal variabelen in het model.

De aangepaste determinatiecoëfficiënt stelt ons dus in staat de goedheid van de pasvorm van twee modellen met een verschillend aantal variabelen te vergelijken. In principe zou men het model moeten kiezen dat een hogere aangepaste determinatiecoëfficiënt heeft, maar als de twee modellen zeer vergelijkbare waarden hebben, is het beter om het model met minder variabelen te selecteren, omdat dit gemakkelijker te interpreteren is.

Regressiecoëfficiënten geven daarentegen de relatie aan tussen de verklarende variabele en de responsvariabele. Als de regressiecoëfficiënt positief is, zal de responsvariabele toenemen naarmate de verklarende variabele toeneemt. terwijl als de regressiecoëfficiënt negatief is, de responsvariabele zal afnemen wanneer de verklarende variabele toeneemt.

Om aan de voorgaande voorwaarde te voldoen, moeten de andere variabelen logischerwijs constant blijven. Daarom is het belangrijk dat er geen multicollineariteit bestaat tussen de verschillende verklarende variabelen van het model. Hoe de multicollineariteit van een model wordt bestudeerd, kunt u zien door het bijbehorende artikel op onze website te zoeken.

Meervoudige en eenvoudige lineaire regressie

Ten slotte zullen we zien wat de verschillen zijn tussen een eenvoudig lineair regressiemodel en een meervoudig lineair regressiemodel, aangezien het twee regressiemodellen zijn die veel worden gebruikt in de statistiek.

Eenvoudige lineaire regressie is een regressiemodel dat wordt gebruikt om een onafhankelijke variabele in verband te brengen. De vergelijking van een eenvoudig lineair regressiemodel is dus als volgt:

![]()

Daarom ligt het verschil tussen meervoudige lineaire regressie en eenvoudige lineaire regressie in het aantal verklarende variabelen. Een meervoudig lineair regressiemodel heeft twee of meer verklarende variabelen, terwijl een eenvoudig lineair regressiemodel slechts één verklarende variabele heeft.

![]()

Concluderend is meervoudige lineaire regressie een uitbreiding van eenvoudige lineaire regressie, omdat eenvoudigweg meer verklarende variabelen en hun respectieve regressiecoëfficiënten worden toegevoegd. De regressiecoëfficiënten worden echter anders berekend. Klik hier om te zien hoe dit gebeurt: