Hoe twee roc-curven te vergelijken (met voorbeeld)

Eén manier om de prestaties van classificatiemodellen in machine learning te visualiseren is door een ROC-curve te creëren, wat staat voor ‘receiver operating karakteristieke’ curve.

Dit type curve geeft de gevoeligheid en specificiteit van een classificatiemodel weer:

- Gevoeligheid: waarschijnlijkheid dat het model een positief resultaat voorspelt voor een waarneming terwijl het resultaat daadwerkelijk positief is.

- Specificiteit: waarschijnlijkheid dat het model een negatief resultaat voorspelt voor een waarneming terwijl het resultaat feitelijk negatief is.

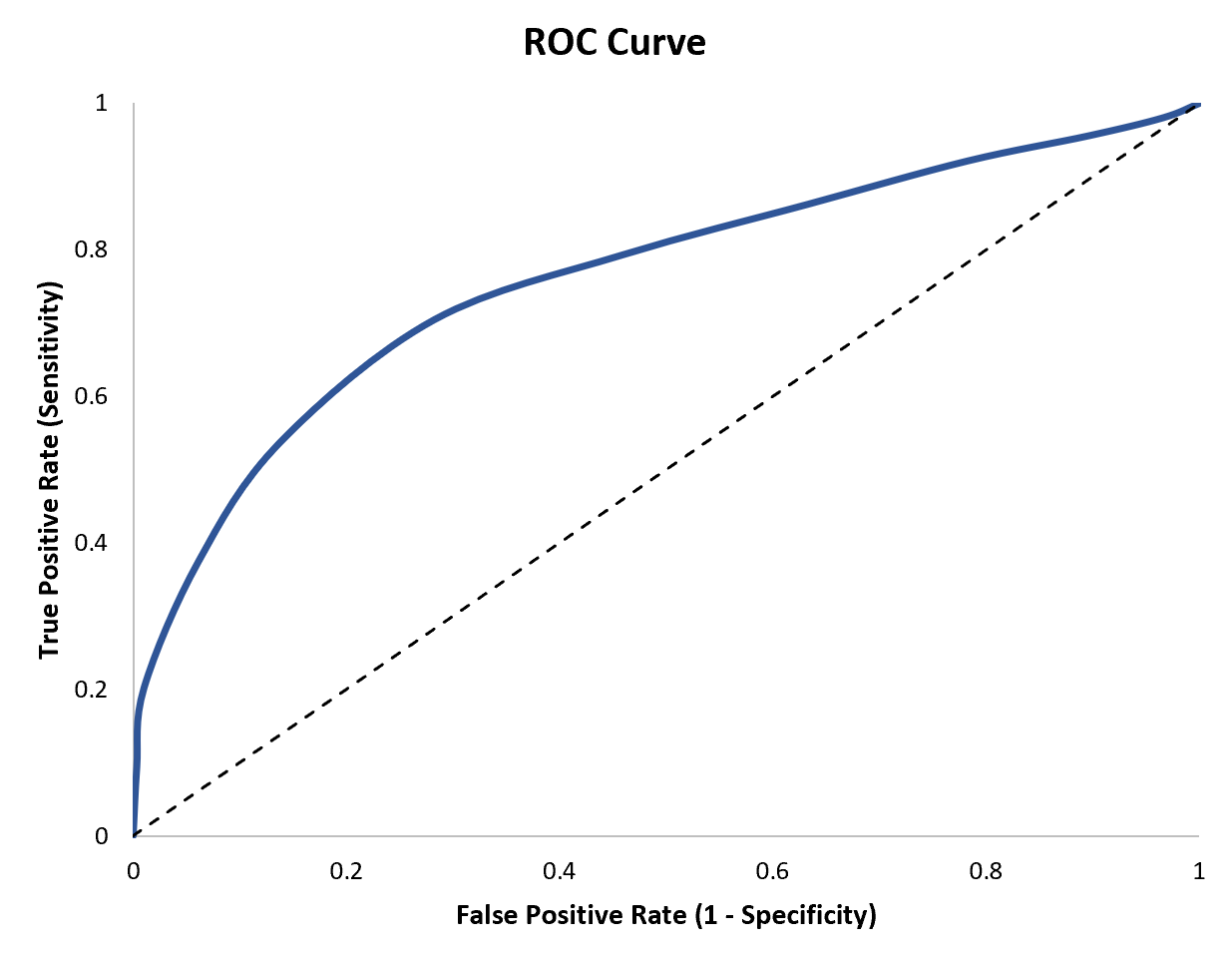

De x-as van een ROC-curve vertegenwoordigt (1-specificiteit) en de y-as vertegenwoordigt gevoeligheid :

Hoe dichter de ROC-curve bij de linkerbovenhoek van de grafiek past, hoe beter het model de gegevens in categorieën kan indelen.

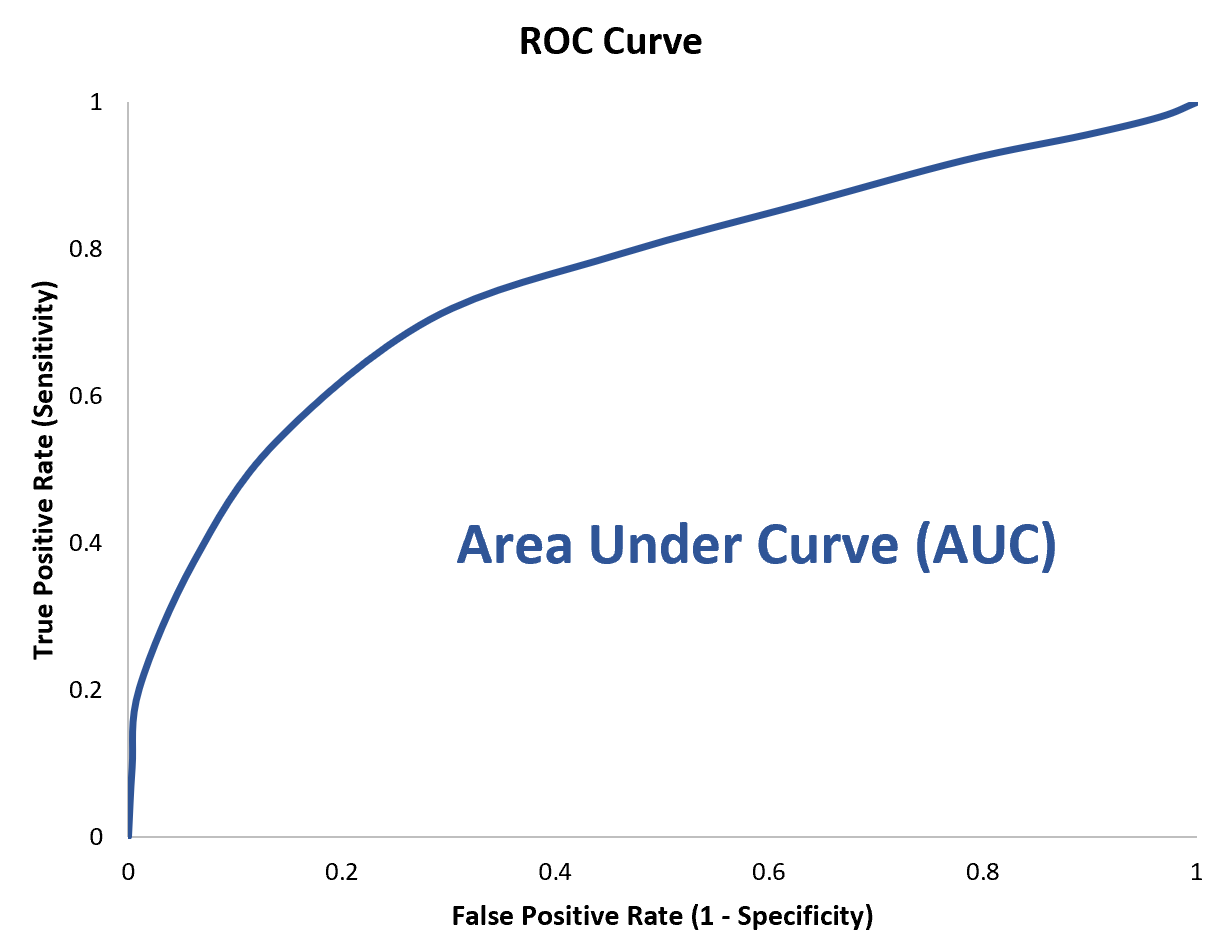

Om dit te kwantificeren, kunnen we de AUC (oppervlakte onder de curve) berekenen, die ons vertelt hoeveel van de grafiek zich onder de curve bevindt.

Hoe dichter de AUC bij 1 ligt, hoe beter het model.

Bij het vergelijken van twee ROC-curven om te bepalen welk classificatiemodel beter is, kijken we vaak naar welke ROC-curve dichter bij de linkerbovenhoek van de grafiek „knuffelt“ en daarom een hogere AUC-waarde heeft.

Voorbeeld: Hoe twee ROC-curven te vergelijken

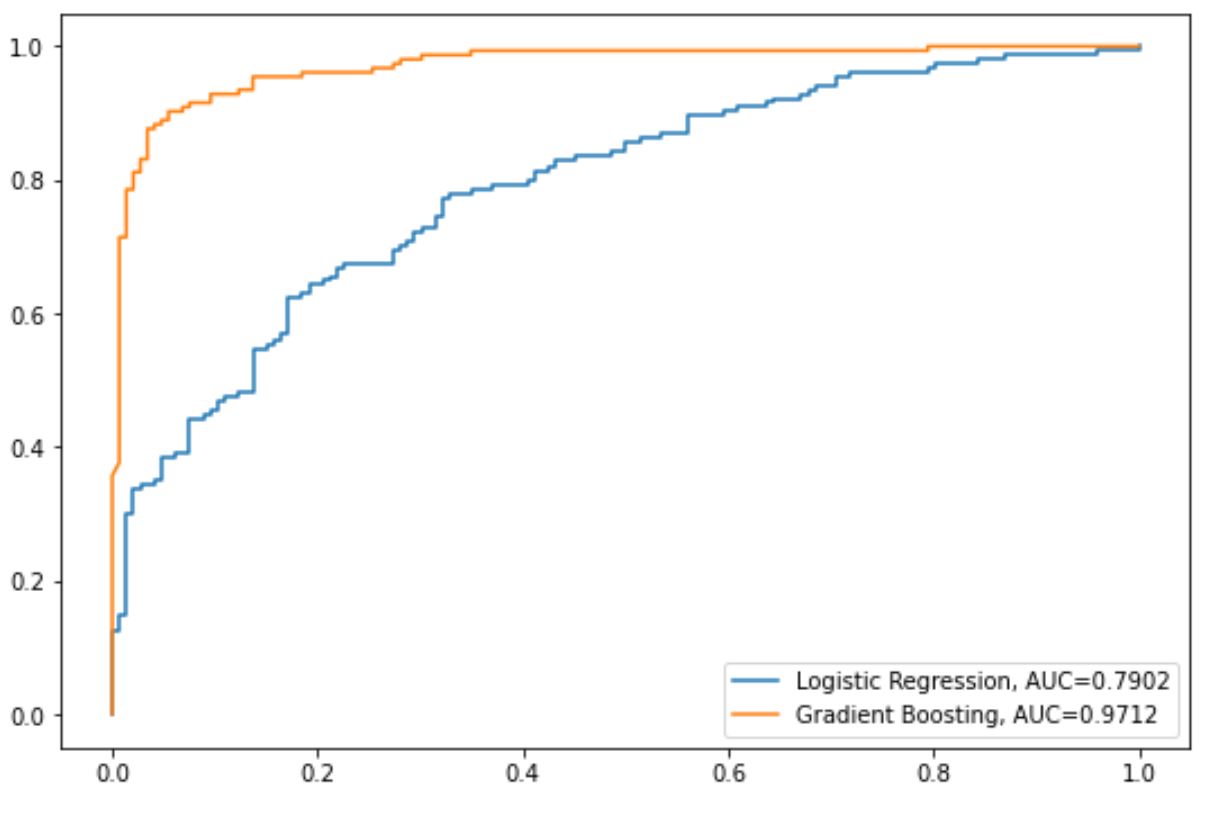

Stel dat we een logistisch regressiemodel en een gradiënt-verbeterd model passen in een dataset om de uitkomst van een responsvariabele te voorspellen.

Stel dat we vervolgens ROC-curven maken om de prestaties van elk model te visualiseren:

De blauwe lijn toont de ROC-curve voor het logistische regressiemodel en de oranje lijn toont de ROC-curve voor het gradiëntversterkte model.

Uit onze grafiek kunnen we voor elk model de volgende AUC-waarden zien:

- AUC van logistisch regressiemodel: 0,7902

- AUC van gradiëntversterkt model: 0,9712

Omdat het gradiënt-verbeterde model een hogere AUC-waarde heeft, zouden we kunnen zeggen dat het de uitkomst van de responsvariabele beter voorspelt.

Opmerking : in dit voorbeeld hebben we slechts twee ROC-curven vergeleken, maar het is mogelijk om verschillende classificatiemodellen in een dataset te passen en nog meer ROC-curven te vergelijken om te bepalen welk model het beste kan worden gebruikt.

Aanvullende bronnen

De volgende tutorials bieden aanvullende informatie over classificatiemodellen en ROC-curven:

Inleiding tot logistieke regressie

Hoe een ROC-curve te interpreteren

Wat wordt beschouwd als een goede AUC-score?