Jaka jest wiarygodność między oceniającymi? (definicja – przykład)

W statystyce wiarygodność między oceniającymi jest sposobem pomiaru poziomu zgodności między wieloma oceniającymi lub sędziami.

Służy do oceny wiarygodności odpowiedzi uzyskanych w ramach różnych pozycji testu. Jeśli test ma niższą wiarygodność między oceniającymi, może to wskazywać, że elementy testu są mylące, niejasne lub nawet nieprzydatne.

Istnieją dwa popularne sposoby pomiaru wiarygodności między oceniającymi:

1. Procent zgodności

Prostym sposobem pomiaru wiarygodności między oceniającymi jest obliczenie odsetka elementów, co do których sędziowie się zgadzają.

Nazywa się to zgodnością procentową , która zawsze mieści się w przedziale od 0 do 1, gdzie 0 oznacza brak zgodności między oceniającymi, a 1 oznacza doskonałą zgodność między oceniającymi.

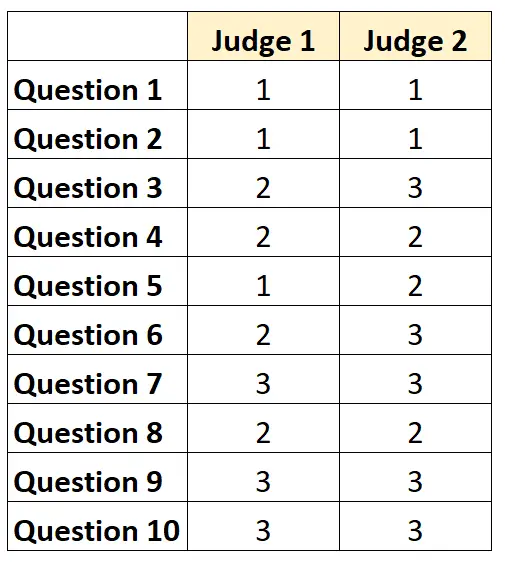

Załóżmy na przykład, że dwóch sędziów zostało poproszonych o ocenę trudności 10 elementów testu w skali od 1 do 3. Wyniki przedstawiono poniżej:

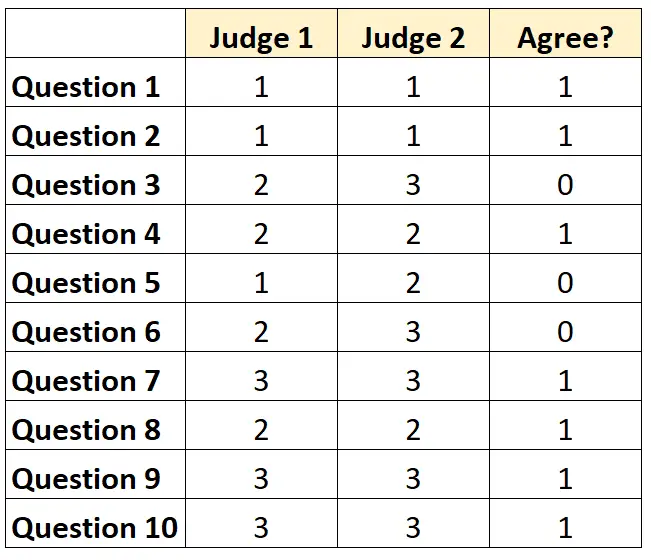

Do każdego pytania możemy wpisać „1”, jeśli obaj sędziowie się zgodzą, lub „0”, jeśli się nie zgodzą.

Odsetek pytań, co do których sędziowie byli zgodni, wyniósł 7/10 = 70% .

2. Kappa Cohena

Najtrudniejszym (i najbardziej rygorystycznym) sposobem pomiaru wiarygodności między oceniającymi jest użycie współczynnika Kappa Cohena , który oblicza procent pozycji, co do których osoby oceniające się zgadzają, biorąc pod uwagę, że oceniający mogą zgodzić się tylko co do niektórych elementów. Na szczęście.

Wzór kappa Cohena oblicza się w następujący sposób:

k = (p o – p mi ) / (1 – p mi )

Złoto:

- p o : Względna zgodność zaobserwowana wśród oceniających

- p e : Hipotetyczne prawdopodobieństwo przypadkowej zgodności

Kappa Cohena zawsze mieści się w przedziale od 0 do 1, gdzie 0 oznacza brak zgodności między oceniającymi, a 1 oznacza doskonałą zgodność między oceniającymi.

Aby zapoznać się z przykładem krok po kroku obliczania Kappa Cohena, zobacz ten samouczek .

Jak interpretować wiarygodność między oceniającymi

Im wyższa wiarygodność między oceniającymi, tym bardziej konsekwentnie wielu sędziów ocenia pozycje lub pytania w teście z podobnymi wynikami.

Ogólnie rzecz biorąc, w większości obszarów wymagana jest zgoda między oceniającymi na poziomie co najmniej 75%, aby test można było uznać za wiarygodny. Jednakże w określonych domenach może być wymagana większa wiarygodność między podmiotami oceniającymi.

Na przykład w przypadku testu sprawdzającego, jak dobrze program telewizyjny będzie odbierany, akceptowalna może być wiarygodność między oceniającymi na poziomie 75%.

Z drugiej strony w placówkach medycznych, w których wielu lekarzy ocenia, czy u danego pacjenta należy zastosować określone leczenie, może być wymagana niezawodność na poziomie 95%.

Należy pamiętać, że w większości środowisk akademickich i rygorystycznych obszarów badawczych Kappa Cohena jest używana do obliczania wiarygodności między oceniającymi.

Dodatkowe zasoby

Szybkie wprowadzenie do analizy niezawodności

Czym jest niezawodność podzielona na dwie części?

Jaka jest niezawodność testu-retestu?

Jaka jest niezawodność form równoległych?

Co to jest standardowy błąd pomiaru?

Kalkulator Kappa Cohena