Analiza regresji

W tym artykule wyjaśniono, czym jest analiza regresji i do czego służy w statystyce. Dodatkowo będziesz mógł zobaczyć, jakie są różne typy analizy regresji.

Co to jest analiza regresji?

W statystyce analiza regresji jest procesem, w którym bada się związek między dwiema lub większą liczbą zmiennych. Mówiąc dokładniej, analiza regresji polega na obliczeniu równania, które matematycznie wiąże zmienne w badaniu.

Model zbudowany w analizie regresji nazywany jest modelem regresji, natomiast równanie wiążące badane zmienne nazywa się równaniem regresji.

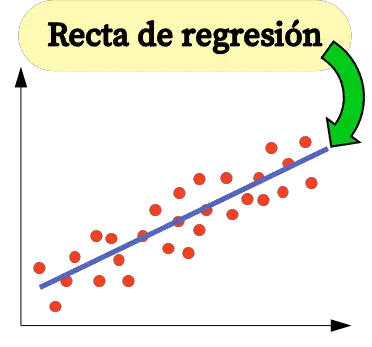

Na przykład, jeśli chcesz zbadać związek między inflacją danego kraju a jego PKB, możesz przeprowadzić analizę regresji, aby przeanalizować związek między tymi dwiema zmiennymi. W tym przypadku równanie uzyskane z analizy regresji byłoby linią regresji.

Zatem analiza regresji polega na zebraniu próbki danych i na ich podstawie obliczone zostaje równanie, które pozwala matematycznie powiązać badane zmienne.

W analizach regresji ważne jest rozróżnienie dwóch typów zmiennych, które można uwzględnić w modelu regresji:

- Zmienna zależna (lub zmienna odpowiedzi) : jest to czynnik, który chcemy przeanalizować, dlatego zostanie zbudowany model regresji, aby zobaczyć, jak wartość tej zmiennej zmienia się w zależności od wartości innych zmiennych.

- Zmienna niezależna (lub zmienna objaśniająca) : jest to czynnik, który według nas może mieć wpływ na zmienną, którą chcemy analizować. Oznacza to, że wartość zmiennej niezależnej wpływa na wartość zmiennej zależnej.

Rodzaje analizy regresji

Zasadniczo istnieją trzy typy analizy regresji :

- Prosta analiza regresji liniowej : Model regresji ma zmienną niezależną i zmienną zależną i są one powiązane liniowo.

- Analiza wielokrotnej regresji liniowej : dwie lub więcej zmiennych niezależnych jest liniowo powiązanych ze zmienną zależną.

- Analiza regresji nieliniowej : Związek między zmienną niezależną a zmienną zależną modeluje się za pomocą funkcji nieliniowej.

Prosta analiza regresji liniowej

Prostą regresję liniową stosuje się do powiązania zmiennej niezależnej z obiema zmiennymi za pomocą równania liniowego.

Równanie prostego modelu regresji liniowej jest linią prostą, dlatego składa się z dwóch współczynników: stałej równania (β 0 ) i współczynnika korelacji pomiędzy obiema zmiennymi (β 1 ). Dlatego równanie prostego modelu regresji liniowej ma postać y=β 0 + β 1 x.

![]()

Wzory na obliczanie współczynników prostej regresji liniowej są następujące:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

Złoto:

-

jest stałą linii regresji.

-

jest nachyleniem linii regresji.

-

jest wartością zmiennej niezależnej X danych i.

-

jest wartością zmiennej zależnej Y danych i.

-

jest średnią wartości zmiennej niezależnej

-

jest średnią wartości zmiennej zależnej Y.

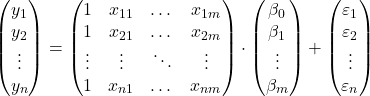

Analiza wielokrotnej regresji liniowej

W modelu regresji liniowej wielokrotnej uwzględnione są co najmniej dwie zmienne niezależne. Innymi słowy, wielokrotna regresja liniowa umożliwia liniowe powiązanie kilku zmiennych objaśniających ze zmienną odpowiedzi. Dlatego równanie modelu regresji liniowej wielokrotnej wygląda następująco:

![]()

Złoto:

-

jest zmienną zależną.

-

jest zmienną niezależną i.

-

jest stałą równania regresji liniowej.

-

jest współczynnikiem regresji powiązanym ze zmienną

.

-

jest błędem lub resztą, to znaczy różnicą między wartością obserwowaną a wartością oszacowaną przez model.

-

jest całkowitą liczbą zmiennych w modelu.

Jeśli więc mamy próbkę o łącznej wartości

![]()

obserwacji możemy przedstawić model wielokrotnej regresji liniowej w postaci macierzowej:

Powyższe wyrażenie macierzowe można przepisać, przypisując literę do każdej macierzy:

![]()

Zatem, stosując kryterium najmniejszych kwadratów, możemy otrzymać wzór na oszacowanie współczynników modelu regresji liniowej wielokrotnej :

![]()

Stosowanie tej formuły jest jednak bardzo pracochłonne i czasochłonne, dlatego w praktyce zaleca się stosowanie programów komputerowych (takich jak Minitab czy Excel), które pozwalają znacznie szybciej stworzyć model regresji wielokrotnej.

Analiza regresji nieliniowej

W statystyce regresja nieliniowa jest rodzajem regresji, w której funkcja nieliniowa jest wykorzystywana jako model równania regresji. Dlatego równanie modelu regresji nieliniowej jest funkcją nieliniową.

Logicznie rzecz biorąc, regresję nieliniową stosuje się do powiązania zmiennej niezależnej ze zmienną zależną, gdy związek między dwiema zmiennymi nie jest liniowy. Jeśli więc podczas tworzenia wykresu przykładowych danych zaobserwujemy, że nie mają one zależności liniowej, to znaczy nie tworzą w przybliżeniu linii prostej, lepiej „użyć modelu regresji nieliniowej”.

Na przykład równanie y=3-5x-8x 2 +x 3 jest modelem regresji nieliniowej, ponieważ matematycznie wiąże zmienną niezależną X ze zmienną zależną Y za pomocą funkcji sześciennej.

Wyróżnia się trzy typy regresji nieliniowej :

- Regresja wielomianowa – regresja nieliniowa, której równanie ma postać wielomianu.

- Regresja logarytmiczna – regresja nieliniowa, w której zmienna niezależna jest logarytmowana.

- Regresja wykładnicza – regresja nieliniowa, w której zmienna niezależna znajduje się w wykładniku równania.

![]()

![]()

![]()

Do czego służy analiza regresji?

Analiza regresji ma zasadniczo dwa zastosowania: analiza regresji służy do wyjaśnienia związku między zmiennymi objaśniającymi a zmienną odpowiedzi i podobnie analiza regresji służy do przewidywania wartości zmiennej zależnej dla nowej obserwacji.

Otrzymując równanie modelu regresji, możemy dowiedzieć się, jaki rodzaj zależności istnieje pomiędzy zmiennymi w modelu. Jeśli współczynnik regresji zmiennej niezależnej jest dodatni, zmienna zależna będzie wzrastać wraz ze wzrostem. natomiast jeśli współczynnik regresji zmiennej niezależnej jest ujemny, zmienna zależna będzie się zmniejszać wraz ze wzrostem.

Z drugiej strony równanie matematyczne uzyskane z analizy regresji pozwala również na przewidywanie wartości. Zatem wprowadzając wartości zmiennych objaśniających do równania modelu regresji, możemy obliczyć wartość zmiennej zależnej dla nowej porcji danych.