Jak obliczyć kappa cohena w r

W statystyce kappa Cohena służy do pomiaru poziomu zgodności między dwoma oceniającymi lub sędziami, którzy klasyfikują każdy element w wzajemnie wykluczające się kategorie.

Wzór kappa Cohena oblicza się w następujący sposób:

k = (p o – p mi ) / (1 – p mi )

Złoto:

- p o : Względna zgodność zaobserwowana wśród oceniających

- p e : Hipotetyczne prawdopodobieństwo przypadkowej zgodności

Zamiast po prostu obliczać odsetek pozycji, co do których osoby oceniające się zgadzają, Kappa Cohena próbuje uwzględnić fakt, że osoby oceniające mogą zgodzić się co do niektórych pozycji przez zwykły przypadek.

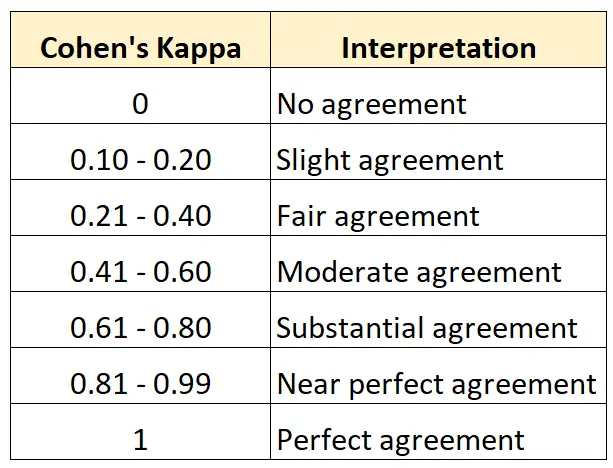

Wartość Kappa Cohena zawsze mieści się w przedziale od 0 do 1, gdzie:

- Wartość 0 oznacza brak porozumienia między dwoma recenzentami

- 1 wskazuje na doskonałą zgodność pomiędzy obydwoma oceniającymi

Poniższa tabela podsumowuje, jak interpretować różne wartości Kappa Cohena:

Najłatwiejszym sposobem obliczenia Kappa Cohena w R jest użycie funkcji cohen.kappa() z pakietu psych .

Poniższy przykład pokazuje, jak w praktyce wykorzystać tę funkcję.

Przykład: Oblicz Kappa Cohena w R

Załóżmy, że dwóch kuratorów w muzeum sztuki zostaje poproszonych o ocenę 15 obrazów, aby sprawdzić, czy są wystarczająco dobre, aby można je było pokazać na nowej wystawie.

Poniższy kod pokazuje, jak używać funkcji cohen.kappa() pakietu psych do obliczenia Kappa Cohena dla dwóch osób oceniających:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

Kolumna szacunkowa wyświetla wartość Kappa Cohena.

Z wyniku widzimy, że Kappa Cohena wynosi 0,34 .

Na podstawie poprzedniej tabeli powiedzielibyśmy, że poziom zgodności obu oceniających był „dość” zadowalający.

Jeśli chcesz obliczyć poziom zgodności między trzema lub większą liczbą oceniających, zaleca się zamiast tego użycie Kappa Fleissa.

Dodatkowe zasoby

Poniższe samouczki zapewniają dodatkowe zasoby na temat Kappa Cohena:

Wprowadzenie do Kappy Cohena

Internetowy kalkulator Kappa Cohena

Jak obliczyć Kappa Cohena w Excelu

Jak obliczyć Kappa Cohena w Pythonie