Wielokrotna regresja liniowa

W tym artykule wyjaśniono, czym jest wielokrotna regresja liniowa w statystyce. Dodatkowo dowiesz się jak stworzyć model regresji liniowej wielokrotnej i jak go interpretować.

Co to jest wielokrotna regresja liniowa?

Wielokrotna regresja liniowa to model regresji, w którym uwzględnione są dwie lub więcej zmiennych niezależnych. Innymi słowy, wielokrotna regresja liniowa jest modelem statystycznym, który umożliwia liniowe powiązanie kilku zmiennych objaśniających ze zmienną odpowiedzi.

Dlatego do znalezienia równania łączącego dwie lub więcej zmiennych niezależnych ze zmienną zależną stosuje się model regresji liniowej wielokrotnej. Zatem zastępując wartość każdej zmiennej niezależnej, uzyskuje się przybliżenie wartości zmiennej zależnej.

Na przykład równanie y=3+6x 1 -4x 2 +7x 3 jest modelem regresji liniowej wielokrotnej, ponieważ matematycznie wiąże trzy niezależne zmienne (x 1 , x 2 , x 3 ) z jedną zmienną zależną (y) liniową ścieżką wartości .

Wzór wielokrotnej regresji liniowej

Równanie modelu regresji liniowej wielokrotnej to y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Złoto:

-

jest zmienną zależną.

-

jest zmienną niezależną i.

-

jest stałą równania regresji liniowej.

-

jest współczynnikiem regresji powiązanym ze zmienną

.

-

Jest to błąd lub reszta, czyli różnica między wartością obserwowaną a wartością oszacowaną przez model.

-

jest całkowitą liczbą zmiennych w modelu.

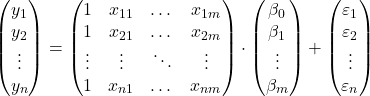

Jeśli więc mamy próbkę o łącznej wartości

![]()

obserwacji możemy zaproponować model wielokrotnej regresji liniowej w postaci macierzowej:

Powyższe wyrażenie tablicowe można przepisać, przypisując literę do każdej tablicy:

![]()

Zatem stosując kryterium najmniejszych kwadratów można otrzymać wzór na oszacowanie współczynników modelu regresji liniowej wielokrotnej :

![]()

Stosowanie tego wzoru jest jednak bardzo pracochłonne i czasochłonne, dlatego w praktyce zaleca się stosowanie programów komputerowych (takich jak Minitab czy Excel), które umożliwiają znacznie szybsze uruchomienie modelu regresji wielokrotnej.

Założenia dotyczące wielokrotnej regresji liniowej

W modelu regresji liniowej wielokrotnej muszą zostać spełnione następujące warunki, aby model był ważny:

- Niezależność : reszty muszą być od siebie niezależne. Powszechnym sposobem zapewnienia niezależności modelu jest dodanie losowości do procesu próbkowania.

- Homoscedastyczność : wariancje reszt muszą być jednorodne, to znaczy zmienność reszt musi być stała.

- Niewielokoliniowość : zmienne objaśniające zawarte w modelu nie mogą być ze sobą powiązane lub przynajmniej ich związek musi być bardzo słaby.

- Normalność : reszty muszą mieć rozkład normalny, czyli innymi słowy muszą mieć rozkład normalny ze średnią 0.

- Liniowość : Zakłada się, że związek między zmienną odpowiedzi a zmiennymi objaśniającymi jest liniowy.

Interpretacja modelu wielokrotnej regresji liniowej

Aby zinterpretować model regresji liniowej wielokrotnej, musimy przyjrzeć się współczynnikowi determinacji (R kwadrat), który wyraża procent wyjaśniony przez model regresji. Zatem im wyższy współczynnik determinacji, tym bardziej model będzie dostosowany do badanej próbki danych.

Jednakże dobroć dopasowania modelu statystycznego może wprowadzać w błąd, szczególnie w przypadku modeli regresji liniowej wielokrotnej. Ponieważ dodając zmienną do modelu, współczynnik determinacji wzrasta, nawet jeśli zmienna jest nieistotna. Należy jednak maksymalizować współczynnik determinacji, starając się minimalizować liczbę zmiennych, ponieważ model jest mniej skomplikowany i łatwiejszy w interpretacji.

Aby rozwiązać ten problem, konieczne jest obliczenie skorygowanego współczynnika determinacji (skorygowanego R do kwadratu), który jest współczynnikiem statystycznym mierzącym jakość dopasowania modelu regresji, karzącym za każdą zmienną dodaną do modelu, w przeciwieństwie do współczynnika nieskorygowanego determinacji. nie uwzględnia to liczby zmiennych w modelu.

Zatem skorygowany współczynnik determinacji pozwala porównać stopień dopasowania dwóch modeli o różnej liczbie zmiennych. W zasadzie należy wybrać model, który ma wyższy skorygowany współczynnik determinacji, jednak jeśli oba modele mają bardzo podobne wartości, lepiej wybrać model z mniejszą liczbą zmiennych, ponieważ jest łatwiejszy w interpretacji.

Natomiast współczynniki regresji wskazują związek pomiędzy zmienną objaśniającą a zmienną odpowiedzi. Jeżeli współczynnik regresji jest dodatni, zmienna odpowiedzi będzie rosła wraz ze wzrostem zmiennej objaśniającej. natomiast jeśli współczynnik regresji jest ujemny, zmienna odpowiedzi będzie się zmniejszać wraz ze wzrostem zmiennej objaśniającej.

Logicznie rzecz biorąc, aby poprzedni warunek został spełniony, pozostałe zmienne muszą pozostać stałe. Dlatego ważne jest, aby nie było współliniowości pomiędzy różnymi zmiennymi objaśniającymi modelu. Możesz zobaczyć, jak badana jest wieloliniowość modelu, wyszukując odpowiedni artykuł na naszej stronie internetowej.

Regresja liniowa wielokrotna i prosta

Na koniec zobaczymy, jakie są różnice między prostym modelem regresji liniowej a modelem wielokrotnej regresji liniowej, ponieważ są to dwa modele regresji szeroko stosowane w statystyce.

Prosta regresja liniowa to model regresji używany do powiązania zmiennej niezależnej. Zatem równanie prostego modelu regresji liniowej wygląda następująco:

![]()

Dlatego różnica między wielokrotną regresją liniową a prostą regresją liniową polega na liczbie zmiennych objaśniających. Model wielokrotnej regresji liniowej ma dwie lub więcej zmiennych objaśniających, podczas gdy prosty model regresji liniowej ma tylko jedną zmienną objaśniającą.

![]()

Podsumowując, wielokrotna regresja liniowa jest rozszerzeniem prostej regresji liniowej, ponieważ po prostu dodaje się więcej zmiennych objaśniających i odpowiadających im współczynników regresji. Jednak współczynniki regresji są obliczane inaczej, aby zobaczyć, jak to się robi, kliknij tutaj: