Como calcular o kappa de cohen em r

Nas estatísticas, o Kappa de Cohen é usado para medir o nível de concordância entre dois avaliadores ou juízes que classificam cada item em categorias mutuamente exclusivas.

A fórmula kappa de Cohen é calculada da seguinte forma:

k = (p o – p e ) / (1 – p e )

Ouro:

- p o : Concordância relativa observada entre os avaliadores

- p e : Probabilidade hipotética de concordância casual

Em vez de simplesmente calcular a percentagem de itens com os quais os avaliadores concordam, o Kappa de Cohen tenta explicar o facto de os avaliadores poderem concordar com alguns itens por mero acaso.

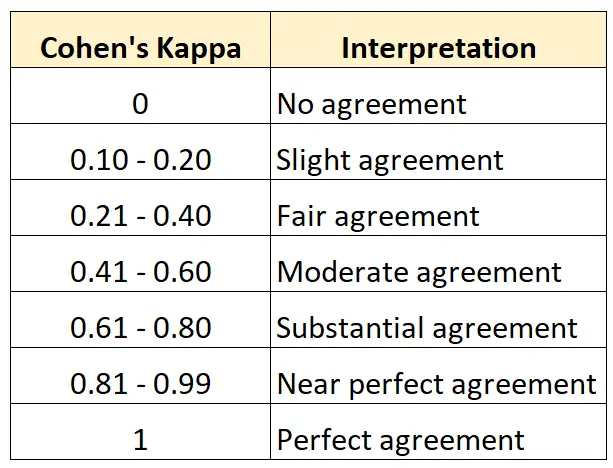

O valor do Kappa de Cohen está sempre entre 0 e 1 onde:

- 0 indica nenhum acordo entre os dois revisores

- 1 indica concordância perfeita entre os dois avaliadores

A tabela a seguir resume como interpretar os diferentes valores do Kappa de Cohen:

A maneira mais fácil de calcular o Kappa de Cohen em R é usar a função cohen.kappa() do pacote psych .

O exemplo a seguir mostra como usar esta função na prática.

Exemplo: Calcule o Kappa de Cohen em R

Suponha que dois curadores de um museu de arte sejam solicitados a avaliar 15 pinturas para ver se são boas o suficiente para serem exibidas em uma nova exposição.

O código a seguir mostra como usar a função cohen.kappa() do pacote psych para calcular o Kappa de Cohen para os dois avaliadores:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

A coluna de estimativa exibe o valor Kappa de Cohen.

A partir do resultado, podemos ver que o Kappa de Cohen é 0,34 .

Com base na tabela anterior, diríamos que os dois avaliadores tiveram apenas um nível de concordância “razoável”.

Se desejar calcular o nível de concordância entre três ou mais avaliadores, recomenda-se utilizar o Kappa de Fleiss.

Recursos adicionais

Os tutoriais a seguir fornecem recursos adicionais sobre o Kappa de Cohen:

Introdução ao Kappa de Cohen

Calculadora Kappa de Cohen Online

Como calcular o Kappa de Cohen no Excel

Como calcular o Kappa de Cohen em Python