Regressão linear

Este artigo explica o que é regressão linear e para que ela é usada nas estatísticas. Além disso, você poderá ver como são calculados os dois tipos de regressão linear: regressão linear simples e regressão linear múltipla.

O que é regressão linear?

A regressão linear é um modelo estatístico que relaciona uma ou mais variáveis independentes a uma variável dependente. Simplificando, a regressão linear é uma técnica usada para encontrar uma equação que aproxima a relação entre uma ou mais variáveis explicativas e uma variável de resposta.

Por exemplo, a equação y=2+5x 1 -3x 2 +8x 3 é um modelo de regressão linear porque relaciona matematicamente três variáveis independentes (x 1 , x 2 , x 3 ) com uma variável dependente (y) e, além disso, a relação entre as variáveis é linear.

Tipos de regressão linear

Existem dois tipos de regressão linear :

- Regressão linear simples : Uma única variável independente está ligada a uma variável dependente. A equação para este tipo de modelo de regressão linear tem, portanto, a forma y=β 0 +β 1 x 1 .

- Regressão linear múltipla : O modelo de regressão possui diversas variáveis explicativas e uma variável resposta. Portanto, a equação para este tipo de modelo de regressão linear tem a forma y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m .

regressão linear simples

A regressão linear simples é usada para relacionar uma variável independente a ambas as variáveis.

A equação de um modelo de regressão linear simples é uma reta, portanto é composta por dois coeficientes: a constante da equação (β 0 ) e o coeficiente de correlação entre as duas variáveis (β 1 ). Portanto, a equação para um modelo de regressão linear simples é y=β 0 +β 1 x.

![]()

As fórmulas para calcular os coeficientes de regressão linear simples são as seguintes:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

Ouro:

-

é a constante da linha de regressão.

-

é a inclinação da linha de regressão.

-

é o valor da variável independente X dos dados i.

-

é o valor da variável dependente Y dos dados i.

-

é a média dos valores da variável independente

-

é a média dos valores da variável dependente Y.

Regressão linear múltipla

Num modelo de regressão linear múltipla , pelo menos duas variáveis independentes são incluídas. Em outras palavras, a regressão linear múltipla permite que diversas variáveis explicativas sejam ligadas linearmente a uma variável resposta.

A equação para um modelo de regressão linear múltipla é y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Ouro:

-

é a variável dependente.

-

é a variável independente eu.

-

é a constante da equação de regressão linear múltipla.

-

é o coeficiente de regressão associado à variável

.

-

é o erro ou resíduo, ou seja, a diferença entre o valor observado e o valor estimado pelo modelo.

-

é o número total de variáveis no modelo.

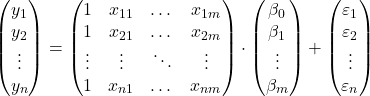

Então, se tivermos uma amostra com um total de

![]()

observações, podemos colocar o modelo de regressão linear múltipla em forma de matriz:

A expressão matricial acima pode ser reescrita atribuindo uma letra a cada matriz:

![]()

Assim, aplicando o critério dos mínimos quadrados, podemos chegar à fórmula para estimar os coeficientes de um modelo de regressão linear múltipla :

![]()

No entanto, a aplicação desta fórmula é muito trabalhosa e demorada, razão pela qual na prática se recomenda a utilização de software informático (como Minitab ou Excel) que permite criar um modelo de regressão múltipla com muito mais rapidez.

Suposições de regressão linear

Num modelo de regressão linear, as seguintes condições devem ser atendidas para que o modelo seja válido:

- Independência : Os resíduos devem ser independentes entre si. Uma maneira comum de garantir a independência do modelo é adicionar aleatoriedade ao processo de amostragem.

- Homocedasticidade : Deve haver homogeneidade nas variâncias dos resíduos, ou seja, a variabilidade dos resíduos deve ser constante.

- Não multicolinearidade : as variáveis explicativas incluídas no modelo não podem ser vinculadas entre si ou, pelo menos, sua relação deve ser muito fraca.

- Normalidade : Os resíduos devem ter distribuição normal, ou seja, devem seguir uma distribuição normal com média 0.

- Linearidade : assume-se que a relação entre a variável resposta e as variáveis explicativas é linear.

Para que é usada a regressão linear?

A regressão linear tem basicamente dois usos: a regressão linear é usada para explicar a relação entre as variáveis explicativas e a variável de resposta e da mesma forma, a regressão linear é usada para prever o valor da variável dependente para uma nova observação.

Ao obter a equação do modelo de regressão linear, podemos saber que tipo de relação existe entre as variáveis do modelo. Se o coeficiente de regressão de uma variável independente for positivo, a variável dependente aumentará à medida que aumenta. ao passo que se o coeficiente de regressão de uma variável independente for negativo, a variável dependente diminuirá à medida que aumenta.

Por outro lado, a equação calculada em regressão linear também permite fazer previsões de valores. Assim, ao introduzir os valores das variáveis explicativas na equação do modelo, podemos calcular o valor da variável dependente para um novo dado.