Değerlendiriciler arası güvenilirlik nedir? (tanım & #038; örnek)

İstatistikte değerlendiriciler arası güvenilirlik , birden fazla değerlendirici veya yargıç arasındaki anlaşmanın düzeyini ölçmenin bir yoludur.

Bir testteki farklı maddeler tarafından üretilen yanıtların güvenilirliğini değerlendirmek için kullanılır. Bir testin değerlendiriciler arası güvenilirliği düşükse, bu durum test maddelerinin kafa karıştırıcı, belirsiz ve hatta yararsız olduğunu gösterebilir.

Değerlendiriciler arası güvenilirliği ölçmenin iki yaygın yolu vardır:

1. Anlaşma yüzdesi

Değerlendiriciler arası güvenilirliği ölçmenin basit yolu, yargıçların üzerinde anlaştığı maddelerin yüzdesini hesaplamaktır.

Buna yüzde anlaşma adı verilir ve bu değer her zaman 0 ile 1 arasındadır; 0, değerlendiriciler arasında hiçbir anlaşma olmadığını, 1 ise değerlendiriciler arasında mükemmel anlaşmayı belirtir.

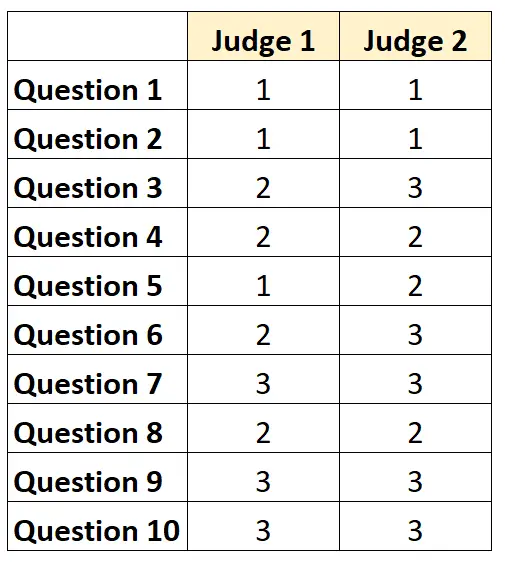

Örneğin, iki yargıcın bir testteki 10 maddenin zorluğunu 1’den 3’e kadar bir ölçekte derecelendirmesinin istendiğini varsayalım. Sonuçlar aşağıda gösterilmektedir:

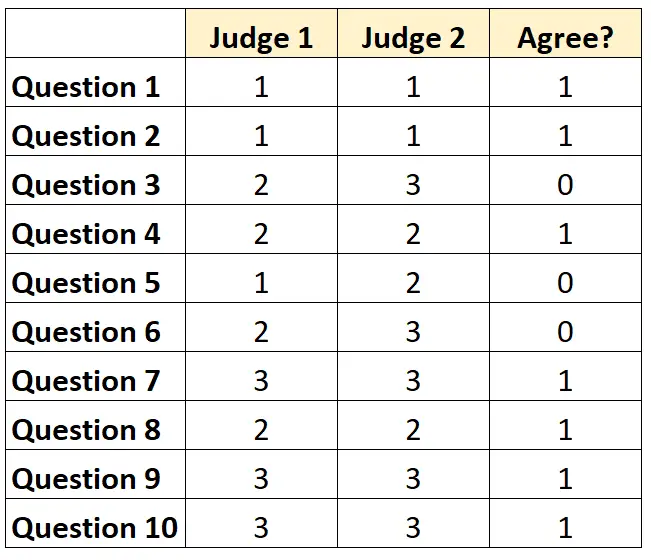

Her soru için her iki yargıç da katılıyorsa “1”, katılmıyorsa “0” yazabiliriz.

Jürinin üzerinde mutabakata vardığı soruların yüzdesi 7/10 = %70 idi.

2. Cohen’in Kappa’sı

Değerlendiriciler arası güvenilirliği ölçmenin en zor (ve en katı) yolu, Değerlendiricilerin yalnızca belirli öğeler üzerinde hemfikir olabileceğini hesaba katarak, değerlendiricilerin üzerinde hemfikir olduğu maddelerin yüzdesini hesaplayan Cohen’in Kappa’sını kullanmaktır. Neyse ki.

Cohen’in kappa formülü şu şekilde hesaplanır:

k = (p o – p e ) / (1 – p e )

Altın:

- p o : Değerlendiriciler arasında gözlemlenen göreceli anlaşma

- p e : Şans anlaşmasının varsayımsal olasılığı

Cohen’in Kappa’sı her zaman 0 ile 1 arasında değişir; 0, değerlendiriciler arasında hiçbir anlaşma olmadığını, 1 ise değerlendiriciler arasında mükemmel anlaşmayı gösterir.

Cohen’in Kappa’sının nasıl hesaplanacağına ilişkin adım adım bir örnek için bu eğitime bakın.

Değerlendiriciler arası güvenilirlik nasıl yorumlanır?

Değerlendiriciler arası güvenilirlik ne kadar yüksek olursa, birden fazla yargıç, benzer puanlara sahip bir testteki öğeleri veya soruları o kadar tutarlı bir şekilde derecelendirir.

Genel olarak, bir testin güvenilir sayılması için çoğu alanda değerlendiriciler arası en az %75’lik bir anlaşma gerekir. Ancak belirli alanlarda değerlendiriciler arası güvenilirliğin daha yüksek olması gerekebilir.

Örneğin, %75’lik değerlendiriciler arası güvenilirlik, bir televizyon programının ne kadar iyi karşılanacağını belirlemeye yönelik bir test için kabul edilebilir.

Öte yandan, birden fazla doktorun belirli bir hastada belirli bir tedavinin kullanılıp kullanılmaması gerektiğine karar verdiği tıbbi ortamlarda değerlendiriciler arası güvenilirliğin %95 olması gerekebilir.

Çoğu akademik ortamda ve titiz araştırma alanlarında, değerlendiriciler arası güvenilirliği hesaplamak için Cohen’in Kappa’sının kullanıldığını unutmayın.

Ek kaynaklar

Güvenilirlik Analizine Hızlı Bir Giriş

Güvenilirlik ikiye bölünmüş nedir?

Test-tekrar test güvenilirliği nedir?

Paralel formların güvenilirliği nedir?

Standart ölçüm hatası nedir?

Cohen’in Kappa Hesaplayıcısı