R'de cohen'in kappa'sı nasıl hesaplanır?

İstatistiklerde Cohen’in Kappa’sı , her bir maddeyi birbirini dışlayan kategorilere sınıflandıran iki değerlendirici veya yargıç arasındaki anlaşmanın düzeyini ölçmek için kullanılır.

Cohen’in kappa formülü şu şekilde hesaplanır:

k = (p o – p e ) / (1 – p e )

Altın:

- p o : Değerlendiriciler arasında gözlemlenen göreceli anlaşma

- p e : Şans anlaşmasının varsayımsal olasılığı

Cohen’in Kappa’sı, yalnızca değerlendiricilerin üzerinde anlaştıkları maddelerin yüzdesini hesaplamak yerine, değerlendiricilerin bazı maddeler üzerinde şans eseri anlaşabilecekleri gerçeğini açıklamaya çalışmaktadır.

Cohen Kappa’nın değeri her zaman 0 ile 1 arasındadır; burada:

- 0, iki gözden geçiren arasında anlaşma olmadığını gösterir

- 1, iki değerlendirici arasındaki mükemmel anlaşmayı gösterir

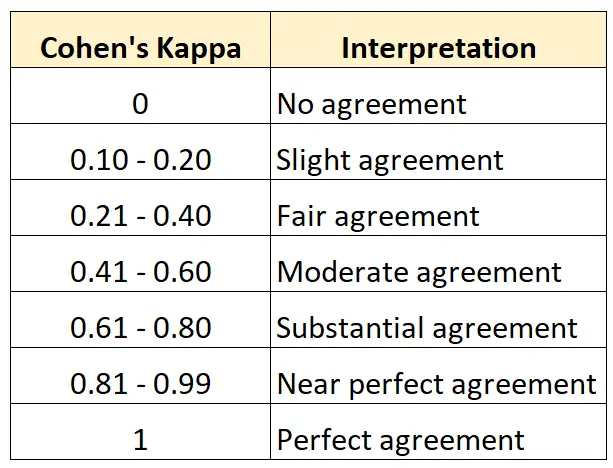

Aşağıdaki tablo Cohen Kappa’nın farklı değerlerinin nasıl yorumlanacağını özetlemektedir:

R’de Cohen’in Kappa’sını hesaplamanın en kolay yolu psych paketindeki cohen.kappa() işlevini kullanmaktır.

Aşağıdaki örnekte bu fonksiyonun pratikte nasıl kullanılacağı gösterilmektedir.

Örnek: R’de Cohen’in Kappa’sını hesaplayın

Bir sanat müzesindeki iki küratörden, yeni bir sergide sergilenecek kadar iyi olup olmadıklarını görmek için 15 tabloyu değerlendirmelerinin istendiğini varsayalım.

Aşağıdaki kod, iki değerlendirici için Cohen’in Kappa’sını hesaplamak amacıyla psych paketinin cohen.kappa() işlevinin nasıl kullanılacağını gösterir:

library (psych)

#define vector of ratings for both raters

miss1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

miss2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

Cohen. kappa (x=cbind(miss1,miss2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

Tahmin sütunu Cohen’in Kappa değerini görüntüler.

Sonuçtan Cohen’in Kappa’sının 0,34 olduğunu görüyoruz.

Önceki tabloya dayanarak, iki değerlendiricinin yalnızca “oldukça” düzeyde bir anlaşmaya sahip olduğunu söyleyebiliriz.

Üç veya daha fazla değerlendirici arasındaki uyum düzeyini hesaplamak istiyorsanız bunun yerine Fleiss’ Kappa’yı kullanmanız önerilir.

Ek kaynaklar

Aşağıdaki eğitimler Cohen’in Kappa’sı hakkında ek kaynaklar sağlar:

Cohen’in Kappa’sına Giriş

Çevrimiçi Cohen’in Kappa Hesaplayıcısı

Cohen’in Kappa’sı Excel’de Nasıl Hesaplanır?

Python’da Cohen’in Kappa’sı Nasıl Hesaplanır?