Sınıf içi korelasyon katsayısı: tanım + örnek

İki veya daha fazla puanlayıcının bulunduğu çalışmalarda puanların güvenilirliğini ölçmek için sınıf içi korelasyon katsayısı (ICC) kullanılır.

Bir ICC’nin değeri 0 ile 1 arasında değişebilir; 0, değerlendiriciler arasında güvenilirliğin olmadığını, 1 ise değerlendiriciler arasında mükemmel güvenilirliği belirtir.

Basitçe söylemek gerekirse, öğelerin (veya konuların) farklı değerlendiriciler tarafından güvenilir bir şekilde derecelendirilip derecelendirilemeyeceğini belirlemek için bir ICC kullanılır.

Aşağıdaki üç faktöre bağlı olarak hesaplanabilecek bir ICC’nin birkaç farklı versiyonu vardır:

- Model: tek yönlü rastgele etkiler, iki yönlü rastgele etkiler veya iki yönlü karışık etkiler

- İlişki türü: tutarlılık veya mutlak anlaşma

- Birim: tek değerlendirici veya değerlendiricilerin ortalaması

İşte üç farklı modelin kısa bir açıklaması:

1. Tek yönlü rastgele etkiler modeli: Bu model, her konunun rastgele seçilen farklı bir değerlendirici grubu tarafından değerlendirildiğini varsaymaktadır. Bu modelde değerlendiriciler rastgele etkilerin kaynağı olarak kabul edilmektedir. Bu model pratikte nadiren kullanılır çünkü her konuyu değerlendirmek için genellikle aynı değerlendirici grubu kullanılır.

2. İki yönlü rastgele etki modeli: Bu model, bir grup k puanlayıcının bir popülasyondan rastgele seçildiğini ve daha sonra konuları derecelendirmek için kullanıldığını varsayar. Bu modeli kullanarak, değerlendiriciler ve denekler rastgele etkilerin kaynakları olarak kabul edilir. Bu model genellikle sonuçlarımızı, çalışmada kullanılanlara benzer puanlayıcılara genellemek istediğimizde kullanılır.

3. İki yönlü karma etki modeli: Bu model aynı zamanda bir grup k puanlayıcının bir popülasyondan rastgele seçildiğini ve daha sonra denekleri derecelendirmek için kullanıldığını varsayar. Ancak bu model, seçtiğimiz değerlendirici grubunun ilgilenilen tek değerlendiriciler olduğunu varsayar; bu da sonuçlarımızı, çalışmada kullanılan değerlendiricilerle benzer özellikleri paylaşabilecek diğer değerlendiricilere genellemek istemediğimiz anlamına gelir.

Ölçmek isteyebileceğimiz iki farklı ilişki türünün kısa bir açıklaması aşağıda verilmiştir:

1. Tutarlılık: Jürilerin derecelendirmeleri arasındaki sistematik farklılıklarla ilgileniyoruz (örneğin, jüri benzer konuları düşük ve yüksek olarak mı derecelendirdi?)

2. Mutlak fikir birliği: Hakemlerin puanları arasındaki mutlak farklarla ilgileniyoruz (örneğin, A hakeminin ve B hakeminin puanları arasındaki mutlak fark nedir?)

İlgimizi çekebilecek iki farklı birimin kısa bir açıklaması:

1. Tek incelemeci: Ölçüm için temel olarak yalnızca tek bir incelemecinin derecelendirmesini kullanmak istiyoruz.

2. Değerlendirici ortalaması: Tüm jüri üyelerinin puanlarının ortalamasını ölçüm için temel olarak kullanmak istiyoruz.

Not: İkili bir sonuca ilişkin her bir maddeyi kaçıran iki değerlendirici arasındaki anlaşmanın düzeyini ölçmek istiyorsanız bunun yerine Cohen’in Kappa’sını kullanmalısınız.

Sınıf içi korelasyon katsayısı nasıl yorumlanır?

Koo ve Li’ye göre sınıf içi korelasyon katsayısının değerinin nasıl yorumlanacağı aşağıda açıklanmıştır:

- 0,50’den az: zayıf güvenilirlik

- 0,5 ile 0,75 arasında: Orta düzeyde güvenilirlik

- 0,75 ile 0,9 arasında: İyi güvenilirlik

- 0,9’dan büyük: Mükemmel güvenilirlik

Aşağıdaki örnek, pratikte sınıf içi korelasyon katsayısının nasıl hesaplanacağını göstermektedir.

Örnek: Sınıf içi korelasyon katsayısının hesaplanması

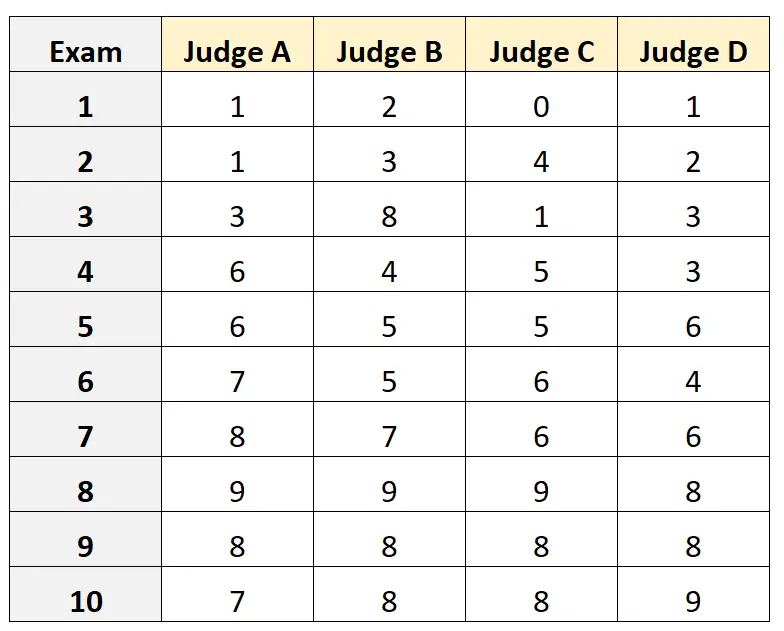

Diyelim ki dört farklı jüriden 10 farklı üniversiteye giriş sınavının kalitesini değerlendirmeleri isteniyor. Sonuçlar aşağıda gösterilmektedir:

Giriş sınavı için dört yargıcın nitelikli yargıçlardan oluşan bir popülasyondan rastgele seçildiğini ve yargıçlar arasındaki mutlak anlaşmayı ölçmek istediğimizi ve ölçümümüzün temeli olarak puanları yalnızca bir değerlendiricinin bakış açısından kullanmak istediğimizi varsayalım.

Değerlendiriciler arasındaki ilişki olarak mutlak anlaşmayı ve ilgi birimi olarak tek birimi kullanarak iki yönlü rastgele etkiler modeline uymak için R’de aşağıdaki kodu kullanabiliriz:

#load the interrater reliability package library (irr) #define data data <- data. frame (A=c(1, 1, 3, 6, 6, 7, 8, 9, 8, 7), B=c(2, 3, 8, 4, 5, 5, 7, 9, 8, 8), C=c(0, 4, 1, 5, 5, 6, 6, 9, 8, 8), D=c(1, 2, 3, 3, 6, 4, 6, 8, 8, 9)) #calculate ICC icc(data, model = " twoway ", type = " agreement ", unit = " single ") Model: twoway Type: agreement Subjects = 10 Failures = 4 ICC(A,1) = 0.782 F-Test, H0: r0 = 0; H1: r0 > 0 F(9.30) = 15.3, p = 5.93e-09 95%-Confidence Interval for ICC Population Values: 0.554 < ICC < 0.931

Sınıf içi korelasyon katsayısı (ICC) 0,782 olarak bulunmuştur.

ICC’yi yorumlamak için temel kurallara dayanarak, 0,782’lik bir ICC’nin, sınavların farklı değerlendiriciler tarafından “iyi” güvenilirlikle puanlanabileceğini gösterdiği sonucuna varabiliriz.

Ek kaynaklar

Aşağıdaki eğitimler, farklı istatistiksel yazılımlarda ICC’nin nasıl hesaplanacağına ilişkin ayrıntılı açıklamalar sağlar:

Excel’de Sınıf İçi Korelasyon Katsayısı Nasıl Hesaplanır?

R’de sınıf içi korelasyon katsayısı nasıl hesaplanır

Python’da Sınıf İçi Korelasyon Katsayısı Nasıl Hesaplanır?