Коефіцієнт регресії

У цій статті пояснюється, що таке коефіцієнти регресії в статистиці. Таким чином, ви дізнаєтесь, як розрахувати коефіцієнт регресії та як інтерпретувати його значення.

Що таке коефіцієнт регресії?

Коефіцієнт регресії – це значення, пов’язане з кожною пояснювальною змінною в регресійній моделі. Тобто, коефіцієнти регресії – це значення, які перемножують пояснювальні змінні в рівнянні регресії, так що кожна пояснювальна змінна відповідає коефіцієнту регресії.

Наприклад, якщо отримане рівняння регресійної моделі дорівнює y=3+2x 1 -7x 2 , коефіцієнти регресії моделі дорівнюють 3, 2 і -7. Зверніть увагу, що константа в рівнянні (3) також вважається коефіцієнтом регресії, навіть якщо вона не множить жодних змінних.

![]()

Таким чином, у моделі регресії існує стільки коефіцієнтів регресії, скільки пояснювальних змінних (або незалежних змінних) плюс один, який відповідає константі в рівнянні моделі.

Крім того, коефіцієнт регресії вказує на зв’язок між незалежною змінною та залежною змінною. Наприклад, якщо коефіцієнт регресії додатний, це означає, що зі збільшенням незалежної змінної буде зростати і залежна змінна. Однак зв’язок між двома змінними не завжди є таким прямим. Нижче ми побачимо, як інтерпретувати коефіцієнт регресії.

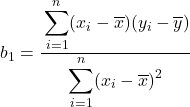

Формула коефіцієнта регресії

Для простої лінійної регресії, рівняння якої:

![]()

Формули для обчислення двох коефіцієнтів регресії моделі такі:

![]()

Ви можете переглянути розв’язану задачу, в якій розраховано коефіцієнти регресії, за посиланням:

Якщо ви хочете обчислити коефіцієнти регресії моделі множинної лінійної регресії, найкраще використовувати комп’ютерне програмне забезпечення, оскільки формули набагато складніші.

Інтерпретація коефіцієнта регресії

Тепер, коли ми знаємо, що таке коефіцієнт регресії в статистиці та як він обчислюється, давайте подивимося, як інтерпретується коефіцієнт регресії.

Інтерпретація коефіцієнта регресії змінної проста: якщо решта пояснювальних змінних залишаються постійними, збільшення пояснювальної змінної призведе до збільшення або зменшення залежної змінної залежно від того, чи є знак її коефіцієнта позитивним чи позитивний. негативні відповідно. .

Таким чином, якщо коефіцієнт регресії пояснювальної змінної позитивний, це означає, що зазначена змінна та залежна змінна мають позитивну кореляцію. З іншого боку, якщо коефіцієнт негативний, це означає, що незалежна змінна та залежна змінна мають негативну кореляцію.

Однак все це вірно, якщо немає взаємодії між пояснювальними змінними, тобто якщо коли одна пояснювальна змінна змінюється, інші змінні залишаються постійними. В іншому випадку зв’язок між пояснювальною змінною та змінною відповіді потребує більш детального аналізу.

Щоб дізнатися більше, ви можете переглянути нашу наступну статтю:

Крім того, при аналізі коефіцієнта регресії також важливо враховувати, чи є відповідна змінна лінійною чи нелінійною. Оскільки якщо змінна є нелінійною, зміна значення змінної по-різному вплине на змінну відповіді. Наприклад, квадратичні змінні перетворюють від’ємні значення в додатні, тому чим більше від’ємна квадратична змінна, тим більша змінна відповіді.

Коефіцієнт регресії та коефіцієнт детермінації

Нарешті, ми побачимо, яка різниця між коефіцієнтом регресії та коефіцієнтом детермінації, оскільки це два дуже важливі коефіцієнти в моделях регресії, і їх значення мають бути зрозумілими.

Коефіцієнт детермінації (R 2 ) є статистичним показником, який вимірює відповідність регресійної моделі. Простіше кажучи, коефіцієнт детермінації показує, наскільки регресійна модель відповідає набору даних.

Отже, різниця між коефіцієнтом регресії та коефіцієнтом детермінації полягає в тому, що коефіцієнт регресії вказує на зв’язок між незалежною змінною та залежною змінною, тоді як коефіцієнт детермінації вказує на відповідність регресійної моделі. .