Регресійний аналіз

У цій статті пояснюється, що таке регресійний аналіз і для чого він використовується в статистиці. Крім того, ви зможете побачити різні типи регресійного аналізу.

Що таке регресійний аналіз?

У статистиці регресійний аналіз — це процес, у якому вивчається зв’язок між двома чи більше змінними. Якщо говорити точніше, то регресійний аналіз передбачає обчислення рівняння, яке математично пов’язує змінні в дослідженні.

Модель, побудована в регресійному аналізі, називається регресійною моделлю, тоді як рівняння, яке пов’язує досліджувані змінні, називається рівнянням регресії.

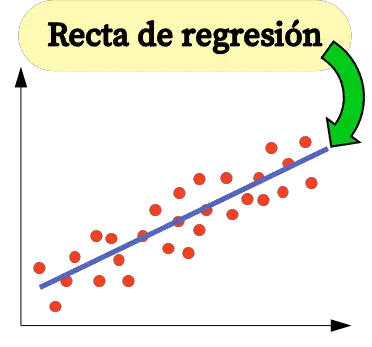

Наприклад, якщо ви хочете вивчити зв’язок між інфляцією в країні та її ВВП, ви можете виконати регресійний аналіз, щоб проаналізувати зв’язок між двома змінними. У цьому випадку рівняння, отримане в результаті регресійного аналізу, буде лінією регресії.

Таким чином, регресійний аналіз полягає у зборі вибірки даних і на основі зібраних даних обчислюється рівняння, яке дозволяє математично пов’язати досліджувані змінні.

У регресійному аналізі важливо розрізняти два типи змінних, які можна включити в регресійну модель:

- Залежна змінна (або змінна відповіді) : це фактор, який ми хочемо проаналізувати, тому буде створено регресійну модель, щоб побачити, як значення цієї змінної змінюється залежно від значення інших змінних.

- Незалежна змінна (або пояснювальна змінна) : це фактор, який, на нашу думку, може вплинути на змінну, яку ми хочемо проаналізувати. Тобто значення незалежної змінної впливає на значення залежної змінної.

Види регресійного аналізу

В основному існує три типи регресійного аналізу :

- Простий лінійний регресійний аналіз : модель регресії має незалежну змінну та залежну змінну, і вони лінійно пов’язані між собою.

- Множинний лінійний регресійний аналіз : дві або більше незалежних змінних лінійно пов’язані із залежною змінною.

- Нелінійний регресійний аналіз : зв’язок між незалежною змінною та залежною змінною моделюється за допомогою нелінійної функції.

Простий лінійний регресійний аналіз

Проста лінійна регресія використовується для зв’язку незалежної змінної з обома змінними за допомогою лінійного рівняння.

Рівняння простої моделі лінійної регресії є прямою лінією, тому воно складається з двох коефіцієнтів: константи рівняння (β 0 ) і коефіцієнта кореляції між двома змінними (β 1 ). Отже, рівняння для простої моделі лінійної регресії має вигляд y=β 0 +β 1 x.

![]()

Формули для розрахунку коефіцієнтів простої лінійної регресії такі:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

золото:

-

є константою лінії регресії.

-

– нахил лінії регресії.

-

є значенням незалежної змінної X даних i.

-

є значенням залежної змінної Y даних i.

-

є середнім значенням незалежної змінної

-

є середнім значенням залежної змінної Y.

Множинний лінійний регресійний аналіз

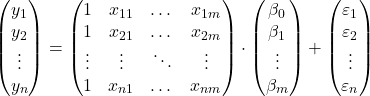

У моделі множинної лінійної регресії включено щонайменше дві незалежні змінні. Іншими словами, множинна лінійна регресія дозволяє лінійно пов’язати кілька пояснювальних змінних зі змінною відповіді. Таким чином, рівняння для моделі множинної лінійної регресії виглядає так:

![]()

золото:

-

є залежною змінною.

-

є незалежною змінною i.

-

є константою рівняння множинної лінійної регресії.

-

це коефіцієнт регресії, пов’язаний зі змінною

.

-

є помилкою або залишком, тобто різницею між спостережуваним значенням і значенням, оціненим за допомогою моделі.

-

загальна кількість змінних у моделі.

Отже, якщо у нас є вибірка із загальною кількістю

![]()

спостережень, ми можемо представити модель множинної лінійної регресії у матричній формі:

Наведений вище матричний вираз можна переписати, присвоївши літеру кожній матриці:

![]()

Таким чином, застосовуючи критерій найменших квадратів, ми можемо отримати формулу для оцінки коефіцієнтів моделі множинної лінійної регресії :

![]()

Однак застосування цієї формули є дуже трудомістким і трудомістким, тому на практиці рекомендується використовувати комп’ютерне програмне забезпечення (наприклад, Minitab або Excel), яке дозволяє набагато швидше створити модель множинної регресії.

Нелінійний регресійний аналіз

У статистиці нелінійна регресія — це тип регресії, у якій нелінійна функція використовується як модель рівняння регресії. Отже, рівняння нелінійної регресійної моделі є нелінійною функцією.

Логічно, що нелінійна регресія використовується для зв’язку незалежної змінної з залежною змінною, коли зв’язок між двома змінними не є лінійним. Отже, якщо під час побудови графіка вибіркових даних ми спостерігаємо, що вони не мають лінійного зв’язку, тобто приблизно не утворюють пряму лінію, краще використовувати нелінійну регресійну модель.

Наприклад, рівняння y=3-5x-8x 2 +x 3 є нелінійною регресійною моделлю, оскільки воно математично пов’язує незалежну змінну X із залежною змінною Y через кубічну функцію.

В основному існує три типи нелінійної регресії :

- Поліноміальна регресія – нелінійна регресія, рівняння якої має форму полінома.

- Логарифмічна регресія – нелінійна регресія, у якій незалежна змінна логарифмізована.

- Експоненціальна регресія – нелінійна регресія, у якій незалежна змінна знаходиться в експоненті рівняння.

![]()

![]()

![]()

Для чого використовується регресійний аналіз?

Регресійний аналіз в основному має два застосування: регресійний аналіз використовується для пояснення зв’язку між пояснювальними змінними та змінною відповіді, і аналогічно регресійний аналіз використовується для прогнозування значення залежної змінної для нового спостереження.

Отримавши рівняння регресійної моделі, ми можемо знати, який тип зв’язку існує між змінними в моделі. Якщо коефіцієнт регресії незалежної змінної додатний, залежна змінна буде зростати, коли вона зростатиме. тоді як, якщо коефіцієнт регресії незалежної змінної негативний, залежна змінна буде зменшуватися, коли вона зростатиме.

З іншого боку, математичне рівняння, отримане в результаті регресійного аналізу, також дозволяє нам робити прогнози вартості. Таким чином, вводячи значення пояснювальних змінних в рівняння регресійної моделі, ми можемо обчислити значення залежної змінної для нової частини даних.