Лінійна регресія

У цій статті пояснюється, що таке лінійна регресія та для чого вона використовується в статистиці. Крім того, ви зможете побачити, як обчислюються два типи лінійної регресії: проста лінійна регресія та множинна лінійна регресія.

Що таке лінійна регресія?

Лінійна регресія — це статистична модель, яка пов’язує одну або кілька незалежних змінних із залежною змінною. Простіше кажучи, лінійна регресія – це техніка, яка використовується для знаходження рівняння, яке наближено відображає зв’язок між однією або декількома пояснювальними змінними та змінною відповіді.

Наприклад, рівняння y=2+5x 1 -3x 2 +8x 3 є моделлю лінійної регресії, оскільки воно математично пов’язує три незалежні змінні (x 1 , x 2 , x 3 ) із залежною змінною (y) і, крім того, зв’язок між змінними є лінійним.

Типи лінійної регресії

Існує два типи лінійної регресії :

- Проста лінійна регресія : одна незалежна змінна пов’язана із залежною змінною. Тому рівняння для моделі лінійної регресії такого типу має вигляд y=β 0 +β 1 x 1 .

- Множинна лінійна регресія : модель регресії має кілька пояснювальних змінних і змінну відповіді. Тому рівняння для моделі лінійної регресії цього типу має вигляд y=β 0 +β 1 x 1 +β 2 x 2 …+β m x m .

проста лінійна регресія

Проста лінійна регресія використовується для зв’язку однієї незалежної змінної з обома змінними.

Рівняння простої моделі лінійної регресії є прямою лінією, тому воно складається з двох коефіцієнтів: константи рівняння (β 0 ) і коефіцієнта кореляції між двома змінними (β 1 ). Отже, рівняння для простої моделі лінійної регресії має вигляд y=β 0 +β 1 x.

![]()

Формули для розрахунку простих лінійних коефіцієнтів регресії такі:

![Rendered by QuickLaTeX.com \begin{array}{c}\beta_1=\cfrac{\displaystyle \sum_{i=1}^n (x_i-\overline{x})(y_i-\overline{y})}{\displaystyle \sum_{i=1}^n (x_i-\overline{x})^2}\\[12ex]\beta_0=\overline{y}-\beta_1\overline{x}\end{array}](https://statorials.org/wp-content/ql-cache/quicklatex.com-459281504d26f92756115054ef567021_l3.png)

золото:

-

є константою лінії регресії.

-

– нахил лінії регресії.

-

є значенням незалежної змінної X даних i.

-

є значенням залежної змінної Y даних i.

-

є середнім значенням незалежної змінної

-

є середнім значенням залежної змінної Y.

Множинна лінійна регресія

У моделі множинної лінійної регресії включено щонайменше дві незалежні змінні. Іншими словами, множинна лінійна регресія дозволяє лінійно пов’язати кілька пояснювальних змінних зі змінною відповіді.

Рівняння для моделі множинної лінійної регресії має вигляд y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

золото:

-

є залежною змінною.

-

є незалежною змінною i.

-

є константою рівняння множинної лінійної регресії.

-

це коефіцієнт регресії, пов’язаний зі змінною

.

-

є помилкою або залишком, тобто різницею між спостережуваним значенням і значенням, оціненим за допомогою моделі.

-

загальна кількість змінних у моделі.

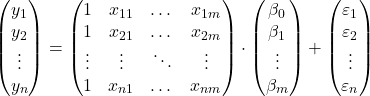

Отже, якщо у нас є вибірка із загальною кількістю

![]()

спостережень, ми можемо представити модель множинної лінійної регресії у матричній формі:

Наведений вище матричний вираз можна переписати, присвоївши літеру кожній матриці:

![]()

Таким чином, застосовуючи критерій найменших квадратів, ми можемо отримати формулу для оцінки коефіцієнтів моделі множинної лінійної регресії :

![]()

Однак застосування цієї формули є дуже трудомістким і трудомістким, тому на практиці рекомендується використовувати комп’ютерне програмне забезпечення (наприклад, Minitab або Excel), яке дозволяє набагато швидше створити модель множинної регресії.

Припущення лінійної регресії

У моделі лінійної регресії мають бути виконані такі умови, щоб модель була дійсною:

- Незалежність : Залишки повинні бути незалежними один від одного. Поширеним способом забезпечення незалежності моделі є додавання до процесу вибірки випадковості.

- Гомоскедастичність : дисперсії залишків повинні бути однорідними, тобто мінливість залишків має бути постійною.

- Немультиколінеарність : пояснювальні змінні, включені в модель, не можуть бути пов’язані одна з одною або, принаймні, їхній зв’язок має бути дуже слабким.

- Нормальність : залишки мають бути нормально розподілені, або, іншими словами, вони повинні відповідати нормальному розподілу із середнім 0.

- Лінійність : передбачається, що зв’язок між змінною відповіді та пояснювальними змінними є лінійним.

Для чого використовується лінійна регресія?

Лінійна регресія в основному має два застосування: лінійна регресія використовується для пояснення зв’язку між пояснювальними змінними та змінною відповіді, і аналогічно лінійна регресія використовується для прогнозування значення залежної змінної для нового спостереження.

Отримавши рівняння моделі лінійної регресії, ми можемо знати, який тип зв’язку існує між змінними в моделі. Якщо коефіцієнт регресії незалежної змінної додатний, залежна змінна зростатиме, коли вона зростатиме. тоді як, якщо коефіцієнт регресії незалежної змінної негативний, залежна змінна буде зменшуватися, коли вона зростатиме.

З іншого боку, рівняння, розраховане за допомогою лінійної регресії, також дозволяє робити прогнози вартості. Таким чином, вводячи значення пояснювальних змінних в рівняння моделі, ми можемо обчислити значення залежної змінної для нової частини даних.