Statistique Kappa de Cohen : définition & Exemple

La statistique Kappa de Cohen est utilisée pour mesurer le niveau d’accord entre deux évaluateurs ou juges qui classent chacun les éléments dans des catégories mutuellement exclusives.

La formule du kappa de Cohen est calculée comme suit :

k = (p o – p e ) / (1 – p e )

où:

- p o : Accord relatif observé parmi les évaluateurs

- p e : Probabilité hypothétique d’accord fortuit

Plutôt que de simplement calculer le pourcentage d’éléments sur lesquels les évaluateurs sont d’accord, le Kappa de Cohen tente de tenir compte du fait que les évaluateurs peuvent s’entendre sur certains éléments par simple hasard.

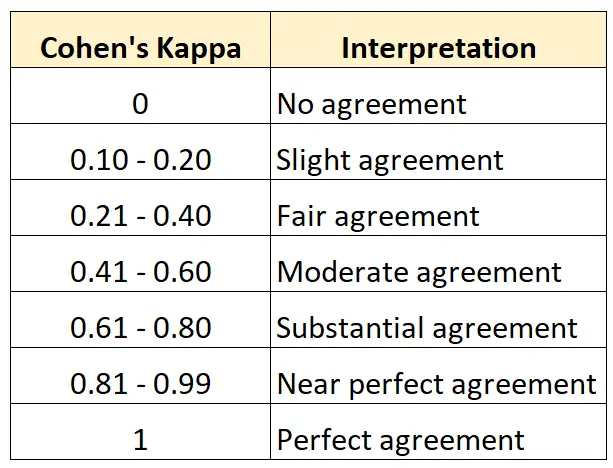

Comment interpréter le Kappa de Cohen

Le Kappa de Cohen se situe toujours entre 0 et 1, 0 indiquant l’absence d’accord entre les deux évaluateurs et 1 indiquant un accord parfait entre les deux évaluateurs.

Le tableau suivant résume la façon d’interpréter les différentes valeurs du Kappa de Cohen :

L’exemple suivant, étape par étape, montre comment calculer manuellement le Kappa de Cohen.

Calculer le Kappa de Cohen : exemple étape par étape

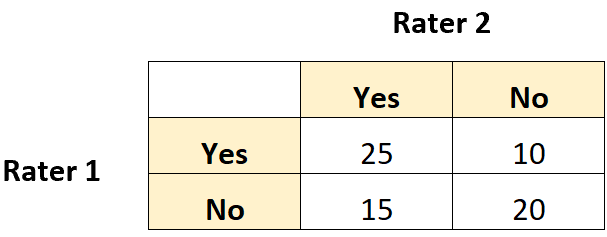

Supposons que l’on demande à deux conservateurs de musée d’évaluer 70 peintures pour savoir si elles sont suffisamment bonnes pour être exposées dans une nouvelle exposition.

Le tableau 2×2 suivant montre les résultats des évaluations :

Étape 1 : Calculer l’accord relatif (p o ) entre les évaluateurs.

Tout d’abord, nous calculerons l’accord relatif entre les évaluateurs. Il s’agit simplement de la proportion du total des notes pour lesquelles les évaluateurs ont tous deux répondu « Oui » ou « Non ».

Nous pouvons calculer cela comme suit :

- p o = (Les deux ont dit oui + Les deux ont dit non) / (Notes totales)

- p o = (25 + 20) / (70) = 0,6429

Étape 2 : Calculer la probabilité hypothétique d’un accord fortuit (p e ) entre les évaluateurs.

Ensuite, nous calculerons la probabilité que les évaluateurs aient pu se mettre d’accord par pur hasard.

Ceci est calculé comme le nombre total de fois où l’évaluateur 1 a dit « Oui », divisé par le nombre total de réponses, multiplié par le nombre total de fois où l’évaluateur 2 a dit « Oui », divisé par le nombre total de réponses, ajouté au total. nombre de fois où l’évaluateur 1 a dit « Non », multiplié par le nombre total de fois où l’évaluateur 2 a dit « Non ».

Pour notre exemple, cela se calcule comme suit :

- P(« Oui ») = ((25+10)/70) * ((25+15)/70) = 0,285714

- P(« Non ») = ((15+20)/70) * ((10+20)/70) = 0,214285

- p e = 0,285714 + 0,214285 = 0,5

Étape 3 : Calculer le Kappa de Cohen

Enfin, nous utiliserons p o et p e pour calculer le Kappa de Cohen :

- k = (p o – p e ) / (1 – p e )

- k = (0,6429 – 0,5) / (1 – 0,5)

- k = 0,2857

Le Kappa de Cohen s’avère être de 0,2857 . Sur la base du tableau précédent, nous dirions que les deux évaluateurs n’avaient qu’un niveau « assez » d’accord.

Ressources additionnelles

Vous pouvez utiliser cette calculatrice Kappa de Cohen pour calculer automatiquement le Kappa de Cohen pour deux évaluateurs.