Comment calculer le Kappa de Cohen dans R

En statistiques, le Kappa de Cohen est utilisé pour mesurer le niveau d’accord entre deux évaluateurs ou juges qui classent chacun des éléments dans des catégories mutuellement exclusives.

La formule du kappa de Cohen est calculée comme suit :

k = (p o – p e ) / (1 – p e )

où:

- p o : Accord relatif observé parmi les évaluateurs

- p e : Probabilité hypothétique d’accord fortuit

Plutôt que de simplement calculer le pourcentage d’éléments sur lesquels les évaluateurs sont d’accord, le Kappa de Cohen tente de tenir compte du fait que les évaluateurs peuvent s’entendre sur certains éléments par simple hasard.

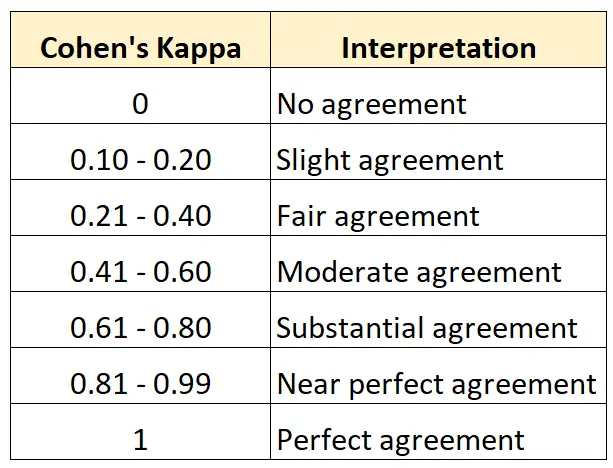

La valeur du Kappa de Cohen est toujours comprise entre 0 et 1 où :

- 0 indique aucun accord entre les deux évaluateurs

- 1 indique un accord parfait entre les deux évaluateurs

Le tableau suivant résume la façon d’interpréter les différentes valeurs du Kappa de Cohen :

Le moyen le plus simple de calculer le Kappa de Cohen dans R consiste à utiliser la fonction cohen.kappa() du package psych .

L’exemple suivant montre comment utiliser cette fonction dans la pratique.

Exemple : Calculer le Kappa de Cohen dans R

Supposons que l’on demande à deux conservateurs d’un musée d’art d’évaluer 15 peintures pour savoir si elles sont suffisamment bonnes pour être exposées dans une nouvelle exposition.

Le code suivant montre comment utiliser la fonction cohen.kappa() du package psych pour calculer le Kappa de Cohen pour les deux évaluateurs :

library(psych)

#define vector of ratings for both raters

rater1 = [0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0]

rater2 = [0, 0, 1, 1, 0, 1, 0, 0, 1, 1, 0, 1, 0, 1, 0]

#calculate Cohen's Kappa

cohen.kappa(x=cbind(rater1,rater2))

Cohen Kappa and Weighted Kappa correlation coefficients and confidence boundaries

lower estimate upper

unweighted kappa -0.14 0.34 0.81

weighted kappa -0.14 0.34 0.81

Number of subjects = 15

La colonne d’estimation affiche la valeur du Kappa de Cohen.

D’après le résultat, nous pouvons voir que le Kappa de Cohen s’avère être de 0,34 .

Sur la base du tableau précédent, nous dirions que les deux évaluateurs n’avaient qu’un niveau « assez » d’accord.

Si vous souhaitez calculer le niveau d’accord entre trois évaluateurs ou plus, il est recommandé d’utiliser plutôt le Kappa de Fleiss.

Ressources additionnelles

Les didacticiels suivants offrent des ressources supplémentaires sur le Kappa de Cohen :

Introduction au Kappa de Cohen

Calculateur Kappa de Cohen en ligne

Comment calculer le Kappa de Cohen dans Excel

Comment calculer le Kappa de Cohen en Python