Wann man die ridge- und lasso-regression verwenden sollte

Bei der gewöhnlichen multiplen linearen Regression verwenden wir einen Satz von p Prädiktorvariablen und eine Antwortvariable, um ein Modell der Form anzupassen:

Y = β 0 + β 1 X 1 + β 2 X 2 + … + β p

Die Werte von β 0 , β 1 , B 2 , …, β p werden mit der Methode der kleinsten Quadrate ausgewählt, die die Summe der Quadrate der Residuen (RSS) minimiert:

RSS = Σ(y i – ŷ i ) 2

Gold:

- Σ : Ein Symbol, das „Summe“ bedeutet

- y i : der tatsächliche Antwortwert für die i-te Beobachtung

- ŷ i : Der vorhergesagte Antwortwert für die i- te Beobachtung

Das Problem der Multikollinearität in der Regression

Ein Problem, das in der Praxis bei der multiplen linearen Regression häufig auftritt, ist die Multikollinearität – wenn zwei oder mehr Prädiktorvariablen stark miteinander korrelieren, sodass sie im Regressionsmodell keine eindeutigen oder unabhängigen Informationen liefern.

Dies kann dazu führen, dass Modellkoeffizientenschätzungen unzuverlässig werden und eine hohe Varianz aufweisen. Das heißt, wenn das Modell auf einen neuen Datensatz angewendet wird, den es noch nie gesehen hat, wird es wahrscheinlich eine schlechte Leistung erbringen.

Vermeidung von Multikollinearität: Ridge- und Lasso-Regression

Zwei Methoden, mit denen wir dieses Multikollinearitätsproblem umgehen können, sind die Ridge-Regression und die Lasso-Regression .

Die Ridge-Regression versucht Folgendes zu minimieren:

- RSS + λΣβ j 2

Die Lasso-Regression versucht Folgendes zu minimieren:

- RSS + λΣ|β j |

In beiden Gleichungen wird der zweite Term als Rückzugsstrafe bezeichnet.

Wenn λ = 0, hat dieser Strafterm keine Auswirkung und die Ridge-Regression und die Lasso-Regression erzeugen die gleichen Koeffizientenschätzungen wie die kleinsten Quadrate.

Wenn sich λ jedoch der Unendlichkeit nähert, wird der Schrumpfungsnachteil einflussreicher und Vorhersagevariablen, die nicht in das Modell importiert werden können, sinken gegen Null.

Bei der Lasso-Regression ist es möglich, dass einige Koeffizienten vollständig Null werden, wenn λ groß genug wird.

Vor- und Nachteile der Ridge- und Lasso-Regression

Der Vorteil der Ridge- und Lasso-Regression gegenüber der Regression der kleinsten Quadrate ist der Kompromiss zwischen Bias und Varianz .

Denken Sie daran, dass der mittlere quadratische Fehler (MSE) eine Metrik ist, mit der wir die Genauigkeit eines bestimmten Modells messen können. Er wird wie folgt berechnet:

MSE = Var( f̂( x 0 )) + [Bias( f̂( x 0 ))] 2 + Var(ε)

MSE = Varianz + Bias 2 + Irreduzibler Fehler

Die Grundidee der Ridge-Regression und der Lasso-Regression besteht darin, eine kleine Verzerrung einzuführen, sodass die Varianz deutlich reduziert werden kann, was zu einem insgesamt niedrigeren MSE führt.

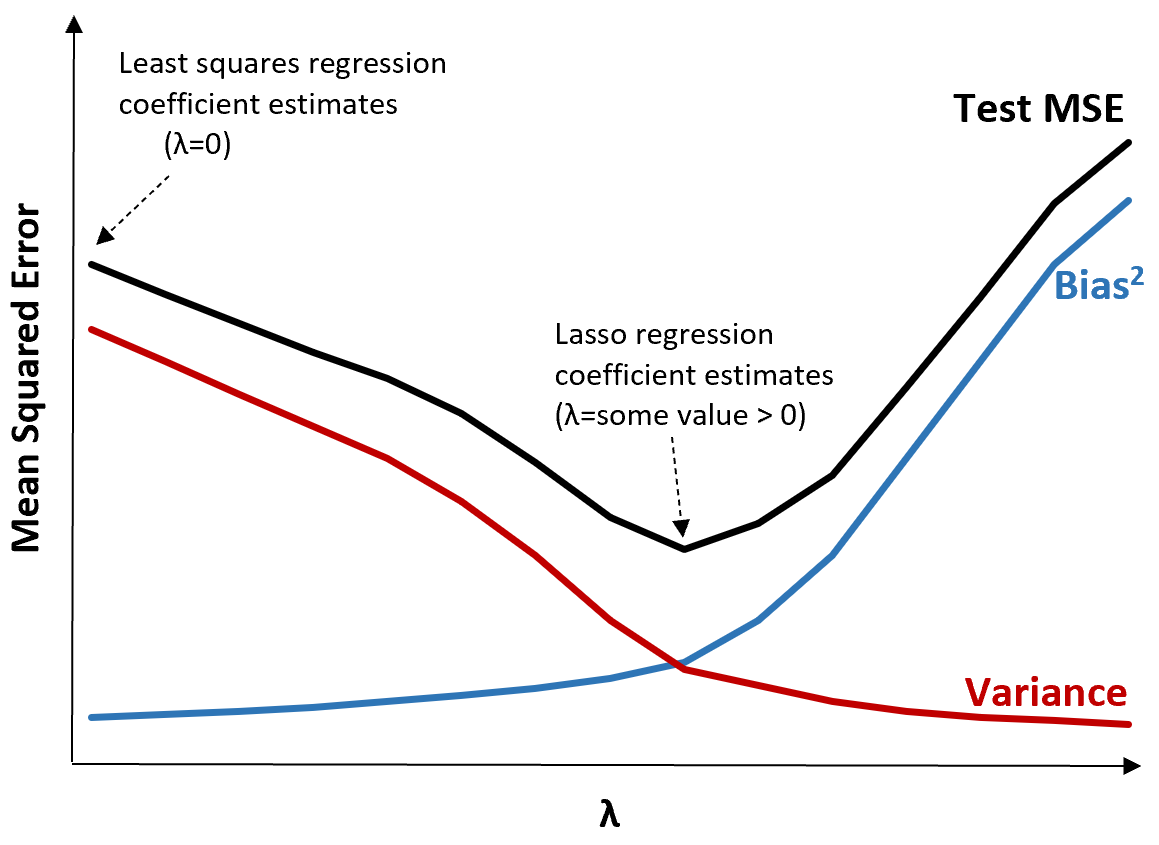

Betrachten Sie zur Veranschaulichung die folgende Grafik:

Beachten Sie, dass mit zunehmendem λ die Varianz bei einem sehr geringen Anstieg der Vorspannung deutlich abnimmt. Ab einem bestimmten Punkt nimmt die Varianz jedoch weniger schnell ab und die Verringerung der Koeffizienten führt zu einer deutlichen Unterschätzung derselben, was zu einem starken Anstieg der Verzerrung führt.

Aus der Grafik können wir ersehen, dass der MSE des Tests am niedrigsten ist, wenn wir einen Wert für λ wählen, der einen optimalen Kompromiss zwischen Bias und Varianz ergibt.

Wenn λ = 0, hat der Strafterm in der Lasso-Regression keine Auswirkung und erzeugt daher die gleichen Koeffizientenschätzungen wie die Methode der kleinsten Quadrate. Durch Erhöhen von λ auf einen bestimmten Punkt können wir jedoch den Gesamt-MSE des Tests reduzieren.

Dies bedeutet, dass die Modellanpassung durch Ridge- und Lasso-Regression potenziell zu geringeren Testfehlern führen kann als die Modellanpassung durch Regression der kleinsten Quadrate.

Der Nachteil der Ridge- und Lasso-Regression besteht darin, dass es schwierig wird, die Koeffizienten im endgültigen Modell zu interpretieren, da sie gegen Null schrumpfen.

Daher sollte die Ridge- und Lasso-Regression verwendet werden, wenn Sie die Vorhersagefähigkeit und nicht die Inferenz optimieren möchten.

Ridge vs. Lasso-Regression: Wann man sie jeweils verwendet

Lasso-Regression und Ridge-Regression werden als Regularisierungsmethoden bezeichnet, da sie beide versuchen, die verbleibende Quadratsumme (RSS) sowie einen bestimmten Strafterm zu minimieren.

Mit anderen Worten: Sie beschränken oder regulieren die Schätzungen der Modellkoeffizienten.

Dies wirft natürlich die Frage auf: Ist Ridge- oder Lasso-Regression besser?

In Fällen, in denen nur wenige Prädiktorvariablen signifikant sind, funktioniert die Lasso-Regression tendenziell besser, da sie in der Lage ist, unbedeutende Variablen vollständig auf Null zu reduzieren und aus dem Modell zu entfernen.

Wenn jedoch viele Prädiktorvariablen im Modell signifikant sind und ihre Koeffizienten ungefähr gleich sind, funktioniert die Ridge-Regression tendenziell besser, da alle Prädiktoren im Modell bleiben.

Um zu bestimmen, welches Modell für Vorhersagen am besten geeignet ist, führen wir normalerweise eine k-fache Kreuzvalidierung durch und wählen das Modell aus, das den niedrigsten quadratischen Mittelwertfehler des Tests erzeugt.

Zusätzliche Ressourcen

Die folgenden Tutorials bieten eine Einführung in die Ridge-Regression und die Lasso-Regression:

In den folgenden Tutorials wird erläutert, wie Sie beide Arten der Regression in R und Python durchführen: