La régression linéaire multiple

Cet article explique ce qu’est la régression linéaire multiple en statistique. De plus, vous découvrirez comment créer un modèle de régression linéaire multiple et comment il est interprété.

Qu’est-ce que la régression linéaire multiple ?

La régression linéaire multiple est un modèle de régression dans lequel deux ou plusieurs variables indépendantes sont incluses. En d’autres termes, la régression linéaire multiple est un modèle statistique qui permet de relier linéairement plusieurs variables explicatives à une variable de réponse.

Par conséquent, un modèle de régression linéaire multiple est utilisé pour trouver une équation qui relie deux ou plusieurs variables indépendantes à une variable dépendante. Ainsi, en substituant la valeur de chaque variable indépendante, une approximation de la valeur de la variable dépendante est obtenue.

Par exemple, l’équation y=3+6x 1 -4x 2 +7x 3 est un modèle de régression linéaire multiple, car elle relie mathématiquement trois variables indépendantes (x 1 , x 2 , x 3 ) avec une variable dépendante (y) de valeur linéaire chemin.

Formule de régression linéaire multiple

L’équation d’un modèle de régression linéaire multiple est y=β 0 +β 1 x 1 +β 2 x 2 +…+β m x m +ε.

![]()

Où:

est la variable dépendante.

est la variable dépendante. est la variable indépendante je.

est la variable indépendante je. est la constante de l’équation de régression linéaire multiple.

est la constante de l’équation de régression linéaire multiple. est le coefficient de régression associé à la variable

est le coefficient de régression associé à la variable .

. C’est l’erreur ou résidu, c’est-à-dire la différence entre la valeur observée et la valeur estimée par le modèle.

C’est l’erreur ou résidu, c’est-à-dire la différence entre la valeur observée et la valeur estimée par le modèle. est le nombre total de variables dans le modèle.

est le nombre total de variables dans le modèle.

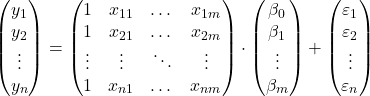

Donc si nous avons un échantillon avec un total de

![]() observations, nous pouvons proposer le modèle de régression linéaire multiple sous forme matricielle :

observations, nous pouvons proposer le modèle de régression linéaire multiple sous forme matricielle :

L’expression de tableau ci-dessus peut être réécrite en attribuant une lettre à chaque tableau :

![]()

Ainsi, en appliquant le critère des moindres carrés, il est possible d’arriver à la formule pour estimer les coefficients d’un modèle de régression linéaire multiple :

![]()

Cependant, l’application de cette formule est très laborieuse et prend beaucoup de temps, c’est pourquoi, en pratique, il est recommandé d’utiliser un logiciel informatique (tel que Minitab ou Excel) qui permet d’exécuter un modèle de régression multiple beaucoup plus rapidement.

Hypothèses de régression linéaire multiple

Dans un modèle de régression linéaire multiple, les conditions suivantes doivent être remplies pour que le modèle soit valide :

- Indépendance : les résidus doivent être indépendants les uns des autres. Une manière courante de garantir l’indépendance du modèle consiste à ajouter du caractère aléatoire au processus d’échantillonnage.

- Homoscédasticité : il doit y avoir une homogénéité dans les variances des résidus, c’est-à-dire que la variabilité des résidus doit être constante.

- Non-multicolinéarité : les variables explicatives incluses dans le modèle ne peuvent pas être liées entre elles ou, du moins, leur relation doit être très faible.

- Normalité : les résidus doivent être distribués normalement, ou en d’autres termes, ils doivent suivre une distribution normale de moyenne 0.

- Linéarité : On suppose que la relation entre la variable de réponse et les variables explicatives est linéaire.

Interprétation d’un modèle de régression linéaire multiple

Pour interpréter un modèle de régression linéaire multiple, il faut regarder le coefficient de détermination (R au carré), qui exprime le pourcentage expliqué par le modèle de régression. Ainsi, plus le coefficient de détermination est élevé, plus le modèle sera ajusté à l’échantillon de données étudié.

Cependant, la qualité de l’ajustement d’un modèle statistique peut être trompeuse, en particulier dans les modèles de régression linéaire multiple. Car lors de l’ajout d’une variable au modèle, le coefficient de détermination augmente, même si la variable n’est pas significative. Cependant, il faut maximiser le coefficient de détermination en essayant de minimiser le nombre de variables, puisque le modèle est moins compliqué et plus facile à interpréter.

Pour résoudre ce problème, il faut calculer le coefficient de détermination ajusté (R au carré ajusté), qui est un coefficient statistique qui mesure la qualité de l’ajustement d’un modèle de régression, pénalisant pour chaque variable ajoutée au modèle, contrairement au coefficient de détermination non ajusté. cela ne prend pas en compte le nombre de variables dans le modèle.

Ainsi, le coefficient de détermination ajusté nous permet de comparer la qualité de l’ajustement de deux modèles avec un nombre différent de variables. En principe, il faut choisir le modèle qui a un coefficient de détermination ajusté le plus élevé, mais si les deux modèles ont des valeurs très similaires, il est préférable de sélectionner le modèle avec le moins de variables car il est plus facile à interpréter.

En revanche, les coefficients de régression indiquent la relation entre la variable explicative et la variable de réponse. Si le coefficient de régression est positif, la variable de réponse augmentera lorsque la variable explicative augmentera. Alors que si le coefficient de régression est négatif, la variable de réponse diminuera lorsque la variable explicative augmentera.

Logiquement, pour que la condition précédente soit remplie, il faut que les autres variables restent constantes. C’est pourquoi il est important qu’il n’y ait pas de multicolinéarité entre les différentes variables explicatives du modèle. Vous pouvez voir comment la multicolinéarité d’un modèle est étudiée en recherchant l’article correspondant sur notre site Internet.

Régression linéaire multiple et simple

Enfin, nous verrons quelles sont les différences entre un modèle de régression linéaire simple et un modèle de régression linéaire multiple, puisque ce sont deux modèles de régression largement utilisés en statistique.

La régression linéaire simple est un modèle de régression utilisé pour relier une variable indépendante X à une variable dépendante Y. Autrement dit, dans une régression linéaire simple, il n’y a que deux variables : la variable explicative X et la variable de réponse Y. Donc l’équation d’une simple Le modèle de régression linéaire est le suivant :

![]()

Par conséquent, la différence entre la régression linéaire multiple et la régression linéaire simple réside dans le nombre de variables explicatives. Un modèle de régression linéaire multiple comporte deux variables explicatives ou plus, tandis qu’un modèle de régression linéaire simple n’a qu’une seule variable explicative.

![]()

En conclusion, la régression linéaire multiple est une extension de la régression linéaire simple, puisque davantage de variables explicatives et leurs coefficients de régression respectifs sont simplement ajoutés. Cependant, les coefficients de régression sont calculés différemment, pour voir comment cela se fait cliquez ici :